你離礁石越來越近,彷彿還有一秒就要觸礁了。

不過這張動圖,並不是從人類拍攝的視頻裏截下來的。

是Adobe放出的新魔法,把這張靜態照片變出了立體感,整個過程只需要2-3秒:

這種特效處理,常常用於紀錄片等視頻的後期製作,名爲Ken Burns Effect。

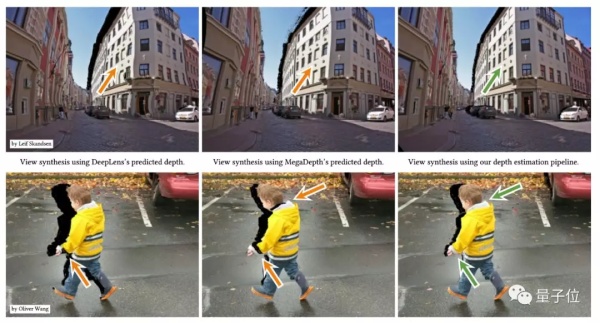

原本只是2D縮放 (下圖左) ,通過對靜止圖像的平移和縮放,來產生視差,從而實現動畫效果。

但Adobe這種3D效果 (上圖右) ,不僅有平移和縮放,還有視角轉換,給人更沉浸的體驗。

想要實現,需要專業的設計師在Photoshop等軟件中花費數個小時時間。

而且製作成本也很高,一張照片大概需要40-50美元 (約合人民幣280-350元) 。

Adobe也登上了ACM主辦的計算機圖形學頂級期刊TOG,引發了大量討論與關注。不乏有激動的網友給出「三連」:

Incredible. Amazing. Holy shit.

完全不是簡單的縮放

透視原理決定,前景比背景的移動/縮放更劇烈。

所以,前景移動的時候,背景除了移動,也要跟着修復。

AI的背景修復十分自然,手法明顯比「前輩」更高超:

並且,不論背景簡單複雜,AI都不怕。

比如,走到沙發跟前,沙發就擋住了後面窗戶外的草地:

背景的色彩和結構都很複雜,但AI並沒有矇蔽。

如果你覺得,剛纔的視角變化只是由遠及近,不夠複雜。那就看一眼這古老的臺階吧:

彷彿你打算走上臺階,所以正在朝着它的方向,慢慢轉身。

除此之外,一條古老的走廊,你置身其中,好像正在從上仰的視角,變得平視前方。

當然,不只是風景,人像也可以處理。

比如,草地上的新娘,可以遠觀,也可以近距離欣賞:

就像開頭說的那樣,所有的變換,只靠一張靜態圖來完成。

這自然不是普通的縮放可以做到的:

所以,究竟是怎樣的技術做到的?

三步定邊界,結合上下文感知

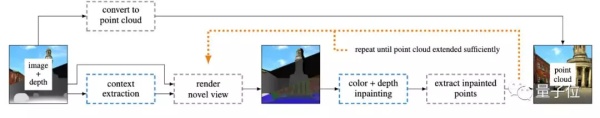

用單個圖像合成逼真的相機移動的效果要解決兩個基本問題。

首先,要設置一個新的相機位置,合成新視圖,並且需要準確地恢復原始視圖的場景幾何結構。

其次,根據預測的場景幾何結構,要將新視圖在連續的時間線上合成,這就涉及到去遮擋這樣的圖像修復手段。

研究人員們用了三個神經網絡來構建處理框架。

用以訓練的數據集是用計算機生成的。研究人員從UE4 Marketplace2收集了32種虛擬環境,用虛擬攝像機在32個環境中捕獲了134041個場景,包括室內場景,城市場景,鄉村場景和自然場景。每個場景包含4個視圖,每個視圖都包含分辨率爲512×512像素的顏色、深度和法線貼圖。

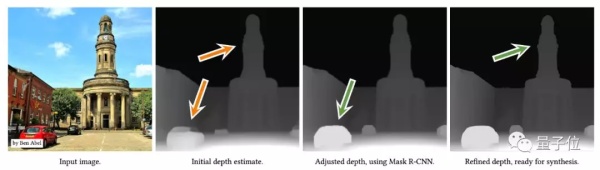

指定一張高分辨率圖像,首先根據其低分辨率版本估計粗糙深度。這一步由VGG-19來實現,根據VGG-19提取的語義信息指導深度估計網絡的訓練,並用具有地面真實深度的計算機合成數據集進行監督。如此,就能提取出原始圖像的深度圖。

第二個網絡,是Mask R-CNN。爲了避免語義失真,平行於VGG-19,用Mask R-CNN對輸入的高分辨率圖像進行分割,而後用分割的結果來對深度圖進行調整,以確保圖中的每個對象都映射到一個相干平面上。

最後,利用深度細化網絡,參考輸入的高分辨率圖像,對提取出的粗糙深度進行上採樣,確保深度邊界更加精確。

之所以要採用深度細化網絡,是因爲裁切對象的過程中,對象很可能在邊界處被撕開。

有了從輸入圖像獲得的點雲和深度圖(注:點雲指通過3D掃描得到的物品外觀表面的點數據集合),就可以渲染連續的新視圖了。

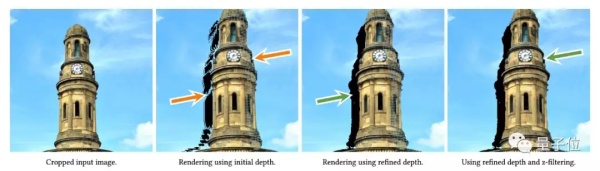

不過,這裏又會出現一個新的問題——當虛擬攝像機向前移動的時候,對象本身會產生裂隙(下圖中高塔右側像被網格切開了)。

爲了解決這個問題,研究人員採取了結合上下文感知修復的方法。

結合上下文信息能夠產生更高質量的合成視圖。上下文信息劃定了相應像素在輸入圖像中位置的鄰域,因此點雲中的每個點都可以利用上下文信息來進行擴展。

具體而言,第一步,是進行顏色和深度圖像修復,以從不完整的渲染中恢復出完整的新視圖,其中每個像素都包含顏色,深度和上下文信息。

而後,利用圖像修復深度,將圖像修復顏色映射到點雲中新的色調點。

重複這一過程,直到點雲充分擴展,填補空隙,可以實時地呈現完整且連續的畫面。

「用過都說好」

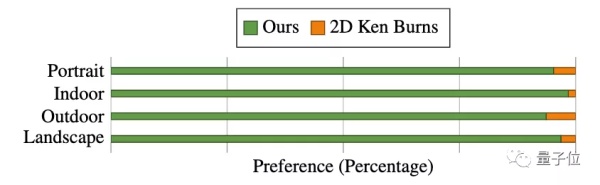

研究人員覺得好,那不算好。新方法效果如何,還是用戶說了算。

於是,研究團隊搞出了一個「非正式用戶調研」。他們在YouTube上搜集了30個人類創造的3D Ken Burns視頻,將其分成「風景」,「肖像」,「室內」,「人造室外環境」四組,每組隨機抽取三個視頻作爲樣本。

8位志願者參與到了這個測試之中。團隊爲每個志願者分配了一張靜態圖,並提供了人類作品作爲參考,要求志願者使用新方法和Adobe After Effects模板、移動App Viewmee這兩種Ken Burns製作工具創作類似的效果。

志願者會依據自己的主觀意見評價每種工具的可用性和質量。

在志願者們看來,不論是從效果上,還是易用性上,Adobe的這個新工具顯然好得多。

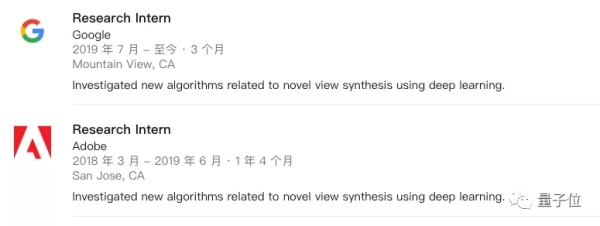

來自Adobe的實習生(現已轉Google)

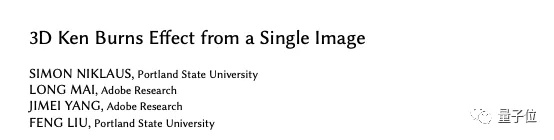

這項研究的第一作者,是一名波特蘭州立大學的博士生,名爲Simon Niklaus,研究方向爲計算機視覺與深度學習。

他在Adobe Research實習的時候完成了這項工作,目前他正在Google實習。

他的博士生導師,名爲Feng Liu,博士畢業於威斯康辛大學麥迪遜分校,現在是波特蘭州立大學的助理教授,也是這一研究的做作者之一。

此外,這項研究還有另外兩名作者,分別是Long Mai和Jimei Yang,都是Adobe的研究科學家。

Simon Niklaus在Hacker News上與網友互動時也談到了研究的開源計劃。

他說,自己計劃公佈代碼以及數據集,但還沒有得到批准。因爲這項工作是「實習生」完成的, Adobe在開源方面都比較大度。

當然,這也無法排除他們商業化的可能性,如果你對這一研究感興趣,可以先看下研究論文:

3D Ken Burns Effect from a Single Image

https://arxiv.org/abs/1909.05483

One more thing……

關於Ken Burns Effect,也有一段喬布斯的往事。

爲了將這一特效用到蘋果中,喬布斯還專程聯繫了Ken Burns,希望能夠得到他的許可。

一開始,Burns是拒絕的,他不想自己的名字被商業化。

但後來,Burns透露,他同意了喬布斯的請求。

這中間到底發生了什麼,也沒有太多信息傳遞出來。

現在,這一效應在iPhone中應用非常廣泛,比如照片的「回憶」功能,就能夠自動利用這一特效,把一張張照片製作成視頻。

這也給Burns帶來了很多「麻煩」。

他說,有時候自己走在街上,會有陌生人衝到他面前,說自己如何在iPhone上使用它,或者是問他問題。

對於這種情況,他說自己都是盡力快速逃離現場。跟明星遇上私生飯差不多。

emmm……

— 完 —

量子位 · QbitAI