圖像和視頻等視覺數據的生成是

機器學習和

計算機視覺領域重要的研究問題之一。近幾年,英偉達提出了 SPADE、MUNIT 等多個圖像及視頻合成模型。

近日,英偉達又開源了一個新的 PyTorch 庫「Imaginaire」,共包含 9 種英偉達開發的圖像及視頻合成方法。

項目地址:https://github.com/NVlabs/imaginaire

這九種方法分別爲:

1、pix2pixHD

2、SPADE/GauGAN

1、UNIT

2、MUNIT

3、FUNIT

4、COCO-FUNIT

1、vid2vid

2、fs-vid2vid

3、wc-vid2vid

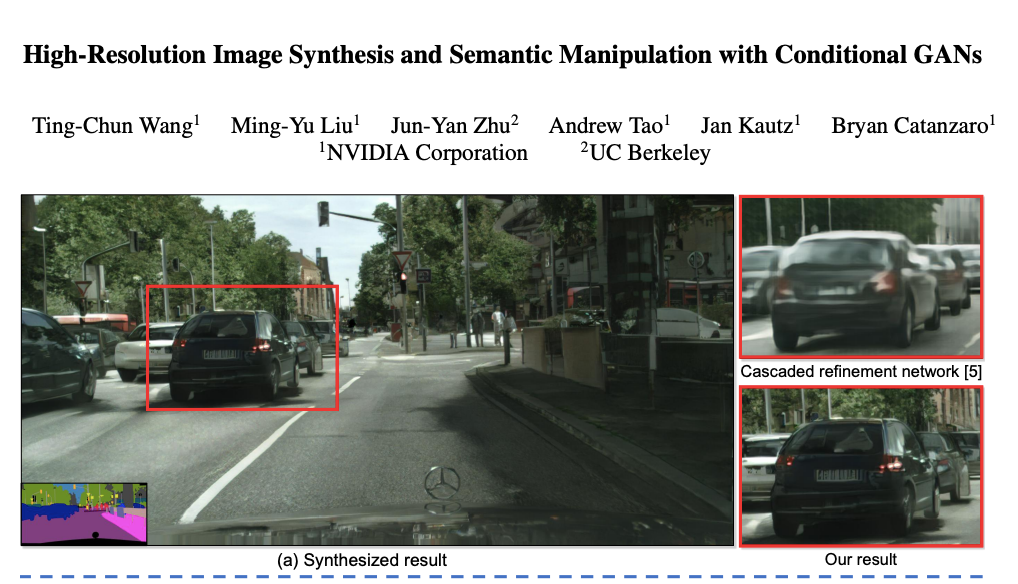

pix2pixHD

「pix2pixHD」是 pix2pix 的升級版本,具備高分辨率圖像和語義處理功能,主要解決了深度圖像合成編輯中的質量及分辨率問題。

項目主頁:https://tcwang0509.github.io/pix2pixHD/

論文鏈接:https://arxiv.org/pdf/1711.11585.pdf

在這篇論文中,來自英偉達和 UC 伯克利的研究者提出了一種使用條件 GAN 從語義標籤圖上合成高分辨率照片級逼真圖像的方法。此前,條件 GAN 已經有了很廣泛的應用,但生成結果均爲低分辨率並與現實差異較大。因此,研究者使用了一種新的對抗損失、多尺度生成器和判別器架構來生成 2048x1024 的結果。此外,研究者爲該框架擴展了兩個附加功能。首先,合併了對象

實例分割信息,實現了刪除 / 添加對象和更改對象類別等操作;其次,提出了一種在相同輸入下生成多種結果的方法,讓使用者可以編輯對象外觀。該論文被 CVPR 2018 接收。

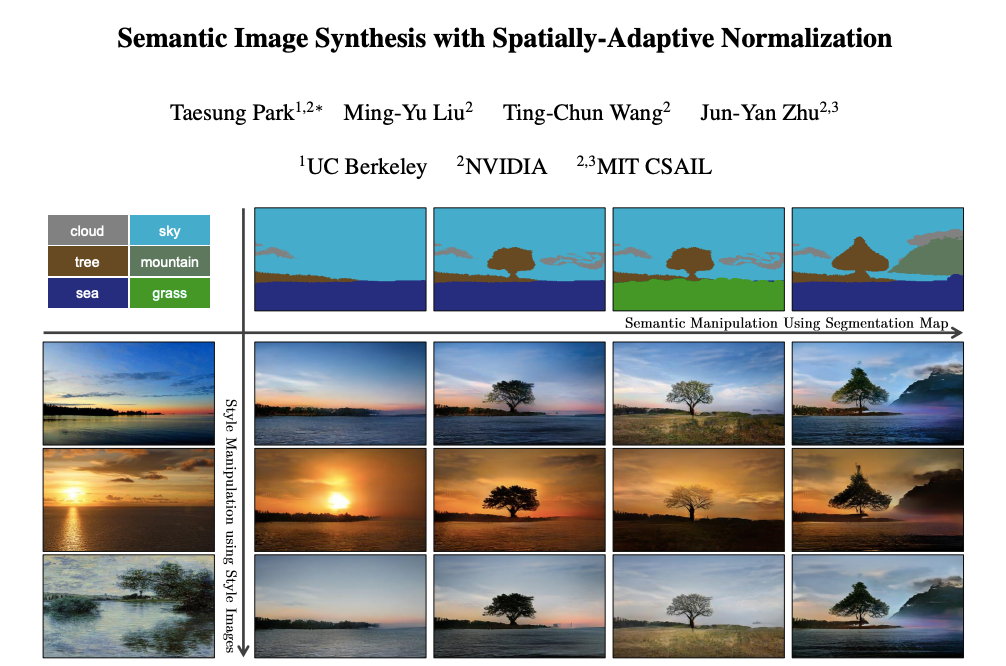

在 GTC 2019 上,英偉達展示了一款交互應用「GauGAN」。它可以輕鬆地將粗糙的塗鴉變成逼真的傑作,令人歎爲觀止,效果堪比真人攝影師作品。GauGAN 應用主要使用的技術,就是英偉達的 SPADE。

項目主頁:https://nvlabs.github.io/SPADE/

論文地址:https://arxiv.org/pdf/1903.07291.pdf

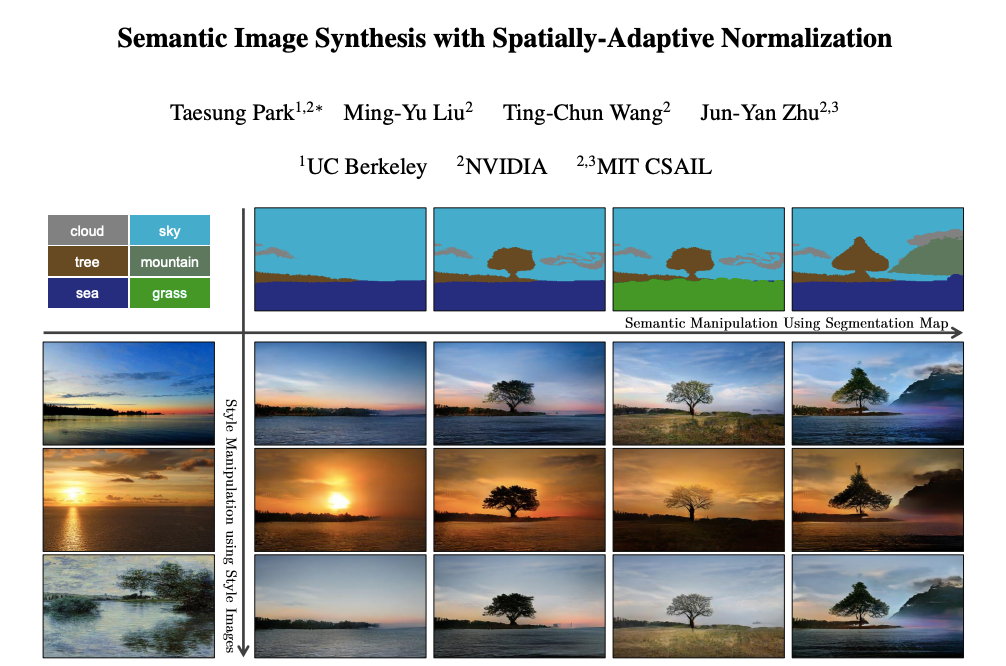

在

這篇論文中,來自 UC 伯克利、英偉達、MIT CSALL 的研究者提出了一種空間自適應歸一化方法,在給定輸入語義佈局的情況下,實現了一種簡單有效的逼真圖像合成層。以前的方法直接將語義佈局作爲輸入提供給深度網絡,然後通過卷積、歸一化和非線性層處理深度網絡。實驗表明,這種方法並不是最優的,因爲歸一化層傾向於「洗去」語義信息。爲了解決這個問題,研究者提出使用輸入佈局,通過空間自適應的、學習的轉換來調節歸一化層中的

激活函數。在幾個具有挑戰性的數據集上的實驗表明,與現有方法相比,該方法在視覺保真度和與輸入佈局的對齊方面具有優勢。最後,該模型允許用戶控制合成圖像的語義和風格。該論文被 CVPR 2019 接收爲 Oral 論文。

項目地址:https://github.com/NVlabs/imaginaire/tree/master/projects/unit

論文地址:https://arxiv.org/abs/1703.00848

UNIT(Unsupervised image-to-image translation)旨在通過使用來自單個域中邊緣分佈的圖像來學習不同域中圖像的聯合分佈。由於要達到給定的邊緣分佈需要一個聯合分佈的無限集,因此如果沒有其他假設,就無法從邊緣分佈推斷聯合分佈。爲了解決這個問題,研究者提出了一個共享潛在空間的假設,並提出了一個基於耦合 GAN 的無監督圖像到

圖像轉換框架。

無監督圖像到

圖像轉換是

計算機視覺領域一個重要而富有挑戰的問題:給定源域(source domain)中的一張圖像,需要在沒有任何配對圖像數據的情況下,學習出目標域(target domain)中其對應圖像的條件分佈。雖然條件分佈是多模態的,但此前方法都引入了過於簡化的假設,而將其作爲一個確定性的一對一

映射,因此無法在特定的源域圖像中生成富有多樣性的輸出結果。

項目地址:https://github.com/NVlabs/imaginaire/tree/master/projects/munit

論文地址:https://arxiv.org/abs/1804.04732

在

這篇論文中,康奈爾大學和英偉達的研究者提出了多模態無監督圖像到

圖像轉換 MUNT 框架。研究者假設,圖像表徵可以分解爲一個具有域不變性(domain-invariant)的內容碼(content code)和一個能刻畫域特有性質的風格碼(style code)。爲了將圖像轉化到另一個域中,研究者將:1. 原圖像的內容碼,2. 從目標域中隨機抽取的某個風格碼 進行重組,並分析了 MUNT 框架,並建立了相應的理論結果。大量實驗表明,將 MUNT 與其他 SOTA 方法相比具備優越性。最後,通過引入一個風格圖像(style image)樣例,使用者可以利用 MUNT 來控制轉化的輸出風格。

項目地址:https://github.com/NVlabs/imaginaire/tree/master/projects/funit

論文地址:https://arxiv.org/abs/1905.01723

雖然此前無監督圖像到

圖像轉換算法在很多方面都非常成功,尤其是跨圖像類別的複雜外觀轉換,但根據

先驗知識從新一類少量樣本中進行泛化的能力依然無法做到。具體來說,如果模型需要在某些類別上執行

圖像轉換,那麼這些算法需要所有類別的大量圖像作爲訓練集。也就是說,它們不支持 few-shot 泛化。總體而言有以下兩方面的限制:

其一,這些方法通常需要在訓練時看到目標類的大量圖像;

其二,用於一個轉換任務的訓練模型在測試時無法應用於另一個轉換任務。

在

這篇論文中,英偉達的研究者提出一種 Few-shot 無監督圖像到

圖像轉換(FUNIT)框架。該框架旨在學習一種新穎的圖像到

圖像轉換模型,從而利用目標類的少量圖像將源類圖像

映射到目標類圖像。也就是說,該模型在訓練階段從未看過目標類圖像,卻被要求在測試時生成一些目標類圖像。

項目地址:https://github.com/NVlabs/imaginaire/tree/master/projects/coco_funit

論文地址:https://nvlabs.github.io/COCO-FUNIT/paper.pdf

COCO-FUNIT 之前的圖像到圖像變換模型在模擬不可見域的外觀時很難保留輸入圖像的結構,這被稱爲內容丟失問題。當輸入圖像和示例圖像中對象的姿勢有較大差異時,這個問題尤其嚴重。爲了解決這個問題,研究者提出了一種新的 few-shot 的圖像變換模型,即 COCO-FUNIT。

2018 年,英偉達聯合 MIT CSAIL 開發出了直接視頻到視頻的轉換系統。該系統不僅能用

語義分割掩碼視頻合成真實街景視頻,分辨率達到 2K,能用草圖視頻合成真實人物視頻,還能用姿態圖合成真人舞蹈視頻。此外,在

語義分割掩碼輸入下,只需換個掩碼顏色,該系統就能直接將街景中的樹變成建築。

項目主頁:https://tcwang0509.github.io/vid2vid/

論文地址:https://arxiv.org/abs/1808.06601

在

這篇論文中,來自英偉達和 MIT 的研究者提出了一種新型的

生成對抗網絡框架下的

視頻到視頻合成方法。通過精心設計生成器和判別器架構,結合空間 - 時間對抗

目標函數,研究者在多種輸入視頻格式下生成了高分辨率、時間連貫的照片級視頻,其中多種形式的輸入包括分割掩碼、草圖和姿態圖。在多個

基準上的實驗結果表明,相對於強基線,本文方法更具優越性,該模型可以合成長達 30 秒的 2K 分辨率街景視頻,與當前最佳的視頻合成方法相比具備顯著的優勢。研究者將該方法應用到未來

視頻預測中,表現均超越其他方法。該論文被 NeurIPS 2018 接收。

「vid2vid」旨在將人體姿態或分割掩模等輸入的語義視頻,轉換爲逼真的輸出視頻,但它依然存在以下兩種侷限:其一,現有方法極其需要數據。訓練過程中需要大量目標人物或場景的圖像;其二,學習到的模型泛化能力不足。姿態到人體(pose-to-human)的 vid2vid 模型只能合成訓練集中單個人的姿態,不能泛化到訓練集中沒有的其他人。

2019 年,英偉達又推出了新的「few-shot vid2vid」框架,僅藉助少量目標示例圖像就能合成之前未見過的目標或場景的視頻,在跳舞、頭部特寫、街景等場景中都能得到逼真的結果。

項目主頁:https://nvlabs.github.io/few-shot-vid2vid/

論文地址:https://arxiv.org/pdf/1910.12713.pdf

在

這篇論文中,英偉達的研究者提出了一種 few-shot vid2vid 框架,該框架在測試時通過利用目標主體的少量示例圖像,學習對以前未見主體或場景的視頻進行合成。

藉助於一個利用

注意力機制的新型網絡

權重生成模塊,few-shot vid2vid 模型實現了在少樣本情況下的泛化能力。研究者進行了大量的實驗驗證,並利用人體跳舞、頭部特寫和街景等大型視頻數據集與強

基準做了對比。

實驗結果表明,英偉達提出的 few-shot vid2vid 框架能夠有效地解決現有方法存在的侷限性。該論文被 NeurIPS 2019 接收。

「World Consistent vid2vid」是英偉達在 2020 年 7 月推出的一種

視頻到視頻合成方法。vid2vid 視頻編碼方法能夠實現短時間的時間一致性,但在長時間的情況下不能時間一致性。這是因爲對 3D 世界渲染方式缺乏瞭解,並且只能根據過去的幾幀來生成每一幀。

項目主頁:https://nvlabs.github.io/wc-vid2vid/

論文地址:https://arxiv.org/pdf/2007.08509.pdf

在這篇論文中,英偉達的研究者引入了一個新的視頻渲染框架,該框架能夠在渲染過程中有效利用過去生成的所有幀,來改善後續視頻的合成效果。研究者利用「制導圖像」,並進一步提出了一種新的

神經網絡結構以利用存儲在制導圖像中的信息。一系列實驗結果表明,該方法具備良好表現,輸出視頻在 3D 世界渲染上是一致的。