選自Medium

作者:Yusaku Sako

去年 12 月 8 日,英偉達在 NIPS 2017 大會的一次活動中發佈了最新消費級旗艦顯卡 Titan V——Volta 架構,包含最新的神經網絡計算單元 Tensor Core。英偉達宣稱這塊最新 Titan 旗艦的性能可達上一代產品(Titan Xp)的九倍。這款售價高達 3000 美元的顯卡是否值得購買?隨着 Titan V 陸續進入用戶手中,已有人對其進行了評測。

Titan V 是英偉達最近推出的「桌面級」GPU,基於新一代 Volta 架構(12nm 工藝),擁有 211 億個晶體管、12 GB 的 HBM2 顯存,可以提供 110 TFLOPS 的「深度學習算力」,對於單塊顯卡而言,這是一個驚人的數字。相比之下,此前的最強顯卡 GeForce 1080 Ti 可以輸出 11 TFLOPS「常規算力」,內存爲 11GB DDR5,而售價則是相對親民的 699 美元。

Titan V 身上的數字看起來非常 exciting,其 2999 美元的售價雖然有點難以讓人接收,但其接近 10 倍的算力提升是最大的賣點,我們能否用一塊 Titan V 代替 10 塊 1080 Ti?或者說,從價格來看,它能否超過 4 塊 1080 Ti?

另一方面,英偉達 DGX 計算站現在的售價也下調至 49900 美元(原價 69900 美元)。這種設備內含 4 塊水冷服務器級計算芯片 Tesla V100,這種芯片理論上性能強於桌面級的 Titan V(雖然價格要貴上很多,但其中應該包含技術支持和整套服務級協議)。儘管如此,大多數人(包括大量學校和科技公司的 AI Lab)是不會準備這種數量級的經費用於 GPU 的。即使這樣的設備也在考慮範圍之內,我們也要先討論一下性價比的問題。

所以我們的問題是,Titan V 是不是當前構建深度學習環境最爲值當的選擇?

讓我們從頭說起,Titan V 和它服務器級的親屬 Tesla V100 都是在去年推出的(V100 在 2017 年 5 月份推出,而 Titan V 在 12 月推出)。大多數深度學習架構已經加入了對 Volta 架構的支持,確保其 Tensor Core 的潛力在模型訓練時充分發揮。

例如,PyTorch 在近期發佈了 0.3.0 版本,加入了 CUDA 9 和 Volta 架構 GPU 的支持。在我近期對於新硬件的測試中,PyTorch 社區提供了很大幫助。我已經在用 Titan V 運行 PyTorch 神經網絡框架上的程序了,目前的一些測試程序可以用來對比硬件性能的差異。目前,我只能給出基於 PyTorch 0.3.0 的基準測試,我會在未來加入其他框架下的性能對比,這些測試將基於 CUDA 9.0.176 和 CuDNN 7.0.0.5,也有可能在這些 API 之外。

Titan V 與 1080 Ti 的性能測試對比

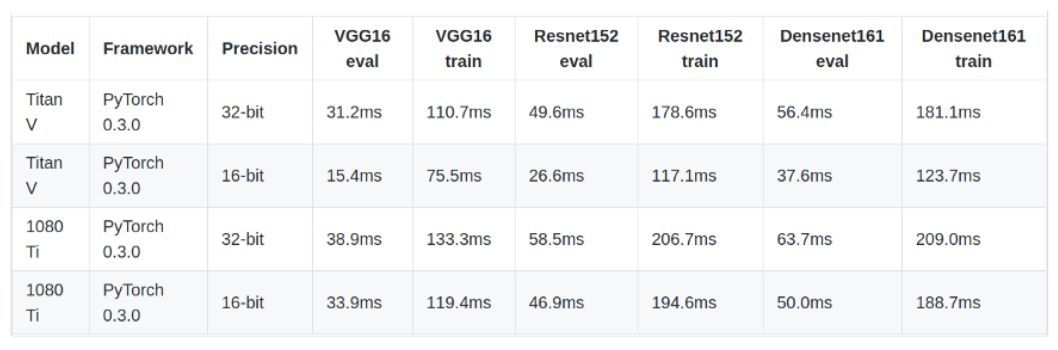

我們讓 Titan V 和 GeForce 1080 Ti 在相同的設置下進行了對比測試(這些顯卡在同樣的計算機上經過了測試,都插在了 16x PCIE 接口上)。

上表中顯示的時間是 CNN 前向傳播(eval)和反向傳播(train)所需的時間,以毫秒計。這些數字是超過 10 次操作的平均值,因爲運算過多次,所以該數字相對穩定。

其中有趣的地方在於:

顯然,Titan V 的速度要快於 GeForce 1080 Ti。然而如果僅比較 32-bit 位的運算(單精度),Titan V 僅比 1080 Ti 快 20% 左右。

Titan V 在 16-bit 運算(半精度)上的運行速度要比 32-bit 位的運算速度快上很多。1080 Ti 也可以從半精度設置上受益,但速度提升相比 Titan V 而言較爲平滑。

這些數字告訴我們「無腦選 Titan V」並不一定是對的。

關於接近 10 倍的算力提升,英偉達說謊了嗎?我確定他們的營銷人員是誠實優秀的人,但是這裏存在多個因素。一,我確定從軟件的角度來看,充分利用 Volta 超快的 Tensor Core 還有改進空間。但是即便如此,如果大部分代碼路徑不符合允許最大理論性能的條件,商家宣稱的大幅度性能提升就有待商榷了。時間會告訴我們在框架/CUDA/CuDNN 級別可以有多大改進來充分利用 Volta GPU 的能力,但是我在常見的 CNN 上(我專注於計算機視覺,所以在這裏使用卷積神經網絡進行了測試)觀察到的初始值似乎並不足以證明值得去升級成 Titan V,尤其是「買一個 Volta GPU,模型就能跑得起來」這種情況並不會出現。

儘管使用最新技術很有趣(先買先享受),但如果你使用個人 GPU 進行 AI 研究或構建產品,那麼我建議你繼續使用 GeForce 1080 Ti(直到英偉達不久之後發佈更好、更合適的產品,GeForce 2080 Ti?)。此外,單塊 Titan V 內存只有 12GB,1080 Ti 內存稍小,有 11GB。但是如果你用單個 Titan V 的錢買四個 1080 Ti(注意:爲此你還需要更強大的電源、可支持 4 個 GPU 的主機、更大的 RAM,以及更好的冷卻系統等),那麼你將擁有更多的顯存(44GB vs 12GB)。

如果你需要不止一個 GPU,那麼更實際的方法是買 2 個 1080 Ti。這樣,GPU 就不會一個一個地堆疊起來(堆疊需要更多的氣流才能冷卻,如果多個 GPU 熱量過大,則性能損失會很嚴重……你可以採取水冷的方式,但該方法大幅增加成本和風險)。另外,如果只有兩個顯卡,那顯卡所需電量是 250Wx2,這樣你就不必擔心供電不足。不管怎樣,我發現擁有多個 GPU 並進行獨立實驗是一種性價比較高的做法,這樣我可以快速迭代,因此我推薦此方法作爲折中方案。

解決堆疊、空氣冷卻 GPU 的發熱問題的另一種方法是,如果你必須使用 3-4 個 GPU,且不想使用水冷卻,同時也不關心美感或噪聲,那麼大可以買一些 PCIE 擴展槽/立管,遵循這位 Kaggle 競賽冠軍的做法:

Vladimir Iglovikov(2017 年 Carvana Image Masking Challenge 冠軍團隊成員之一)搭建的 4x 1080 Ti 機器。

原文地址:https://medium.com/@u39kun/titan-v-vs-1080-ti-head-to-head-battle-of-the-best-desktop-gpus-on-cnns-d55a19866b7c