前言:深度神經網絡由許多單獨的神經元組成,它們以複雜且違反人直覺的方式組合起來,以解決各種具有挑戰性的任務。這種複雜性一方面賦予神經網絡神祕力量,另一方面,也讓它們變成了人類難懂的黑匣子。

瞭解神經網絡的深層功能對於解釋它們是如何做決定至關重要,並且能幫我們構建更強大的系統。就像,你不瞭解各個齒輪如何配合工作,你在試圖做一個鐘錶時就很困難。

要想理解神經科學和深度學習中的神經網絡,一種方法是弄清單個神經元的作用,尤其是那些易於解釋的神經元。

DeepMind最新的一篇關於神經網絡學習的論文《On the Importance of Single Directions for Generalization》(https://arxiv.org/abs/1803.06959)將投稿在第六屆 ICLR(國際學習表徵會議)。這項研究所採用的方法是受數十年臨牀神經系統科學的啓發,通過探索損傷神經元的影響來確定小規模神經元組對神經網絡的重要性。深度神經網絡中的那些越容易解釋的神經元對神經網絡的計算性能越重要嗎?

研究人員通過刪除單個神經元或神經元組來衡量它是否對網絡的性能產生了影響。這項實驗有了兩個令人驚訝的發現:

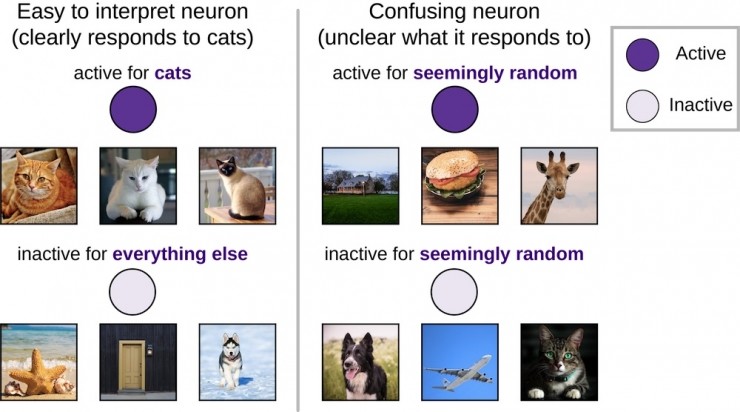

雖然以前的許多研究集中於易理解,可解釋的單個神經元(例如「貓神經元」,或深層網絡的隱藏層中的神經元,它們只對貓的圖像有反應),但我們發現這些可解釋的神經元和那些難以理解,不可描述的神經元對神經網絡的影響,並沒什麼不同。

在同樣刪除神經元的情況下,能正確分類沒見過的圖像的網絡比僅能對看到過的圖像進行分類的網絡恢復的更快。換句話說,推理性好的網絡比那些單純的記憶網絡更不依賴於單一方向。

「貓神經元」可能更易解釋,但它們並不重要

在神經科學和深度學習中,廣泛分析了僅對單一輸入類別的圖像(例如狗)作出響應的易解釋神經元(「選擇性」神經元)。這導致了在深度學習中對貓神經元,情緒神經元和括號神經元過度強調它們的重要性; 在神經科學中,對例如詹妮弗安妮斯頓神經元,以及一些類似的神經元的過度強調等等。然而,這些佔少數的高選擇性神經元,以及大多數低選擇性、更令人費解且難以解釋的神經元之間,哪種相對更重要仍然未知。

原句好拗口啊……

具有明顯響應模式(例如,對貓活躍,對其他所有活動不活躍)的神經元比那些隨着圖像隨機活動或不活動的令人難理解的神經元更容易解釋。

爲了評估神經元的重要性,研究人員測量了當神經元被刪除時,圖像分類任務的網絡性能是如何變化。 如果一個神經元是非常重要的,刪除它應該是具有高度破壞性的並且大大降低網絡性能,而刪除一個不重要的神經元應該沒有什麼影響。 神經科學家經常進行類似的實驗,儘管它們很難在人造神經網絡中獲得這些實驗所必需的細粒度和精確度。

上圖是在一個簡單神經網絡上刪除神經元產生影響的概念圖,較深的神經元更活躍。 需要注意的是,刪除一個或兩個神經元對輸出影響很小,而刪除大部分神經元會產生很大的影響,並且一些神經元比其他神經元更重要!

令人驚訝的是,研究員發現神經網絡的選擇和重要性之間幾乎沒有關係。換句話說,「貓神經元」並不比令人難解的神經元更重要。這一發現與最近在神經科學方面的工作相呼應,已經證明令人難解的神經元實際上可以提供豐富的信息,並且表明今後在探索上必須超越最易於解釋的神經元,以便理解深度神經網絡。

雖然「貓神經元」可能更易解釋,但它們並不比那些難解釋,沒有明顯偏好的神經元更重要。 上圖反映了我們所期望的重要性和解釋性之間的不同關係!

儘管可解釋神經元在直覺上更容易理解(比如,「它喜歡狗」),但它們並沒有比那些沒有明顯偏好的難解釋神經元更重要。

推理性好的網絡很難打破

我們試圖構建智能系統,如果系統能夠推理出新的場景,我們只能稱之爲系統智能。例如,一個圖像分類網絡只能對以前看過的特定狗圖像進行分類,而不能對同一只狗的新圖像進行分類,這個網絡是沒有價值的。只有在新樣本中依然能智能分類,這些系統才能獲得它們的效用。去年,Google Brain、Berkeley 和 DeepMind 合作的論文在 ICLR 2017 上獲得最佳論文,表明深層網絡可以簡單地記住他們接受訓練的每個圖像,而不是以更像人類的方式在學習(例如,瞭解抽象的「狗」概念)。

然而,網絡是否已經學會了一種能夠推理到新的任務場景中的解決方案,這往往是不清楚的。通過逐漸刪除越來越大的神經元組,研究員發現,相比於簡單記憶在訓練期間看到的圖像的網絡,具有良好泛化能力的網絡對刪除神經元組後的穩健性要強得多。換句話說,泛化好的網絡很難被打破(儘管它們肯定還是會被打破的)。

通過以這種方式衡量網絡的穩健性,可以評估一個網絡是否在利用簡單的記憶來「欺騙」人類。瞭解網絡在記憶過程中是如何變化的將有助於建立新網絡,網絡記憶越少,推理性就越強。

神經科學啓發分析

總之,這些發現證明了使用基於臨牀神經科學啓發的技術來理解神經網絡的力量是可行的。 使用這些方法,發現高選擇性個體神經元並不比非選擇性神經元更重要,並且那些廣義的網絡比單純記憶訓練數據的網絡更不依賴於單個神經元。 這些結果意味着單個神經元的重要性可能看起來的那麼重要。通過努力解釋所有神經元的作用,而不僅僅是那些易於解釋的神經元,我們希望更好地理解神經網絡的內部工作,最關鍵的是,利用這種理解來構建更加智能和通用的系統。

論文地址:https://arxiv.org/abs/1803.06959

ICLR 2017最佳論文:https://arxiv.org/abs/1611.03530

via DeepMind