摘要

我們提出一種新型向量表示法,將詞彙對比法與分佈式向量相結合,增強用於確定詞彙相似度的最凸顯的特徵。在性能方面,這些經過調整的向量表示法在很大程度上超過了標準的向量模型,實現了跨詞類(形容詞,名字,動詞)區分反義詞與同義詞這兩種語義關係,平均精確度達到0.66-0.76。此外,我們把詞彙對比向量整合入基於skip-gram模型的目標函數中。該新型向量表示法在運用SimLex-999預測詞彙相似度與區分反-同義詞兩個方面均優於state-of-the-art模型。

1. 引言

反義詞與同義詞,作爲兩種詞彙語義關係,是心理詞彙的重要組成部分(Miller & Fellbaum,1991)。對於意義相反的兩個詞語,我們稱之爲反義詞,對於意義相同的兩個詞語,我們稱之爲同義詞(Deese,1965;Lyons,1977)。從計算的角度來講,區分反義詞與同義詞對於NLP應用具有非常重要的作用,比如,機器翻譯和文本蘊含,這些應用都超出普通意義上的語義關聯,要求能夠識別具體的語義關係。然而,由於有些詞語可以相互替換,反義詞與同義詞經常出現於相似的語境中,如此便增加了區分這兩類詞的難度。

分佈式語義模型(DSMs)提供了一種詞語意義向量的表示方法,這種向量表示法決定了詞語之間的語義關係(Budanitsky & Hirst,2006;Turney & Pantel, 2010)。分佈式語義模型以「分佈假說」(Harris, 1954;Firth, 1957)爲基礎,該假說主張具有相似分佈特點的詞語之間存在語義關聯。爲了便於計算,每一個詞語由一個權重特徵向量表示,這些特徵一般與出現在某一特定語境中的詞彙緊密相關。然而,DSMs可以檢索同義詞(例如,formal與conventional)與反義詞(例如,formal與informal)爲具有語義關聯的詞語,卻無法進一步充分區分這兩種語義關係。

近年來,有大量分佈方式被用於區分反義詞與同義詞,通常情況下,這些分佈方法多與詞彙資源,如詞典或分類法,相結合。例如,Lin等(2003)利用依存三元組提取具有相似分佈特徵的詞彙,在後續過程中剔除那些經常以「從x至Y」或「x或y」分佈方式出現的詞彙。Mohammad等(2013)認爲,出現在相同詞典分類法中的詞對之間在意義上具有緊密聯繫,將其標註爲同義詞,相反,那些經常出現在相反的詞典分類法或段落中的詞對被標註爲反義詞。Scheible等(2013)認爲,依據適當的語義特徵,並運用一個簡單的詞彙空間模型便可以區分反義詞與同義詞這兩種語義關係的分佈特徵。Santus 等(2014a,2014b)的研究目的在於運用向量表示法識別最明顯的意義維度,並報道了一種新的基於平均精度的分佈式測量方法與一種基於熵的測量方法,以區分反義詞與同義詞這兩種語義關係(進一步區分聚合型語義關係)。

近來,區分反義詞-同義詞也已經成爲詞彙向量模型的研究重點。例如,Adel與Schutze(2014)將從大型語料庫中提取的核心參考鏈整合入skip-gram模型中,旨在生成詞彙向量,區分同義詞。Ono等人(2015)提出基於詞典的詞彙向量表示法,以識別反義詞。在研究過程中運用了兩種模型:根據詞典信息訓練詞彙向量的WE-T模型與將分佈信息整合入WE-T模型中的WE-TD模型。Pham 等人(2015)介紹了一種多任務詞彙對比模型,該模型將「WordNet」併入skip-gram模型,優化語義向量,以預測語境信息。這種模型在兩種普通的語義任務中提供否定樣例,並區分反義詞與同義詞,在性能上優於標準的skip-gram模型。

我們在本文提出了兩種利用分佈式語義空間中詞彙對比信息和詞彙向量的方法,旨在區分反義詞與同義詞。首先,在假定同義詞之間的語義重疊要多與反義詞之間的語義重疊,我們將詞彙對比信息與分佈式向量相結合,增強可以確定詞彙相似度的最爲凸顯的詞彙特徵。其次,我們針對skip-gram模型,運用否定樣例擴展該模型 (Mikolov等,2013b),獲得新模型將詞彙對比信息整合併入目標函數。有我們提出的新模型通過優化語義向量來預測詞彙相似度,同時也區分反義詞與同義詞。在完成區分反義詞-同義詞和識別詞彙相似度任務中,經改進的詞彙向量表示法要優於state-of-art模型。

2. 我們的方法

在本部分,我們將列舉本篇文章的兩點貢獻:一種能夠改善權重特徵,以區分反義詞與同義詞的新型向量表示法(見2.1),一種將經改進後的向量表示法整合併入目標函數,以預測詞彙相似度,識別反義詞的skip-gram擴展模型(見2.2)。

2.1 改進特徵向量的權重

當區分詞彙之間的相似度時,通過增強那些最凸顯的向量特徵且不過分強調那些不太重要的向量特徵,以改善特徵向量的權重,這是我們的研究目的。我們由標準語料庫中詞彙的共現頻率着手,運用局部共享信息,以確定詞彙特徵的原始長度。我們的得分 隨後定義目標詞w和特徵f:

隨後定義目標詞w和特徵f:

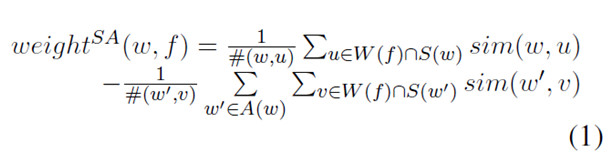

目標詞w和特徵f的新weightSA分數計算法運用同義詞與目標詞之間平均相似度的差異,及反義詞與目標詞之間的平均相似度。只有那些包含在計算過程中的詞彙纔對應特徵f擁有一個肯定的原始LMI分數。我們用距離的餘弦值來計算兩個詞彙向量之間的相似度。倘若詞彙w與我們所用詞彙資源中的任意的同義詞或反義詞均沒有關聯,或倘若一種語義特徵與詞彙w之間不存在共現關係,我們定義結果爲零。

我們的新weightSA計算過程中的詞彙對比信息的依據如下。一個詞彙的最凸顯的語義特徵也可能代表其同義詞的最爲明顯的語義特徵,但是卻代表其反義詞的最不明顯的語義特徵。例如,特徵conception僅與形容詞formal的同義詞共現,與其反義詞informal或informal 的同義詞不會同時出現。Formal與其同義詞之間的平均相似度減去informal與其同義詞之間的平均相似度,得到的weightSA (formal, conception)應當爲一個高正值。相反,特徵,如issue,可以與許多不同的形容詞共現,其特徵值對應的weightSA(formal, issue)應當逼近零,因爲formal與其同義詞之間的平均相似度極大。最後,特徵,如rumor僅與informal及其同義詞共現,而不與原始目標形容詞formal及其同義詞共現,該特徵對應的weightSA(formal, rumor)應當很低。表格1爲計算目標formal的新weightSA提供了圖式結果。

由於反義詞的數量一般少於同義詞的數量,我們將進一步擴展反義詞的數量:我們將一個反義詞的所有同義詞看作該詞彙的反義詞。例如,與其31個同義詞相比,目標詞good在WordNet中僅有兩個反義詞(bad和evil)。因而,我們也用bad與evil的同義詞作爲good的反義詞。

圖1:目標形容詞formal 的分數計算的圖解。

2.2 將分佈式詞彙對比法整合併入skip-gram 模型中

我們提出的模型以Levy 和Goldberg (2014)的模型爲基礎,其模型指出否定樣例skip-gram 模型的目標函數應定義如下:

方程2中的第一個表達式代表在一個語境窗口中目標詞w與語境c共現。目標詞出現的次數與出現的語境被定義爲#(w,c)。第二個表達式表示否定樣例,其中k表示否定樣本詞彙的數量,#(w)表示目標詞w出現的次數。

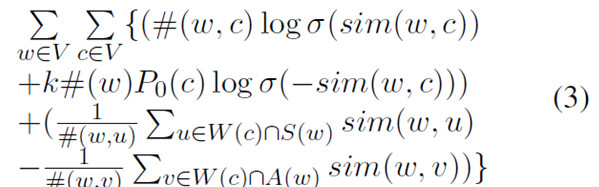

爲了能夠將詞彙對比信息嵌入SGN模型,我們在方程3中提出目標函數,參照目標詞出現的語境信息,提高詞彙特徵分佈的對比度。在方程3中,V表示詞彙,sim(w1, w2)爲詞彙W1和W2的兩個嵌入向量之間的相似度餘弦值。我們稱分佈式詞彙對比向量模型爲dLCE。

與方程1相比,方程3採用一種略微不同的方式將詞彙對比信息整合入skip-gram 模型中:對於每一個目標詞w,我們僅僅採用其反義詞A(w),而非採用其反義詞的同義詞S(w')。尤其是當我們運用大量訓練數據的時候,在運行時間內這種整合方法能夠更爲高效地訓練詞彙向量。

dLCE模型與WE-TD模型和mLCM模型相似,然而,後兩種模型僅將從WordNet 中提取的詞彙對比信息與每一個目標詞進行匹配,dLCE模型將詞彙對比信息與目標詞的每一個單一的語境進行匹配,旨在更好地捕捉語義對比信息,並對所獲取的語義對比信息進行分類。

3 實驗

3.1 實驗設置

用於我們提出的向量表示法的語料庫資源是當前最大的網絡語料庫之一:ENCOW14A (Schafer & Bildhauer, 2012; Schafer, 2015),該語料庫包括145億字符和561萬不同的詞類。我們運用5個字符表示原始向量表示法和詞彙向量模型,以此來顯示分佈式信息。我們通過訓練500個維度的詞彙向量來運用詞彙向量表示法;設定k否定樣例的數量爲15;設定次級樣例的閾值爲;忽視在語料庫中出現次數小於10次的所有詞彙。通過隨機梯度下降法計算出誤差的反向傳播值,從而得出模型的參數。其中涉及到的學習率策略與Mikolov等人(2013)設定的學習率相似,Mikolov等人將初始學習率設定爲0.025。我們運用WordNet和Wordnik收集反義詞與同義詞,總計提取出363,309對同義詞和38,423對反義詞。

3.2區分反義詞與同義詞

第一個實驗通過將經改進weightSA分數得到的向量表示法應用到區分反義詞與同義詞的任務中,評估我們的詞彙對比向量。我們使用Roth和Schulte im Walde (2014)文章中描述的英語數據集(黃金標準資源),該數據集包含600個形容詞詞對(300個反義詞詞對和300同義詞詞對),700個名詞詞對(350個反義詞詞對和350個同義詞詞對),800個動詞詞對(400個反義詞詞對和400個同義詞詞對)。我們運用平均精度和Kotleman 等人(2010)年運用的一種信息檢索度量方法,評估計算結果。

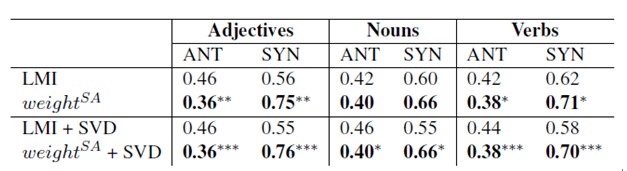

表格1所示爲第一個實驗的結果,該結果將我們改進過的向量表示法與原始的LMI表示法進行跨詞類對比,對比過程中或運用奇異值分解法,或不運用該方法。爲了運用平均精度對詞對分步進行評估,我們按照分數的餘弦值整理同義詞和反義詞詞對。倘若一個同義詞詞對屬於第一半,該詞對將被視爲肯定;倘若一個反義詞詞對屬於另一半,該詞對將被視爲肯定。表格中所示的優化結果將SYN的平均精度賦值爲1,將ANT的平均精度賦值爲0。表格中的結果證明了,進行跨此類對比過程中,weightSA在極大程度上優於原始向量表示法。

表格1:DSM模型的平均精度評估結果

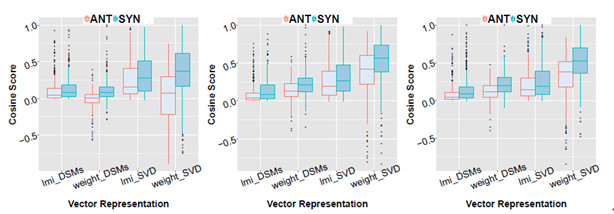

(a)形容詞詞對的餘弦值 (b)名詞詞對的餘弦值 (c)動詞詞對的餘弦值

圖2:反義詞詞對與同義詞詞對的餘弦值之間的差異

此外,圖2所示爲跨詞類對比中反義詞詞對(紅色)與同義詞詞對(綠色)兩者的相似度餘弦值的中位數對比結果。圖中顯示,與原始的LMI表示法相比,運用我們的經過改進的向量表示法計算得出的兩種語義關係的相似度餘弦值表現出極大的不同,當運用SVD向量表示法時,這種差異表現得更爲明顯。

3.3 分佈式詞彙對比法對詞彙向量的影響

第二個實驗運用區分反義詞-同義詞和詞彙相似度任務,評估我們的dLCE模型的性能。相似度任務要求預測詞對之間的相似度,按照一種黃金人工評估標準,參照Spearman 等級相關係數ρ(Siegel & Castellan, 1988),對預測結果的等級排序情況進行評估。

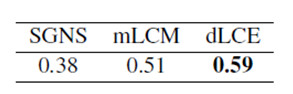

本文運用SimLex-999數據集(Hill等,2015),針對相似度預測結果來評估詞彙向量模型的性能。該數據集包含999個詞對(666個名詞詞對,222個動詞詞對和111個形容詞詞對),建立該數據集旨在評估各種模型在捕捉詞對相似度方面,而非詞對相關性方面的性能。表格2顯示,我們提出的dLCE模型優於SGNS和mLCM模型,證實了詞彙對比信息有助於預測詞彙相似對。

表格2:SimLex-999數據集中的Spearman等級相關係數ρ

因此,dLCE模型中同義詞(意義極爲相似的詞對)與反義詞(意義極爲相關,卻高度不同的詞對)之間經提升過的區分度也支持了相似度之間的差異。

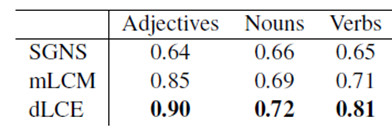

表格3:識別反義詞任務中的AUC得分

我們計算在3.2描述的數據集中所包含的詞對的相似度餘弦值,以區分反義詞與同義詞,然後運用ROC曲線(AUC)下方的區域評估dLCE模型與SGN和mLCM模型的性能對比結果。表格3中的結果顯示,在該任務中dLCE模型的性能優於SGN模型和mLCM模型。

4 結論

本文提出了一種新型向量表示法,該向量表示法能夠提高傳統分佈式語義模型和詞彙向量預測詞彙相似度的精準度。首先,我們運用詞彙對比信息極大程度地增強了權重特徵,以區分反義詞與同義詞。其次,我們將詞彙對比信息運用到skip-gram模型中,能夠成功地預測詞對相似度,同時也能夠識別反義詞。