近日,加州大學伯克利分校(UC Berkeley)在研究中嘗試使用深度學習計算模型解釋生物學中觀察到的自然特徵,在建模靈長類動物視網膜的注意點採樣點陣的基礎上,這些結果可引領主動視覺系統前端的新型設計方式的未來思考,並希望這種學科之間的良性循環仍會持續。

我們爲什麼需要注意力

我們通過眼睛觀察到的只是世界的很小一部分,雙眼只能採樣周遭光場的少許片段,即使在這些片段中,大多數分辨力都是專注於神經節細胞(ganglion cell)濃度最高的注視中心。這些細胞負責把視網膜上的圖像從眼睛傳遞到大腦。神經節細胞的空間分佈高度不均勻。結果,我們的大腦接收到一個「注視點」(foveated)圖像。

一張注視中心分別爲蜜蜂(左)和蝴蝶(右)的注視點圖像。

儘管這些細胞只覆蓋了一部分視野,但是大約 30% 的大腦皮層會處理其提供的信號。如果大腦集中注意力處理整個視野,則體積會大到不切實際。可以說,專注於視覺的神經處理的數量相當大,如果被有效利用將有助於生存。

注意力是很多智能系統的基本屬性。由於物理系統的資源有限,有效分配就變得很重要。注意力涉及到動態地分配信息處理資源從而最優地完成一個具體任務。在自然中,這種設計在動物視覺系統中十分常見。通過在場景中快速移動注視點,有限的神經資源高效地散佈在整個視覺場景內。

外顯注意力(Overt Attention)

這項工作中,我們研究了涉及感知器官清晰運動的外顯注意力機制,下圖中這隻處於青春期的跳躍蜘蛛是它的一個實例:

一隻使用外顯注意力正在跳躍的蜘蛛。

我們可以看到這隻蜘蛛通過認真審慎地移動身體來處理所處環境的不同部分。如果你盯着它半透明的頭部時,甚至可以看到蜘蛛的眼動軌跡與人類眼動類似。這些眼動叫作 saccades。

本研究中,我們構建了一個模型視覺系統,該系統掃視整個場景以尋找和識別目標,它允許我們通過探索優化性能的設計參數來研究注意力系統的特性。視覺神經科學感興趣的一個參數是視網膜採樣點陣,它定義了人眼中神經節細胞陣列的相關位置。

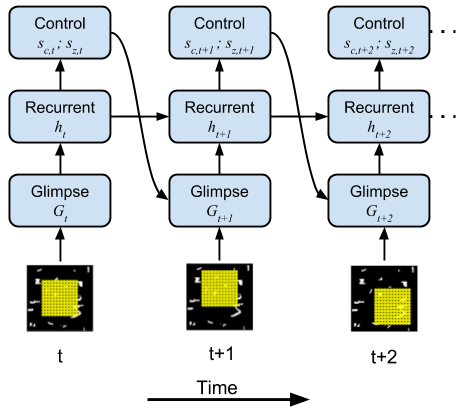

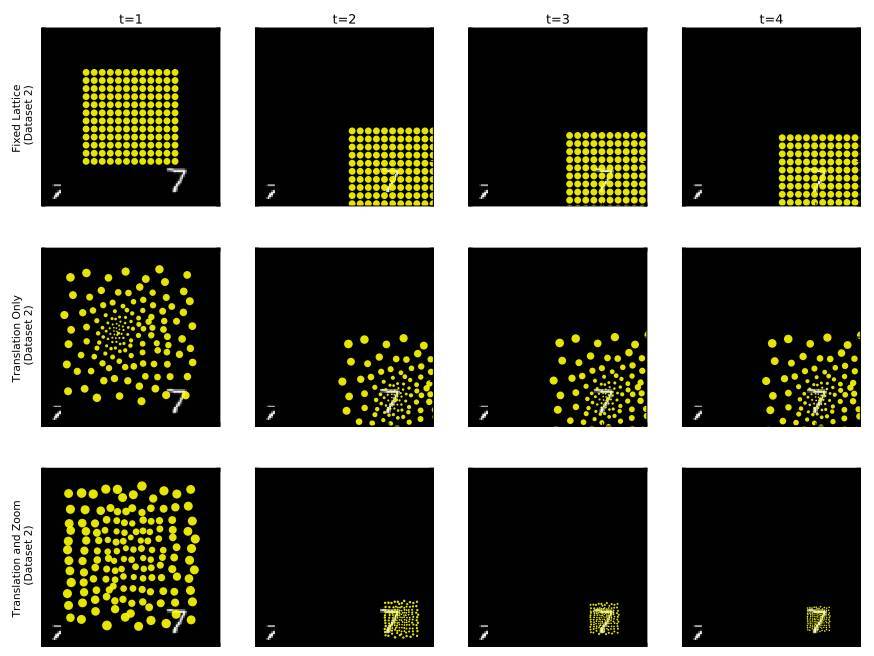

注意單個場景不同部分的模型視網膜採樣點陣。

控制注意力窗口的神經網絡模型。

通過梯度下降逼近進化

大概是出於進化的壓力,大自然調整了靈長類動物視網膜中的採樣陣列,因此我們的視力在搜索物體時體現出十分優秀的屬性。爲了代替這種模擬演化,我們利用一個更高效的隨機梯度下降過程而構建一個處處可微的動態注意力模型。

目前大多數神經網絡有可學習的特徵提取器構成,而這些特徵提取器可以將固定的輸入轉化爲如類別那樣更加抽象的表徵。在訓練過程中模型能續能學到內部特徵,即權重矩陣和卷積核等,而保持輸入的幾何屬性仍然不變。我們擴展了深度學習框架以創造可學習的結構特徵。此外,我們還學習了神經視網膜採樣陣列的幾何形狀。

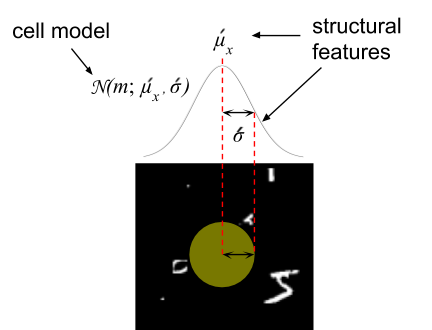

採樣陣列中一個單元的結構化特徵

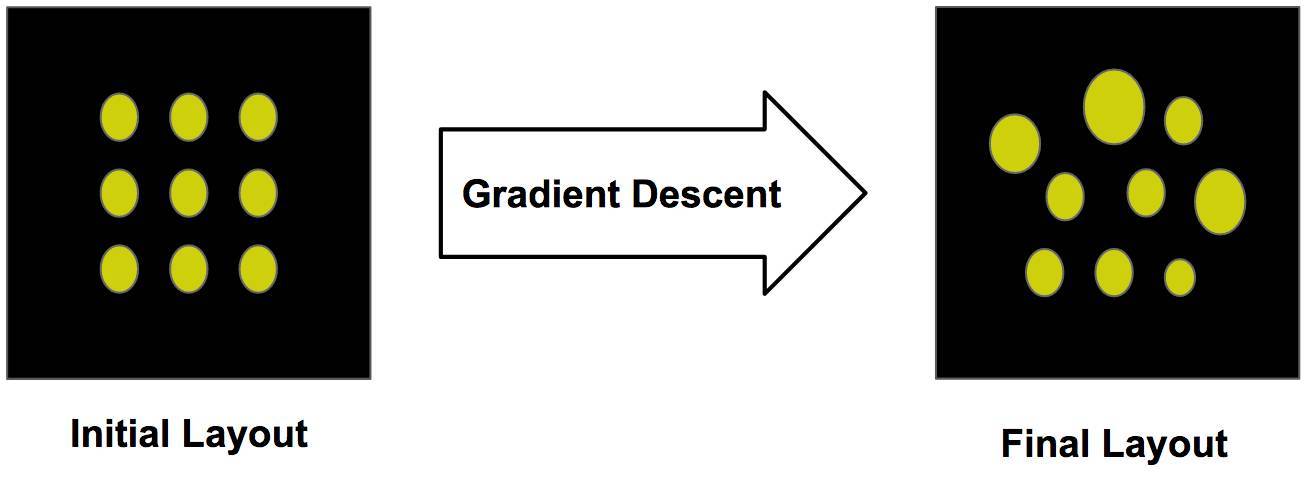

我們模型的視網膜採樣陣列是通過反向傳播學習的,它就如同神經網絡中調整權重的方式,我們調整視網膜並列式感知的參數以優化損失函數。我們初始化視網膜採樣陣列爲標準的正方形表格,然後使用梯度下降更新這種排列的參數。

從初始化陣列使用梯度下降學習結構化特徵

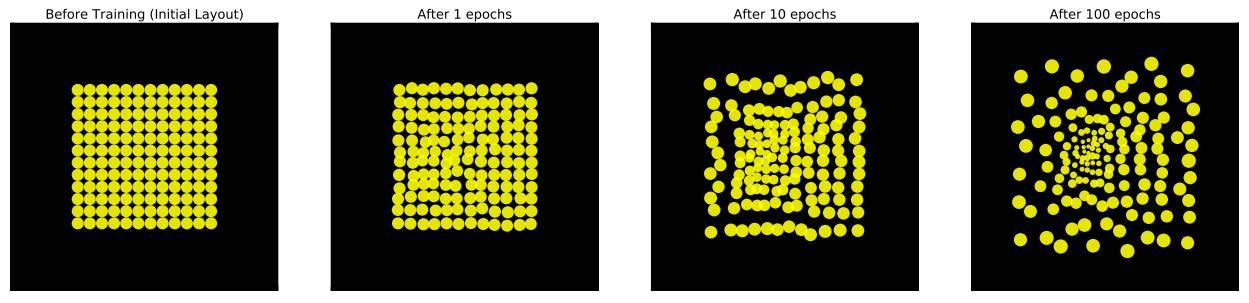

隨着時間的推移,這種排列將會收斂到局部最優的配置以最小化任務損失。本案例中,我們在更大的視覺場景分類 MNIST 手寫數字。以下展示了訓練期間視網膜排列是如何變化的:

初始化後分別訓練 1、10、100 個 epoch 所產生的視網膜採樣點陣變化情況。

令人驚奇的是,每個單元都以非常結構化的形式變化,從均勻的網格轉化爲一個離心的獨立性點陣。我們注意到高度敏感的單元集中在採樣陣列的中心。此外,每個單元都會擴散它們獨立的中心以創造能覆蓋整張圖片的採樣點陣。

控制注意點的出現

因爲我們的模型是通過電腦模擬,所以我們能賦予它自然界找不到的屬性以觀察是否還有其它的點陣排列模式出現。例如,我們可以重新縮放整個採樣點陣以覆蓋更小或更大的區域,這可以賦予模型放大或縮小圖像的能力。

視網膜採樣點陣同樣有能力重新縮放自身

我們在下面展示了所學到的不同視網膜點陣佈局。爲了比較,左圖展示了模型不具備縮放功能的視網膜點陣佈局,而右圖展示了能夠縮放的視網膜點陣佈局。

(左)只能變換的模型視網膜點陣;(右)既能變換又能縮放的模型視網膜點陣。

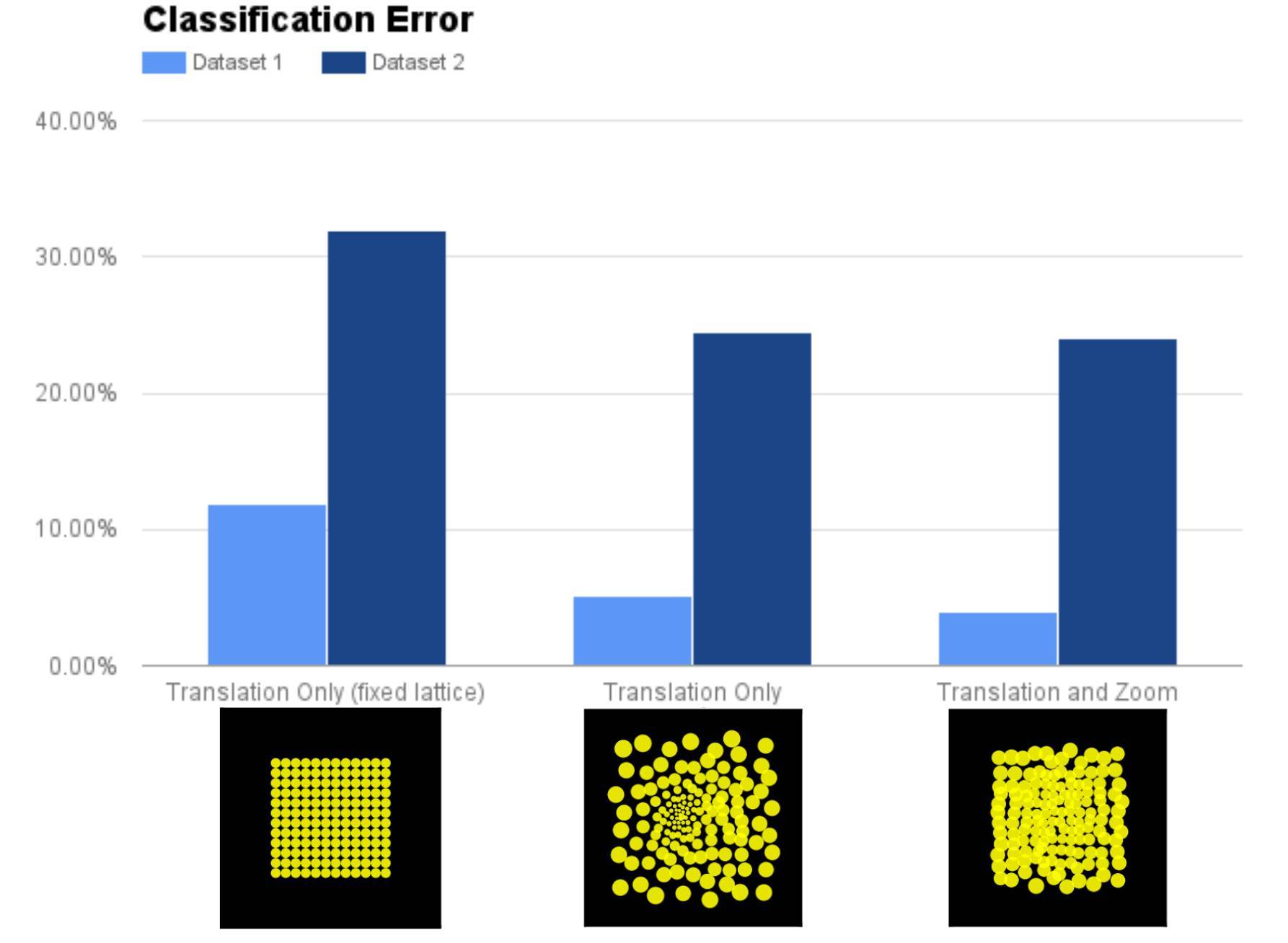

當注意力模型能夠縮放時,就會出現一個不同的佈局。注意:視網膜神經節細胞中的多樣性較少。這些細胞保留很多初始特性。爲了更好地利用學得的視網膜佈局,我們對比了具備固定(不可學習)點陣、可學習點陣(不能縮放)和可學習、能夠縮放點陣的視網膜的性能。

模型在 Cluttered MNIST 數據集的兩種版本(數據集 1 和數據集 2)上的性能。數據集 2 包含可隨機改變大小的 MNIST 數字,因此數據集 2 比數據集 1 難度更高。

或許結果不會讓人驚訝,縮放/可學習的點陣顯著優於只能變換的固定點陣。但是,有趣的是,僅具備變換能力的可學習點陣的性能和具備變換能力還能縮放的點陣性能一致。這進一步證明縮放和靈長類動物視網膜的注意點佈局的功能是一致的。

注意力的可解釋性

早些時候,我們介紹了注意力高效利用有限資源的能力。注意力還能夠幫助我們從內部理解構建的複雜系統如何運轉。當我們的視覺模型在處理過程中注意圖像的特定部分時,我們能夠了解該模型運用哪一部分來執行任務。在我們的案例中,該模型通過學習將注意點放置在數字上來解決識別任務,這說明注意力能夠幫助分類數字。我們還看到最下方模型利用其縮放能力來識別數字。

我們的模型隨着時間的注意力移動。固定點陣的模型(上),學得的點陣(中),學得的具備縮放能力的點陣(下)。

結論

通常,我們從生物學中尋找靈感來構建機器學習模型。Hubel 和 Wiesel 的研究啓發了神經認知機(Neocognitron)模型的出現,該模型又反過來促進卷積神經網絡的發展。在該研究中,我們選擇了另一個方向,嘗試使用深度學習計算模型解釋生物學中觀察到的自然特徵。未來,這些結果可能會引領我們思考主動視覺(active vision)系統前端的新型設計方式,根據靈長類動物視網膜的注意點採樣點陣(foveated sampling lattice)進行建模。我們希望這種學科之間的良性循環未來仍會持續。

更多信息,請查看我們發表在 ICLR 2017 的論文《Emergence of foveal image sampling from learning to attend in visual scenes》:https://arxiv.org/abs/1611.09430

參考文獻

1. Hubel, David H., and Torsten N. Wiesel.「Receptive fields, binocular interaction and functional architecture in the cat's visual cortex.」The Journal of physiology 160.1 (1962): 106-154.

2. Fukushima, Kunihiko, and Sei Miyake.「Neocognitron: A self-organizing neural network model for a mechanism of visual pattern recognition.」Competition and cooperation in neural nets. Springer, Berlin, Heidelberg, 1982. 267-285.

3. LeCun, Yann, et al.「Handwritten digit recognition with a back-propagation network.」Advances in neural information processing systems. 1990.

4. Gregor, Karol, et al.「DRAW: A Recurrent Neural Network For Image Generation.」International Conference on Machine Learning. 2015.

原文鏈接:http://bair.berkeley.edu/blog/2017/11/09/learn-to-attend-fovea/