雷峯網按:本文作者鐵流,雷鋒網(公衆號:雷鋒網)首發。

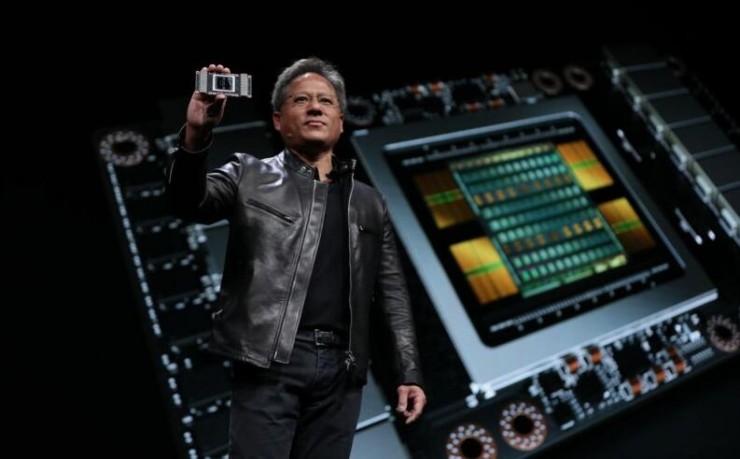

上週,英偉達在加州舉行了2017年的GPU技術大會(GTC2017)。在大會上,英偉達CEO黃仁勳發佈了全新力作——NVIDIA Tesla V100。根據英偉達官方介紹,Tesla V100採用了全新架構Volta,不僅會有更強的性能,還增加了TensorCore用以專門針對深度學習。在發佈會後,英偉達的股價也隨之走高。那麼英偉達能憑藉Tesla V100強悍的性能在深度學習領域力壓羣雄嗎?

Tesla V100的優點和存在的不足

根據英偉達官方介紹,Tesla V100採用臺積電12nm FinFET製造工藝,供集成了210億個晶體管,芯片面積達815平方毫米。英偉達爲了針對深度學習,專門進行了優化,經過優化的設計比前代Pascal架構能效高50%。而且新的 Tensor Core是專門爲深度學習設計的,爲浮點運算速度帶來了 12 倍的提升——Tesla V100增加了Tensor Core,Tensor單元本質上是把運算器做得更密集,以這種方式獲取更強性能。此外,Tesla V100還擁有更大的帶寬和更低的延遲,半精度浮點乘混合單精度浮點加法也非常適合深度學習訓練。

簡而言之,就是運算器堆的更多,矩陣乘法運算能力更強,性能得道大幅提升,Tesla V100雙精浮點運算性能高達7.5TFlops,相比之下,Intel用於深度學習的KnightsMill雙精浮點性能爲3TFlops。

由於人工智能的迅速發展,諸多企業對與高性能深度學習處理器的需求也與日俱增:

微軟的ResNet的深度學習項目需要每秒7百億億次浮點運算的處理能力;

百度2016年打造的DeepSpeech2AI需要每秒20百億億次浮點運算的處理能力;

谷歌2017年打造的NMT則需要每秒105百億億次浮點運算的處理能力;

......

因此,英偉達的Tesla V100作爲數據中心GPU是非常具有潛力的,不僅可以滿足訓練的需求,還可以放在後臺提供相關服務。

雖然Tesla V100在性能上無與倫比,而且在一些領域頗具市場潛力,但還是存在不少缺點的。比如芯片面積過大——高達815平方毫米,而過大的芯片面積,加上英偉達在該款芯片上鉅額的研發投入(黃仁勳稱英偉達花了30億美元打造這款芯片),直接導致Tesla V100的價格異常昂貴,售價高達14.9萬美元。如此高的售價會讓很多用戶望而卻步。

就產品定位來說,Tesla V100性能超強,拿來類比的話是一臺超級計算機,而在很多場景下,其實用不到性能這麼強,價格如此昂貴的產品。對於普羅大衆和大多數應用場景來說,性能夠用、功耗低且廉價的產品纔是最好的選擇,就像普通消費者需要的是智能手機和PC,而不是超級計算機。比如將來智能手機裏如果要集成針對深度學習的模塊,英偉達的產品顯然是不合適的。在這種場景下,開發專門針對嵌入式平臺的處理器IP更加符合市場需求。

英偉達的Tesla V100的市場定位類似於核彈,但真正需要核彈的場景其實相對不多,而且客戶也只能是谷歌、微軟、百度這些國際巨頭。正如核彈僅被少數國家掌握,而且在國際衝突和局部戰爭中鮮有使用,AK47和RPG是纔是被最廣泛使用的武器類似,英偉達的這種市場定位,會使其失去非常廣闊的嵌入式設備市場。

最後就是功耗的問題,英偉達的終端低功耗做得不夠好。必須說明的是,臺積電的12nm工藝其實是16nm工藝的改良版本,是針對三星玩14nm命名遊戲的反擊。因此,臺積電的12nm工藝到底對功耗控制有多大實際效果還是等產品上市後才能見分曉了。

深度學習處理器將進入戰國時代

自AlphaGo與韓國棋手李世石大戰之後,深度學習、人工智能這些概念立馬火了,不僅成爲資本的寵兒,各色各樣的深度學習處理器紛紛涌現出來,各家IC設計公司推出了各自CPU、GPU、FPGA、DSP、ASIC等方案。

就CPU來說,最典型的就是Intel的Xeon Phi。Intel的衆核芯片雙精浮點性能爲3 TFlops,性能功耗比爲12 GFlops/W。雖然Intel宣稱:「四片 Knights Landing Xeon Phi芯片比四片 GPU要快 2.3 倍」、「使用Intel優化版的Caffe深度學習框架時,Xeon Phi芯片要比標準 Caffe 實現快30倍」。但目前來說,還是英偉達的GPU更勝一籌。除了Intel之外,中國自主設計的申威26010也是一個潛在的選手,在人工智能領域也有應用的潛力,百度還爲此與申威有過接觸。

在DSP上,國內外還有不少單位或公司也選擇用傳統SIMD/DSP架構適配神經網絡。比如中星微的星光智能一號、CEVA公司的XM4處理器、Cadence公司的Tensilica Vision P5處理器、Synopsys公司的EV處理器等。這些處理器本質上都是將傳統的面向數字信號處理的DSP處理器架構用於處理神經網絡,主要在運算器方面作了相應修改,例如低位寬和超越函數。這種做法的優勢在於可以充分利用現有的成熟技術,但缺點也很明顯,就是在應用領域上有一定侷限性。大多用於卷積神經網(CNN),而對循環神經網絡(RNN)和長短期記憶網絡(LSTM)等處理語音和自然語言的網絡則無能爲力。換言之,就是這種DSP主要用於機器視覺領域,可能難以應用到語音識別、文本處理和自然語言理解等領域。雖然採用DSP作爲人工智能硬件存在一定不足。不過,採用現有比較成熟技術應用於人工智能細分市場的做法在商業上還是有一定潛力的。

在FPGA上,阿爾特拉推出的用於人工智能的FPGA,雙精浮點性能爲1.5TFlops,雖然雙精浮點性能只有 Xeon Phi 衆核芯片的一半,但性能功耗比卻高達50GFlops/W,如果人工智能硬件選擇FPGA,那麼不僅對Xeon Phi 衆核芯片在性能功耗比上有明顯優勢,對英偉達的GPGPU也佔據優勢地位。而更高的性能功耗比就意味着在運營和維護中能夠節省電費。FPGA雖然會在新興領域取得一定成績,但卻缺乏性價比的問題,而且在新興領域發展壯大後容易被專用芯片所取代。不過,就目前來說,FPGA也是深度學習處理器的一個選擇。

在ASIC方面,中國中科院計算所孵化好市場化的寒武紀公司寒武紀開發出了一系列產品,在芯片面積控制和性能功耗比上具有非常出色的表現。而在學術成果斐然:在2014年—2016年橫掃體系結構學術圈,Diannao(電腦)是ASPLOS'14最佳論文(亞洲第一次);DaDiannao(大電腦)是MICRO'14最佳論文(美國以外國家的第一次);PuDiannao(普電腦)、ShiDiannao(視電腦)、還有指令集Cambricon等後繼工作都連中ASPLOS、ISCA。不過,ASIC也存在開發週期比較長的遺憾,這對寒武紀在人工智能芯片的短期商業競爭中非常不利,特別是在中國半導體工業原本就落後於西方的情況下。最後要說的是谷歌的TPU,谷歌TPU其實是傳統脈動陣列機的結構,MIT於2016年前後發表的Eyeriss也是類似的架構,必須指出的是,脈動陣列架構是非常老的技術,同時也是非常經典的技術。早在上世紀80年代初,中科院計算所的夏培肅院士和李國傑院士就曾將脈動陣列架構用於石油勘探——計算所曾經研發過的石油勘探專用機就是採用了脈動陣列架構。從實際運行性能表現上看,TPU雖然可能在面對退化情形的卷積上也會遇到困難,但做卷積神經網路(CNN)時總體效果還是不錯,但做其他類型的神經網絡運算,可能效率不是那麼高,通用性不是那麼的好。例如在語音識別和自然語言理解中常用的長短期記憶網絡(LSTM)上面,TPU只有4%左右的效率。

總而言之,就深度學習處理器而言,已然進入戰國時代,而且各家的產品都有可能在這個廣闊的市場中找到自己的定位和細分市場,在這種情形下,英偉達想憑藉Tesla V100一統江山顯然是不切合實際的。在戰國時代,相對於技術上的片面追求極致性能,而忽視成本、功耗、價格,如何開拓更多細分市場,更好的商業化纔是在大爭之世的當務之急。

雷鋒網特約稿件,未經授權禁止轉載。詳情見轉載須知。