一、披着人工智能外衣的僞科學

在今年12月舉辦的清博盛典暨新媒體大數據AI峯會上,清華大學教授瀋陽分享了這樣一個觀點:人類的能力正在逐步被機器所替代,每一個人被技術賦能之後,他都在自我的能力上更強大。對此他舉了個例子,比如說我們可能越來越不需要察言觀色的能力了,只需要帶一個智能眼鏡就可以看出來對方對你發言的這個好感度在上升還是在下降。甚至可以設想這樣一種場景,未來的丈母孃見準女婿的時候,只用戴一個智能眼鏡掃描準女婿的臉部皮膚就能判斷他的健康指數,通過大數據自動分析這個小夥子在哪些美女帳號下點贊,就知道了這個小夥子在網絡上所表現出來的品性如何。

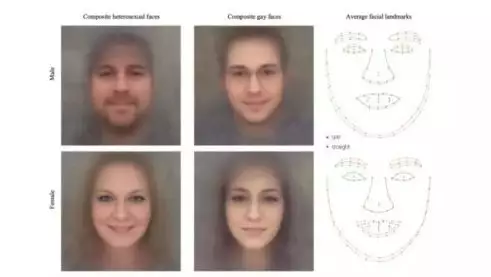

儘管教授所描繪的未來場景帶有玩笑成分,不過利用人工智能技術來識別面相的應用倒是真實存在的。無論是上海交通大學研究者對1856張人臉照片進行犯罪傾向分析,通過抓取眼內角寬度、鼻脣角角度、嘴角弧度等面部差別性特徵,證明了卷積神經網絡可以較準確地分類犯罪,或者是斯坦福大學的研究人員宣佈他們對超過35000張人臉照片中人物的表情、動作和神態進行分析,建立了一種準確率相對比較高的性取向鑑別算法,這些研究成果一經公佈都引起了業內很大爭議。很多人認爲,這只是披着人工智能外衣的僞科學和麪相學,充滿了偏見和歧視。

除了AI面像識別應用充滿偏見,搜索引擎也是體現算法偏見的重要領域。比如,在谷歌上搜「black girl」,第一屏有絕大部分都是色情圖(後來谷歌把這個問題修復了);哈佛大學的計算機系教授拉譚雅•斯威尼發現,在搜索引擎上搜典型的黑人名字,搜索引擎會有超過80%的概率在搜索建議裏提供「逮捕」「犯罪」等詞彙,而沒有種族特徵的卻只有不到30%。以及最近谷歌CEO「 劈柴」在出席聽證會時,就被要求解釋爲什麼用谷歌搜索「白癡」時會出現特朗普的照片。歸根結底,搜索引擎反應的並不是現實,而是它的使用者對現實的理解。

除了AI面像識別應用充滿偏見,搜索引擎也是體現算法偏見的重要領域。比如,在谷歌上搜「black girl」,第一屏有絕大部分都是色情圖(後來谷歌把這個問題修復了);哈佛大學的計算機系教授拉譚雅•斯威尼發現,在搜索引擎上搜典型的黑人名字,搜索引擎會有超過80%的概率在搜索建議裏提供「逮捕」「犯罪」等詞彙,而沒有種族特徵的卻只有不到30%。以及最近谷歌CEO「 劈柴」在出席聽證會時,就被要求解釋爲什麼用谷歌搜索「白癡」時會出現特朗普的照片。歸根結底,搜索引擎反應的並不是現實,而是它的使用者對現實的理解。

英國巴斯大學計算機系教授喬安娜•布萊森曾說過,「數學上沒有所謂‘公平’的概念」,「偏見,只是機器從數據中拾取的規律而已。」就目前而言,機器是不具備體會情感或者故意施加偏見的能力的,爲何算法會帶有偏見,以及如何解決偏見,則是我們需要關心的問題。

二、爲什麼算法會帶有偏見

算法偏見的產生主要來源於「數據偏見」。如果輸入的數據是錯誤的,那麼AI算法的結果可能會有偏見。

此前我們在《一文了解AI時代的數據風險(後真相時代、算法囚徒和權力讓渡)》中,指出過客觀數據會因爲這些原因而導致失真: 數據樣本偏差帶來的「以偏概全」、「髒數據」帶來的污染、數據分析模型偏差帶來的方向性錯誤、數據挖掘能力有限帶來的「淺嘗輒止」、數據解讀的偏差。

算法偏見的分類有:

1、「交互偏見」是指用戶由於自己與算法的交互方式而使算法產生的偏見。當機器被設置向周圍環境學習時,它們不能決定要保留或者丟棄哪些數據,什麼是對的,什麼是錯的。相反,它們只能使用提供給它們的數據——不論是好的、壞的,還是醜的,並在此基礎上做出決策。微軟曾經在Twitter上放了一個機器人Tay,這個機器人上線時間僅有一天就被微軟下架了,原因是Tay在一天之內便受到用戶的嚴重影響而出現了種族歧視或者偏激的言論。

2、「潛意識偏見」 是指算法錯誤地把觀念與種族和性別等因素聯繫起來。例如讓人工智能識別較複雜的生活場景中的男女性別,研究者發現,男人被錯認成女人的圖片有一些共同點——都是站在廚房裏、或者在做家務。

3、「選擇偏見」 是指用於訓練算法的數據被傾向性地用於表示一個羣體或者分組,從而使該算法對這些羣體有利,而代價是犧牲其他羣體。以招聘爲例,如果人工智能被訓練成只識別男性的簡歷,那麼女性求職者在申請過程中就很難成功。

4、「數據驅動的偏見」 是指用來訓練算法的原始數據已經存在偏見了。機器就像孩子一樣:他們不會質疑所給出的數據,而只是尋找其中的模式。如果數據在一開始就被曲解,那麼其輸出的結果也將反映出這一點。

5、「確認偏見」 這類似於數據驅動的偏見,偏向於那些先入爲主的信息。它影響人們怎樣收集信息,以及人們怎樣解讀信息。例如,如果自己覺得8月份出生的人比其他時候出生的更富有創造性,那就會偏向於尋找強化這種想法的數據。

三、如何解決算法帶來的偏見問題

1、爲算法建立一個監管機制

要消除人工智能潛在的歧視問題,第一步是打開算法「黑匣子」。目前,多個國家開始制定關於算法的基本原則。

2017年1月12日,美國計算機協會下屬美國公共政策委員會發布文件,闡述了關於人工智能算法透明化和可責性七條原則。具體如下:

公衆對算法的瞭解,應該讓公衆瞭解自動決策的程度。

錯誤決策的救濟,對錯誤決策可以進行調查並予以糾正。

責任認定,算法設計者而不是系統本身對基於此算法所做出的決策負責。

解釋,無論算法的邏輯構架多麼複雜,都必須能夠用人類語言進行解釋。

數據來源及可靠性,算法設計者應該對訓練數據的來源及可靠性加以說明。

可審查性,算法設計機構應記錄模型、算法、數據和具體決策,以便在解決出現的問題或依法監管時有據可查。

驗證和測試,算法應用機構應採取可靠的技術手段對其算法的程序進行驗證,以提高基於此算法所自動做出的決策的可信度。

由於包括技術、經濟和社會等在內的很多因素,算法所作出的決策可能是不透明的或具有某種導向,算法偏見或歧視可能對公衆產生危害,上述原則的確立是通過算法透明化及可追溯性,儘量減少潛在的風險及危害。

美國公共政策委員會所發佈的這七條原則是要求了行業的自律性,而歐盟則是直接對算法透明度進行立法明文規定了。今年5月通過的《通用數據保護條例》(GDRP),除了隱私問題外,着重規範了AI技術的透明性。該條例要求,但凡使用算法進行自動決策的公司,都必須公佈其算法決策的邏輯。爲了降低存在錯誤和偏差的風險,GDPR甚至要求算法開發者使用「適當的數學或統計程序」,即公司需要對自動決策中出現的偏見和歧視負責。

除了相關法律法規的制定,一些企業巨頭也開始按照這些思路展開行動。例如谷歌開發的幾個人工智能項目,程序員爲機器學習增加了手動限制,使輸出的信息更準確,可理解性更高;美國國防部高級研究計劃局還資助了一項名爲XAI(可解釋的人工智能)的計劃,旨在打開人工智能的 「黑匣子」,以保證用戶更好地控制人工智能程序;IBM今年9月宣佈將IBM Research研發的偏見檢測工具AI Fairness 360 工具包開源,包括超過 30 個公平性指標,和 9 個偏差緩解算法,研究人員和開發者可將工具整合至自己的機器學習模型裏,檢測並減少可能產生的偏見和歧視。

2、把大數據與小數據結合,全數據思維代替大數據思維

除了通過打開算法 「黑匣子」,制定法規和政策來確保消除人工智能的偏見和歧視,在確保客觀的數據來源方面也應該有所行動。

2009年在H1N1爆發幾周前,谷歌的工程師們曾在Nature上發表了一篇論文,介紹了GFT,成功預測了H1N1在全美範圍的傳播,甚至具體到特定的地區和州,而且判斷非常及時,令公共衛生官員們和計算機科學家們倍感震驚。但是,在隨後的幾年當中,谷歌這一預測卻屢屢失靈,以至於在2014年美國《科學》期刊刊登的一篇題爲《谷歌流感的寓言:大數據分析的陷阱》的文章稱:很大一部分與疾控中心流感發生率數據相關的搜索詞,並非是得流感的人引起的,而是由影響搜索模式和流感傳播的第三個因素(季節)產生的。谷歌流感趨勢的開發人員發現那些特定的搜索詞是隨時間而發生變化的,但這些搜索顯然與病毒無關。比如,有的人可能僅僅是因爲看了一部電影或者文章而去搜索流感。

調查撰寫這篇文章的哈佛大學、美國東北大學的幾位學者認爲,大數據的分析是很複雜的,但由於大數據的收集過程,很難保證有像傳統小數據那樣縝密,難免會出現失準的情況。最核心的問題是,大數據分析側重相關性,導致在推導因果關係時容易出現誤差。他們建議,應該把大數據與小數據相結合,以「全數據」思維取代「大數據」思維。

事實上,在互聯網時代,通過在線民調形成針對用戶個人的小數據,依然是瞭解用戶偏好的捷徑。事實證明,互聯網公司也高度重視問卷式調查。自2014年上線以來,騰訊問卷累計使用用戶已經超過100萬,平臺周PV超過千萬。除了騰訊系產品微信、QQ、音樂、遊戲等廣泛使用騰訊問卷外,滴滴、58、鏈家、vivo、小米、央視315晚會、同程網等企業均使用騰訊問卷完成了大量的用戶調查與研究項目。

不過,無論是傳統的小樣本民調,還是全樣本的大數據分析,需要面臨的一個共同問題就是數據分析能力還有待提升。

四、算法有偏見,比人強就行?

今年7月,《哈佛商業評論》發表了一篇名爲Want Less-Biased Decisions? Use Algorithms的文章,作者爲Alex P. Miller。文中表示,雖然目前AI算法存在偏見,但是技術的進步如果有助於提高系統性能,這也是很重要的。即使有了偏見,也比人類的偏見小得多。

這一觀點得到很多人的認可,他們認爲,判斷和決策方面的心理學研究已經很多次證明了人類在各種背景下的判斷非常糟糕,而大量的研究表明算法比人類更少偏見、更準確。

不過,針對這篇文章,fast.ai的創始人之一Rachel Thomas有不同的看法。她認爲,儘管人類確實總是作出有偏見的決定,但是算法偏見的影響實際上比想象的要深遠得多。她指出文章中被忽視的問題,比如算法的實現通常沒有適當的方法(因爲很多人誤解算法是客觀、精準並且不會犯錯的);在很多情況下,算法的使用比人類決策規模大得多,所以也會產生和人類相同的偏見(通常是由於算法使用成本低);算法的使用者也許不瞭解概率或置信區間(即使這些都已經標明瞭),而且如果讓他們重寫算法也會很困難等等。因此,我們關注的重點應該是怎樣才能創造出偏見更少的決策工具。

不過,我們也不必要把算法看成是一種威脅,而是看成解決任何偏見問題的好機會,並能在必要的時候加以糾正。不要忘記,儘管人工智能發展非常迅速,但仍處於起步階段,還有很多值得學習和改進的地方。隨着技術的不斷髮展、相關法律法規的不斷完善,人工智能會變得更聰明,運用方式會更加規範,我們將會有越來越多的方法來克服偏見等問題。