由於檔期限制,我們經常會看到動畫由於製作時間緊張而出現作畫崩壞的情況。來自蘇州大學的研究者們提出的 Style2paints 或許可以幫助我們緩解這樣的情況,這種工具可以使用 AI 技術爲黑白線稿快速自動上色。在最近推出的 2.0 版中,研究人員使用了完全無監督的生成對抗網絡(GAN)訓練方法大幅提高了上色的準確性。Style2paints 的作者表示,該工具在精細度、漫畫風格轉換等方面超越了目前其他所有工具。

GitHub 鏈接:https://github.com/lllyasviel/style2paints

直接使用:http://paintstransfer.com/

教程視頻:https://www.bilibili.com/video/av17537429/

我們很高興發佈 style2paints 的 2.0 版,一個強大的動漫繪畫工具。在這裏,我們會主要介紹它的新特性。

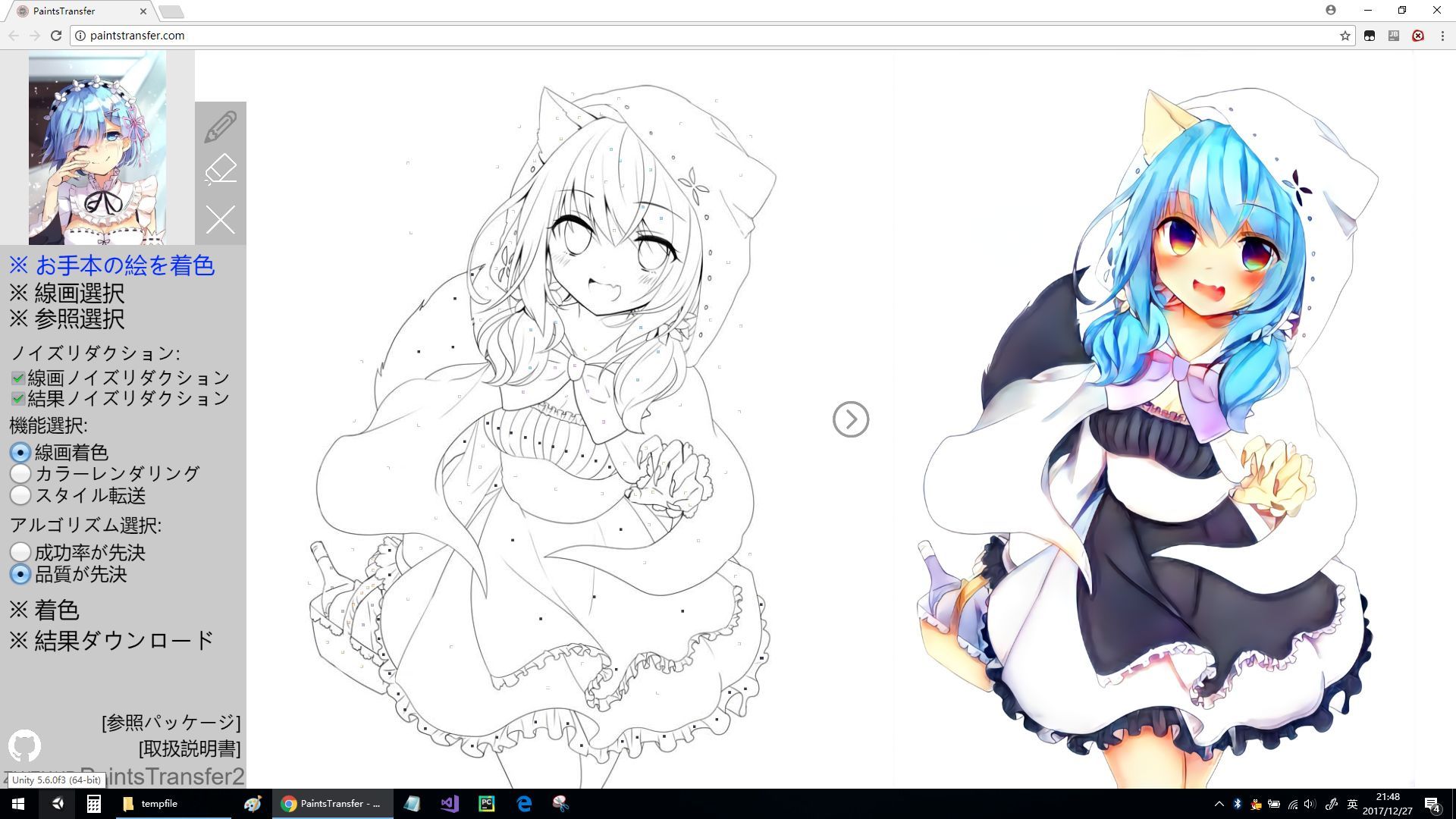

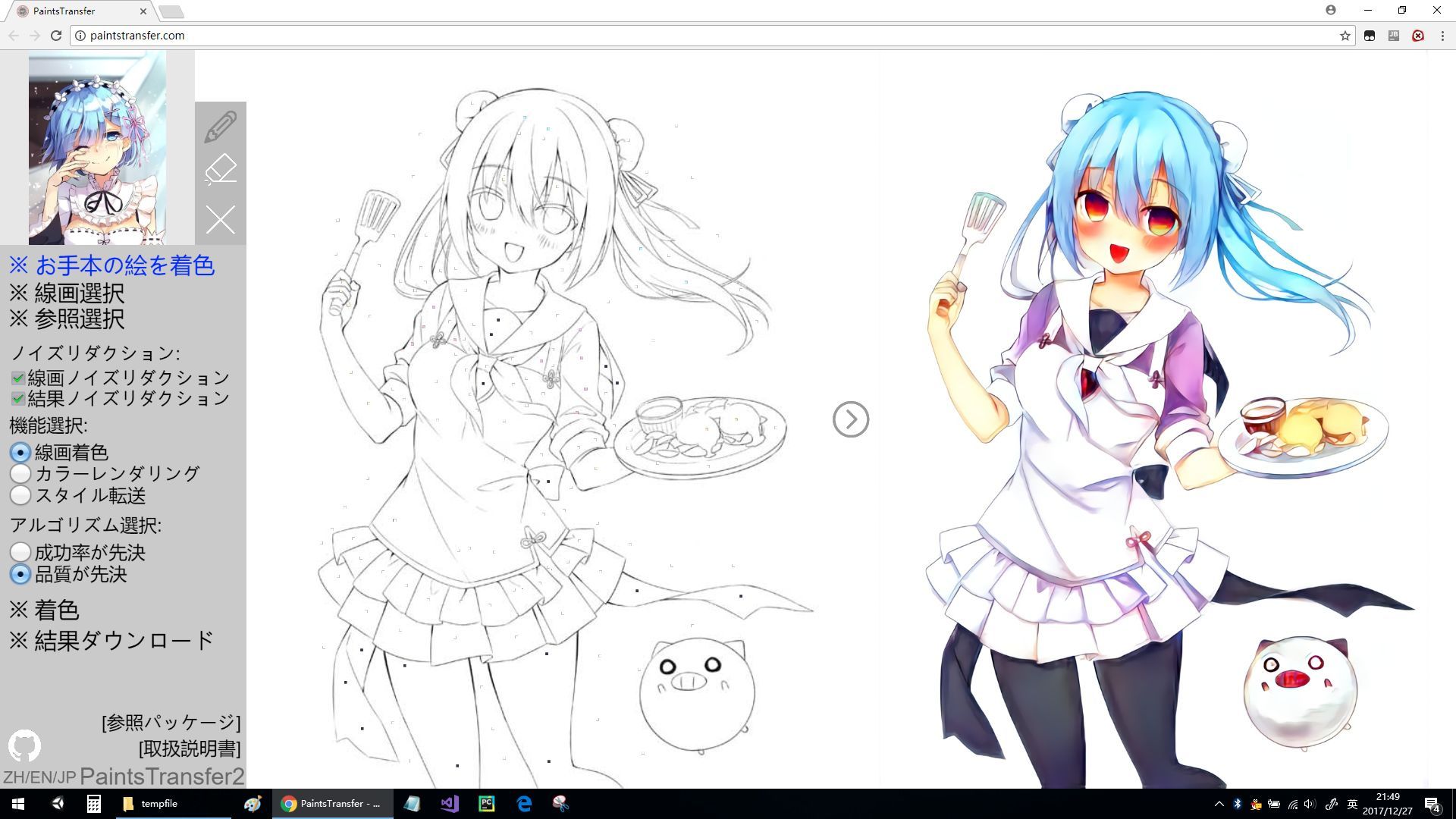

動漫線稿上色

當我們談到「上色」時,在人工智能語境裏這意味着將線稿的風格轉換爲彩色漫畫風格,其重要之處在於:

1. 讓我們直接在純線稿上生成彩色草圖。這意味着藝術家們不必再在線稿上加入高亮或陰影。這一部分非常具有挑戰性。近期的 paintschainer 專注於提升陰影部分的表現,我們給出了自己不同的解決方案,我們對新方法的性能非常有信心。

2.「上色」會將線稿風格遷移爲彩色圖畫。圖畫和上色的線稿圖,其中的區別在於陰影和紋理。在高質量的彩色漫畫中,女性角色的眼睛應該像星光一樣閃耀,臉頰泛紅,皮膚細膩,我們盡最大的努力來提升這些部分——而不僅僅專注於填充顏色。

最大貢獻

1. 最高準確度

Stylepaints2 的開發者表示其推出的工具有着準確率最高的色彩提示筆,這種被稱爲「神經提示筆(neural hint pen)」的工具結合了顏色選擇器和簡單的鋼筆工具。藝術家可以選擇顏色並在線稿的任何部位加入顏色提示。絕大多數業內最佳的神經網絡上色工具都有類似的工具。縱觀目前的所有動漫上色工具(Paintschainer Tanpopo、Satsuki、Canna、Deepcolor、AutoPainter(存疑)),Stylepaints2 的筆工具擁有最高的準確度。在最具挑戰性的情況下,藝術家甚至能在 1024×2048 分辨率的圖畫上使用 3×3 的提示筆控制 13×13 區域的顏色。對於更大的區塊,3×3 像素點的提示甚至可以控制半張畫幅的顏色。這是一個非常具有挑戰性的設計,這也意味着該工具是面向專業用途的(與此同時,其他上色方法的提示筆工具更傾向於嘈雜的提示,對於準確性把握不佳)。

2. 最自然的風格

當提到「自然」的時候,我們的意思是在訓練過程中不加入任何人工制定的規則,如果你熟悉 pix2pix 或 CycleGAN,你就會明白這些經典方法都會加入一些額外的規則以確保生成圖像的高質量。例如,pix2pix(或 HQ)會向學習目標加入一個 l1 損失函數(或一些深度 l1 損失),同時鑑別器接收 [input,training data] 和 [input, fake output] 對。雖然此前的版本中 Stylepaints 使用了這些方法,但新版本中訓練是純粹無監督,且完全無條件的。在訓練時,開發者未加入強制神經網絡爲草圖上色的規則,但神經網絡自行從輸入圖片中學習到了上色的方法,這樣的過程讓鑑別器更加難以識別。最終的學習目標與經典的 DCGAN 完全相同,沒有其他任何東西,同時鑑別器也不會收到 pairs。在神經網絡非常深的情況下,這種方式非常難以收斂。

3. 最協調的風格

對我們大多數人來說,繪畫是非常困難的,這也就是爲什麼我們會比較佩服藝術家。一位優秀藝術家的最重要技能就是爲繪畫選擇和諧的色彩。大多數人都不知道在繪畫領域中有十多種藍色,並且雖然這些顏色被稱爲「藍色」,但它們之間的差異會對繪畫結果產生巨大的應用。想象一下,如果非專業用戶運行着色軟件,而軟件向用戶展現 20×20=400 的巨大調色板,並向用戶詢問「你需要哪種圖像呢?」我很確定這些非專業用戶將不能選擇最好的顏色。但是這對 STYLE2PAINTS 來說並不是什麼問題,因爲用戶能上傳參考圖像(或稱爲風格圖像),然後用戶能直接在圖像上選擇色彩,神經網絡隨後會根據這些圖像和提示的顏色自動爲新圖像上色。這種色彩協調的着色對於非專業人員來說是友好的。在所有的人工智能動漫繪畫智能體中,我們的方法是唯一帶有這種協調特徵的模型。

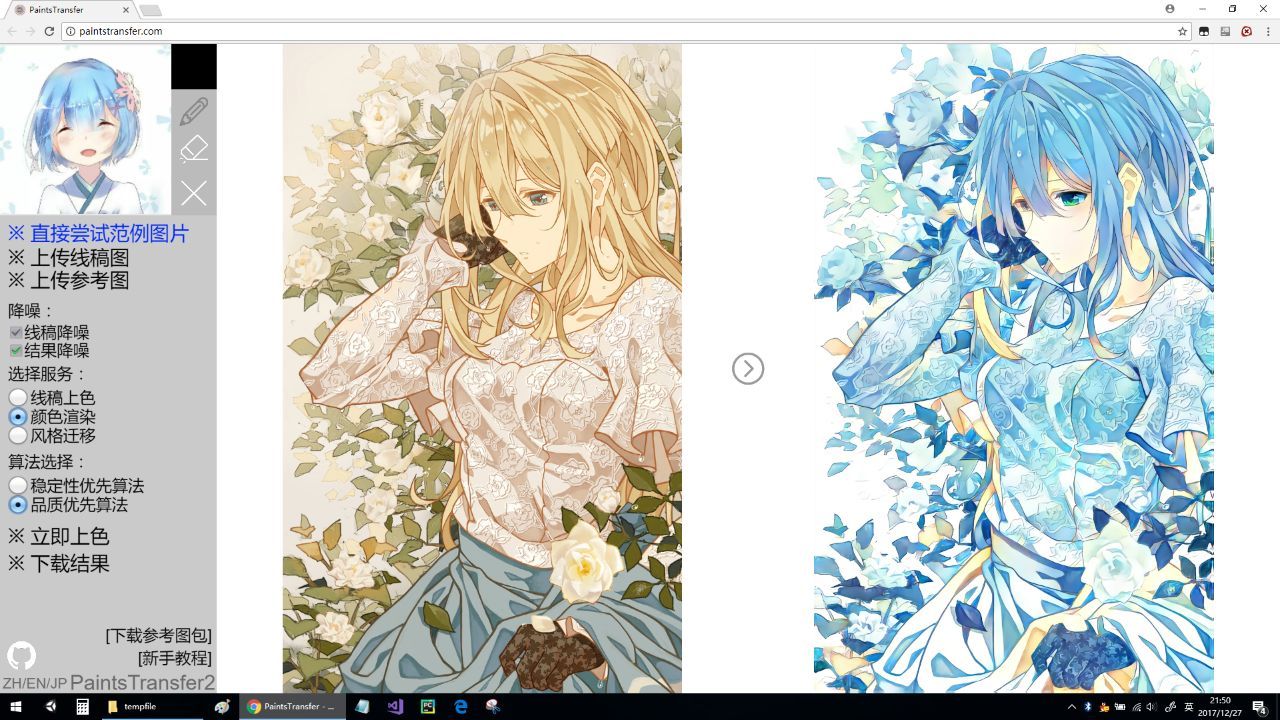

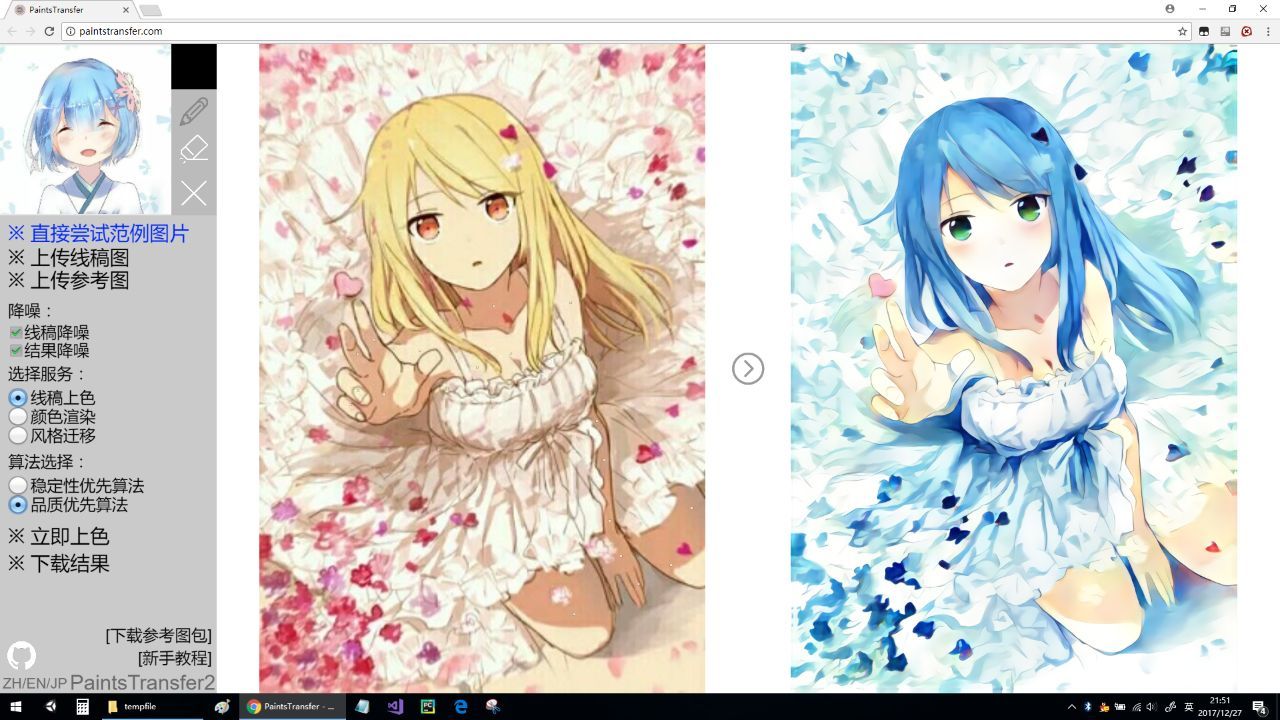

動漫風格遷移

是的,這就是一種動漫風格遷移。我不確定我們是不是第一個做這種遷移,但是我確定如果你需要一種動漫繪畫的遷移方法,你在網上搜一圈後會最終發現我們的 STYLE2PAINTS 是最好的選擇,事實上它也是唯一的選擇。許多來自亞洲的論文表明他們已經能夠遷移動漫繪畫風格,但是如果你仔細查閱他們的論文,你就會發現所謂的新方法其實就是對 VGG 進行調參。因此,下面我們展示了模型的真實情況:

所有基於 ImageNet VGG 的遷移方法在動漫繪畫中性能並不夠優秀。

所有基於 Anime Classifier 的方法也都不夠優秀,因爲我們並沒有像 ImageNet 那樣的動漫數據集。如果你在 Illustration2vec 或其它一些動漫分類器上運行一些 gram 矩陣優化器,你能獲得的只有一個完美的 Gaussian Blur Generator,因爲所有當前的動漫分類器在特徵學習上做得並不好。

因爲上面兩條,當前所有基於 gram 矩陣、馬爾科夫隨機場、矩陣範數和深度特徵 patchMatch 的方法在動漫上性能都不夠好。

因爲上面三條,所有前饋的快速遷移方法在動漫上都不夠優秀。

GAN 也可以做風格遷移,但是我們需要用戶上傳特定的風格,而不是選擇 Monet/VanGogh。

但幸運的是,我們設法完成了當前版本的應用,並且對它也十分有信心。讀者可以嘗試這個應用或查看該模型的源代碼:

應用地址:http://paintstransfer.com/

模型地址:https://github.com/lllyasviel/style2paints

注意,有些預覽的動漫線稿圖並不是我們挑選的,我們直接使用了 Paintschainer 來提升線稿圖效果。如果你們獲得的結果不太好,那麼你可以在 Reddit 上討論。

Reddit 地址:https://www.reddit.com/r/MachineLearning/comments/7mlwf4/pstyle2paintsii_the_most_accurate_most_natural/drv72cj/

說一點技術上的事情:

不知道是什麼時候開始的,關於圖像處理出現了一個套路,就是用 ResNet 堆砌網絡深度,然後就可以量產出論文,最近有很多類似的文章。Style2paints 的模型裏面沒有 ResBlock。研究人員使用的是特別適合線稿上色的一種 Inception 變體。

PaintsTransfer2.0 教程地址:https://www.bilibili.com/video/av17537429/

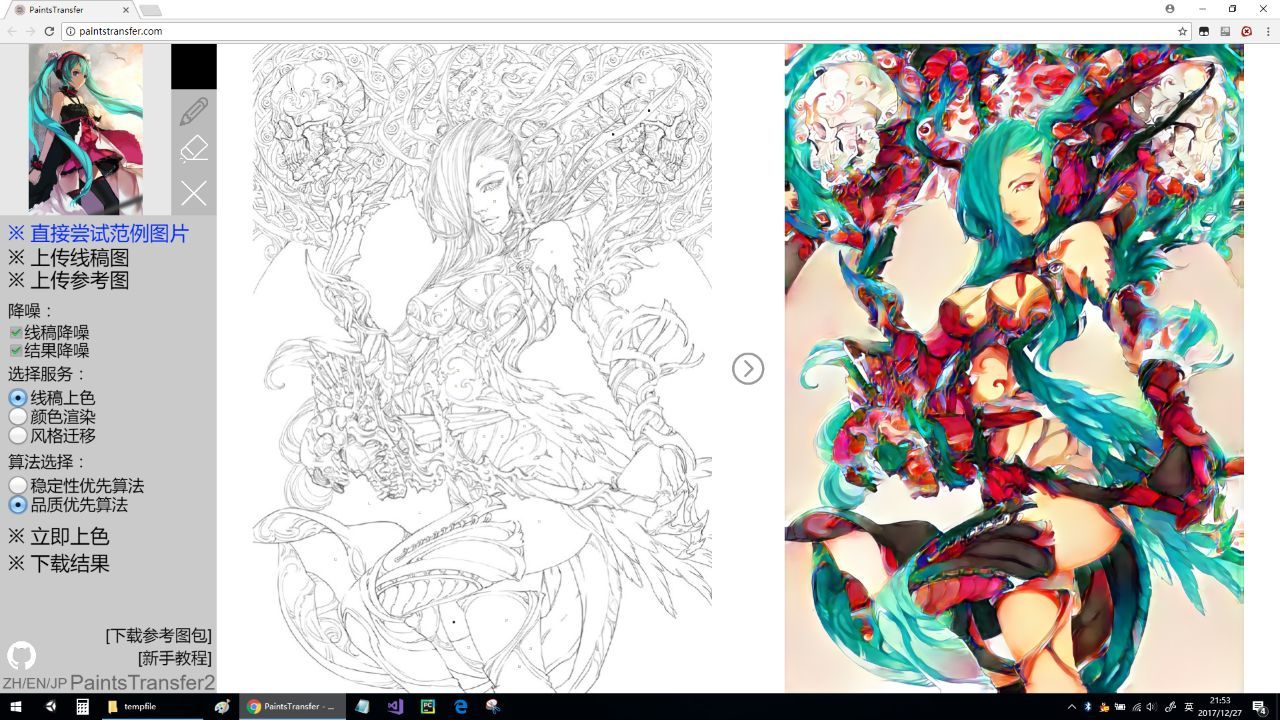

效果圖

啓動服務器

我們需要 Python 3.5/3.6 的環境

pip install tensorflow_gpu

pip install keras

pip install bottle

pip install gevent

pip install h5py

pip install opencv-python

pip install scikit-image

git clone https://github.com/lllyasviel/style2paints.git

(then download all pretrained models from'release'page andthen decompress them to 'style2paints/server')

cd style2paints/server

python server.py

模型

模型可以在該項目下的 Release 界面找到,目前製作者保留這些模型的所有權。

訓練數據集

1. 推薦的訓練數據集是來自 nico-opendata 的 400k 張圖像:https://nico-opendata.jp/en/seigadata/index.html

2. 推薦的線稿圖訓練方法可以選擇 sketchKeras:https://github.com/lllyasviel/sketchKeras