選自The M Tank

The M Tank 編輯了一份報告《A Year in Computer Vision》,記錄了 2016 至 2017 年計算機視覺領域的研究成果,對開發者和研究人員來說是不可多得的一份詳細材料。該材料共包括四大部分,在本文中機器之心對第二部分做了編譯介紹,第一部分和第四部分詳見《》和《》。

圖像分割

計算機視覺任務的核心是分割(Segmentation)處理,它將整幅圖片分割成可被標記和分類的像素組。在此基礎上,語義分割(Semantic Segmentation)則更進了一步,它試圖從語義上去理解一幅圖像中每個像素扮演的角色。比如:一個圖像中出現的是一隻貓還是汽車,還是其它類別的事物。然而,實例分割(Instance Segmentation)又在語義分割上更進了一步,它能夠分割出一個類別事物中具體不同的對象,比如以三種不同顏色來標記不同的三隻狗。此外,分割技術的應用十分廣泛,大量語義分割技術被應用於自動駕駛中。

可以認爲,在圖像分割領域,部分最重要的貢獻應該歸功於 FAIR 實驗室。自 2015 年起,他們便展開了名爲 DeepMask[46] 的研究項目。DeepMask 可以在對象上粗略生成一個初級版本的分割區域(也即一個「mask」)。在 2016 年,Fair 開發了 SharpMask[47] 系統,它可以對 DeepMask 提供的分割區域進行修正,糾正漏掉的細節並且改善語義分割效果。在此基礎之上,MultiPathNet[48] 可以識別出由每個分割區域描述的物體。

「爲了能夠識別一般物體的形狀,你必須首先在高層面(high-level)理解所觀察的事物(DeepMask),但是如果要想更具體地來識別它們,那你則需要觀察那些小到像素的低層面(lower-level)特徵(SharpMask)。」——Piotr Dollar,2016.[49]

圖 6:FAIR 語義分割技術實例展示,來源 Dollar(2016)。上圖展示了 FAIR 應用的圖像分割技術,它按順序包括了 DeepMask、SharpMask 和 MutiPathNet 技術。該流程可實現大規模場景中的精準分割與分類。

視頻傳遞網絡(Video Propagation Network)[51] 通過建立一個簡單模型,從視頻第一幀開始便向後傳遞精準的對象分割區域。此外,在整個視頻的傳遞過程中模型也會加入一些額外的信息。

在 2016 年,爲了解決上文提及的大規模任務以及本地實現問題,研究人員開始尋找替代性的網絡方案。DeepLab 就是一個例子,它在圖像語義分割任務上得到了令人激動的成果。Khoreva et al.[53] 基於 Deeplab[52] 的早期工作(circa 2015)提出了一個半監督學習方法,該方法和監督學習網絡的性能水平不相上下。

通過使用端到端網絡,計算機視覺進一步修正了網絡共享有用信息的方法。該方案降低了多進程全方位子任務分類的計算需求。以下是兩篇使用了該方法的論文。

100 Layers Tiramisu[54] 是一個全卷積 DenseNet,其中每一層都以前饋的方式與其它層級相連接。該網絡在多個標準數據集上都以更少參數和訓練/處理過程達到了目前最先進水平。

Fully Convolutional Instance-aware Semantic Segmentation[55] 可以同時執行具體實例的掩碼(mask)預測與分類這兩項子任務。該網絡獲得了微軟亞洲研究院 COCO 分割挑戰的冠軍。

然而在此之外,ENet[56](這是一種用於實時語義分割的深度神經網絡架構)卻並不屬於這一類別。它也展示出了可以降低計算成本的經濟適用價值,可以更好地用於移動設備。

我們希望儘可能地將這些前沿技術與已有的實際應用聯繫起來。所以下面列舉了醫療衛生領域在 2016 年內最有意思的一些圖像分割項目:

A Benchmark for Endoluminal Scene Segmentation of Colonoscopy Images[57]

3D fully convolutional networks for subcortical segmentation in MRI: A large-scale study[58]

Semi-supervised Learning using Denoising Autoencoders for Brain Lesion Detection and Segmentation[59]

3D Ultrasound image segmentation: A Survey[60]

A Fully Convolutional Neural Network based Structured Prediction Approach Towards the Retinal Vessel Segmentation[61]

3-D Convolutional Neural Networks for Glioblastoma Segmentation[62]

其中我們最欣賞的一個準醫療分割應用爲 FusionNet[63],這是一個深度殘差卷積神經網絡,它可以將圖像分割任務用於分析生物神經網絡的連接方式,其能力與最先進的電子顯微鏡分割方法不相上下。

超分辨率、風格遷移與着色

並非所有計算機視覺任務都是爲了去擴展機器的仿生認知能力。常常我們會發現,那些一個個走進公衆的生活的新奇應用產品都使用了具有極強適應能力的神經網絡以及其他機器學習技術。去年在超分辨率任務、風格遷移與圖像着色的研究就是這樣的例子。

超分辨率(Super-resolution)任務指的是從一個低分辨率樣本上預測出一個高分辨率版本的過程,此外,它也指對圖像特徵在不同放大倍數情況下的預測(這一點人類大腦幾乎可以不費吹灰之力就辦到)。最初的超分辨任務是通過如「雙三次插值法」、「最鄰近規則」這樣的簡單技術來實現的。但是對於商業應用而言這顯然不夠,人們希望系統能克服因數據源質量不高而出現的分辨率低的問題,實現像電視劇《犯罪現場調查:邁阿密》中那樣的圖像增強技術。正是這樣的願景推動着領域研究的前進。下面列舉相關方面的年度進展以及其潛在的影響:

神經增強(Neural Enhance)[65]:是 Alex J. Champandard 的項目,通過結合 4 篇不同的研究論文,他實現了自己的超分辨率方案。

Real-Time Video Super Resolution:2016 年也有兩篇相關的著名論文 [66][67]。

RAISR(Rapid and Accurate Image Super-Resolution),該技術來自谷歌,通過使用由高、低分辨率圖像配對而成的數據訓練的過濾器,系統避免了對內存與神經網絡速度的高度依賴。作爲一個基於學習的框架,RAISR 比其競爭對手快了兩個數量級。此外,相較於基於神經網絡的方法,系統的內存需求達到了最低。因此超分辨率技術可以擴展到移動設備上。[69]

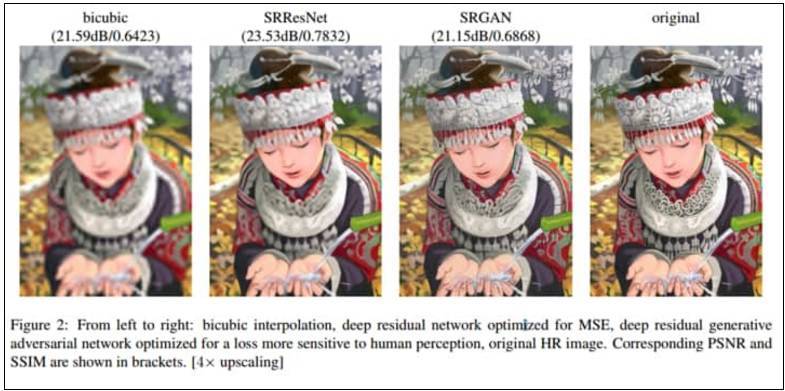

圖 7:SRGAN 的超分辨率任務示例,來源 Ledig et al. (2017)[70]。從左至右分別爲「雙三次插值法」、優化了均方誤差性能的深度殘差網絡、深度殘差生成對抗網絡、原始高清圖像。相關的峯值信噪比(PSNR)與結構相似性在括號中已列出。[4 倍清晰度倍增]

使用了生成對抗網絡之後,系統達到了目前超分辨率技術的最先進水平:

SRGAN[71] 使用了一個判別網絡,它可以區分經過超分辨率處理的圖像與原始照片圖像的區別。藉助這個網絡,系統可以爲大量公開數據集上的採樣圖像提供和照片一樣真實的紋理特徵。

儘管從峯值信噪比(PSNR)標準來看 SRResNet 的表現最佳,但是就畫質而言,SRGAN 的表現纔是最好的,它生成了更好的紋理細節,並且得到了最高的平均主觀意見分(Mean Opinion Score, MOS)。「就我們所知,這是第一個能夠以*4*倍清晰度推理提升逼真自然圖像的框架。」[72]

Amortised MAP Inference for Image Super-resolution[73]:提出了一個計算最大後驗概率(Maximum a Posteriori,MAP)的方法(該方法使用了一個卷積神經網絡)。他們的研究提出了三條優化方法,然而對於每一條來說,其目前在真實圖像數據上的表現都遜於生成對抗網絡。

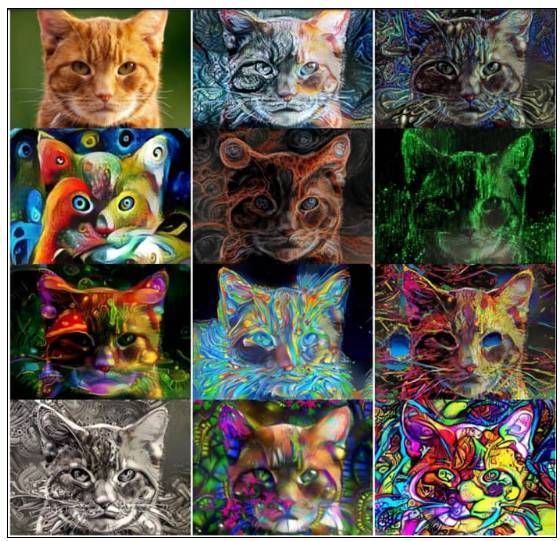

圖 8:風格遷移,圖中顯示的是將不同的風格遷移到一隻貓的照片上(原圖位於左上方),圖片來源 Nikulin & Novakle(2016)。

毫無疑問,風格遷移以新穎的方式使用了神經網絡,從而進入了公衆領域。比較著名的案例如 Facebook 去年進行的整合以及像 Prisma[74] 和 Artomatix[75] 等公司的成果。雖然風格遷移這種技術由來已久,但是直到 2015 年,它可以用神經網絡進行處理的方法才隨着《藝術風格的神經算法》[76] 的發表而被人知曉。從那以後,作爲計算機視覺領域的系列進展,風格遷移的概念得到了 Nikulin 和 Novak[77] 二人的擴展,並且風格遷移也被應用到了視頻領域 [78]。

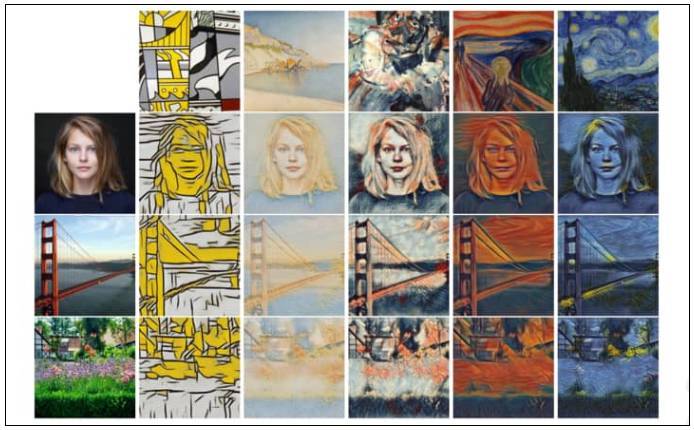

圖 9:風格遷移的其他案例,來源於 Dumoulin et al. (2017, p. 2)[79]。上圖第一行(從左到右)的圖片代表了系統將向原始圖片遷移的藝術風格。圖中第一列(從上到下)的圖片則是將被進行藝術遷移處理的 3 張原始圖片(女性、金門大橋、草地環境)。單個風格遷移網絡在使用條件歸一化後,可以同時捕捉到 32 種風格。圖中顯示的是其中 5 種。全部樣式可在原論文附錄中進行查看。該項工作將會在 2017 ICLR 大會上進行討論。

風格遷移是一個熱門話題,它會在視覺上給人耳目一新的感覺。試想你有一副圖,然後將另一幅圖的風格特徵應用到這幅圖上會怎麼樣,比如用一位著名畫家或某一副名畫的風格來修改你的圖像。就在今年,Facebook 發佈了他們的 Caffe2Go[80],該深度學習系統可以整合到移動設備上。谷歌也發佈了部分有趣的工作,通過結合多種樣式,系統可以創造一種獨一無二的圖像樣式,完整論文參見 [82]。

此外,移動整合、風格遷移技術已經應用在了遊戲產業的創作中。我們團隊的成員最近在 Artomatix 公司創始人兼 CTO Eric Risser 的一個演講中看到,他們已經在討論將風格遷移技術應用於遊戲內容創作了(比如圖像紋理的變化等等)。這種工作會顯著減小傳統圖像紋理設計師的工作。

着色(Colourisation)是指將單色圖像轉換成全綵的過程。最初這樣工作是由人工操作完成的,人們會花非常多的精力去選擇每幅圖中特定像素應該使用的顏色。長久以來,讓畫面變得真實一直是人類着色家的專利,但是到 2016 年,技術的進步讓機器也可能辦到這一點。雖然人類可能無法精準地還原圖像中事物的真實顏色,但是他們可以憑藉自己對真實世界的知識來讓自己的着色在某種程度上看起來是連貫且不奇怪的。

在着色的過程中,網絡會根據其對物體位置、紋理與環境的理解來選擇最可能的顏色添加到圖像上。比如它會學習到皮膚是略帶血色的,天空是帶些藍色的。

下面是年度三項影響力最大的工作:

Zhang 等人 [83] 提出了一個方法,該方法以 32% 的概率成功欺騙了人類測試者,這是一個着色視覺的圖靈測試。

Larsson 等人 [84] 通過使用深度學習來進行直方圖預測,他們讓系統實現了全自動着色功能。

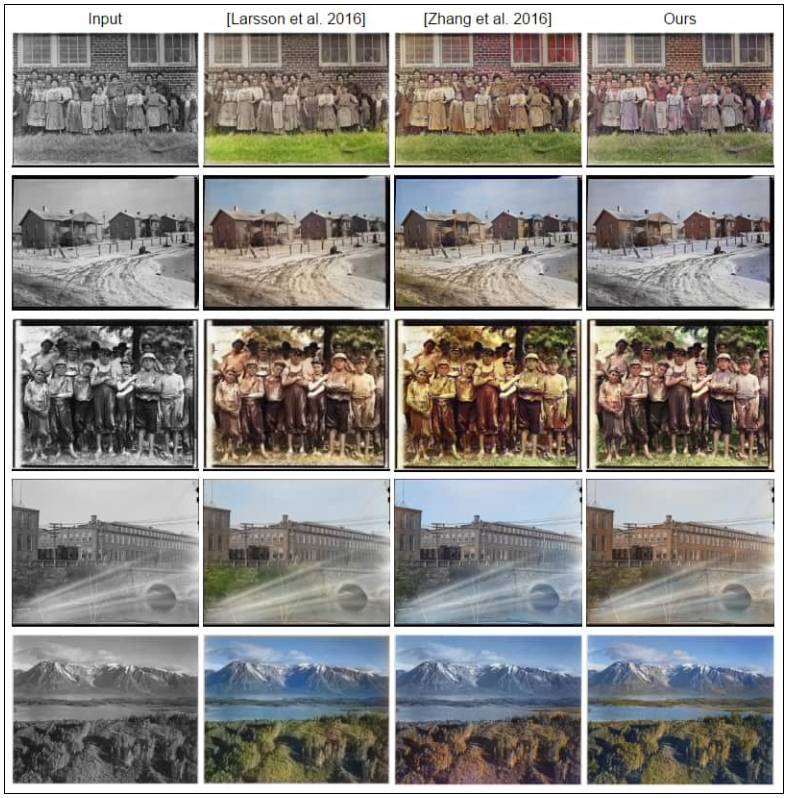

Lizuka, Simo-Serra 和 Ishikawa[85] 展示了一個基於卷積神經網絡的着色模型。該項工作達到了目前最先進的水平。在我們看來,他們的系統表現從質量上來看是最好的,同時其結果看起來也是最真實的,圖 10 提供了對比圖。

圖 10:着色研究成果對比,來源 Lizuka et al. 2016[86]。上圖從上到下,第一列包含的是等待着色的原始單色圖像輸入。其他的幾列展示了 2016 年多個不同研究生成的着色結果。從左到右看,分別是第二列 Larsson et al.[84]、第三列 Zhang et al.[83]、以及 Lizuka, Simo-Serra 和 Ishikawa[85] 的研究成果,也就是圖中被作者稱爲「ours」的那個團隊。縱觀整個比較,第三行(圖中有一羣男孩)的着色差異是最明顯的。對此我們相信 Lizuka 等人的工作(第 4 列)在着色結果上看是領先於其對手的。

「進一步來說,我們的架構可以處理任何分辨率的圖像,這與大多數基於卷積神經網絡的現有技術不同。」

在一次測試模型生成圖像自然程度的實驗中,研究人員向被試者隨機提供一張模型生成的圖像,並提問:「這幅圖在你看來自然嗎?」

實驗結果證明,Lizuka 等人的方法得到了 92.6% 的認可度,基線水準達到了 70%。要知道以當時的技術來看,彩色照片大約在 97.7% 的程度上看起來是自然的。

行爲識別

行爲識別任務有兩個含義,一個是在給定視頻內對一種動作進行分類;最近更多指的是指:算法僅需要觀察一部分場景,就可以在實際動作還沒出現之前便預測出相關的結果。按照這種視角,我們發現,最近的研究試圖將語境因素嵌入算法的決策過程。這一點與計算機視覺的其他領域類似。以下是該領域的部分重要論文:

Long-term Temporal Convolutions for Action Recognition[87] 藉助卷積神經網絡的一個變體和人類動作的時空結構,例如特殊的運動或是持續的動作,來正確識別動作。爲了克服對長時間動作的局部最優時序建模(sub-optimal temporal modelling)問題,作者提出了一個長期時序卷積神經網絡(LTC-CNN),以此來改善行爲識別的精確性。簡單地來說,LTC 可以通過觀察視頻中尺寸較大的部分畫面來識別動作。他們使用並擴展了 3D 卷積神經網絡,使得動作可以在一個更充足的時間範圍內進行表示。

「我們在兩個具有挑戰性的人類行爲識別基準上分別實現了 UCF101 (92.7%)、HMDB51 (67.2%),達到目前最先進的水平。」

Spatiotemporal Residual Networks for Video Action Recognition[88] 將兩種卷積神經網絡的變體應用到了行爲識別中,該系統結合了傳統卷積神經網絡與新近熱門的殘差網絡(ResNets)。這兩種方法的靈感來自神經科學關於視覺皮層的功能假設。比如,在視覺中識別形狀/顏色與行動是互相分離的。論文的作者通過在兩個卷積網絡中加入殘差連接,讓模型有了殘差網絡的優勢。

「這兩個網絡首先分別會自己執行視頻識別任務與最後的分類任務,然後系統會引入 softmax 分值對二者進行融合。迄今爲止,這是應用機器學習進行行爲識別最有效的方法,尤其當訓練數據有限的情況下更是如此。在我們的工作中,我們將圖像卷積網絡直接轉換成了 3D 架構,結果顯示系統在兩種人類行爲識別基準 UCF101 和 HMDB51 上性能大幅提高,分別達到了 94% 和 70.6%」。Feichtenhofer 等人改進了傳統 IDT 方法,結合以上兩種技術得到了更好的結果。

Anticipating Visual Representations from Unlabeled Video[89] 雖然嚴格上來說這不是一篇關於行爲分類的論文,但是它還是非常吸引人。作者提出的模型可以通過分析一個視頻內某個動作發生前(最長可達 1 秒前)的畫面來預測何種動作將有可能會發生。他們選擇了視覺表徵而非逐像素分類的方法,也就是說,程序可以在沒有標註數據存在的情況下工作,這裏利用了深度神經網絡可以進行強大的特徵學習的這一優點 [90]。

「我們方法的關鍵思想在於,我們可以訓練深度網絡,讓它來預測未來可能在圖像中出現的視覺表徵。視覺表徵是一個可靠的預測目標,因爲它們站在比像素層面高的語義層面來編碼圖像。然後,我們在預測得到的表徵上應用識別算法,從而得出對目標和動作的估計。」

Thumos Action Recognition Challenge[91] 的組織者發表了一篇論文,總結了近年來對行爲進行識別的一般方法。文章還提供了從 2013 年到 2015 年挑戰賽的綱要,以及關於如何讓計算機進行行爲識別的一個整體理解。遺憾的是(似乎)去年沒有舉辦該比賽,我們希望 Thumos 行爲識別挑戰有望在今年(2017)迴歸。

原文鏈接:http://www.themtank.org/a-year-in-computer-vision