▷每週一條油管頻道 Arxiv Insights 視頻

原標題'How neural networks learn' - Part II: Adversarial Attacks

翻譯 | 劉寧 校對 | 凡江 整理 | 吳璇

當下的圖像識別技術看似愈發成熟了,但神經網絡還是會犯錯,特別是碰到人爲僞造圖片時,神經網絡基本識別無能:

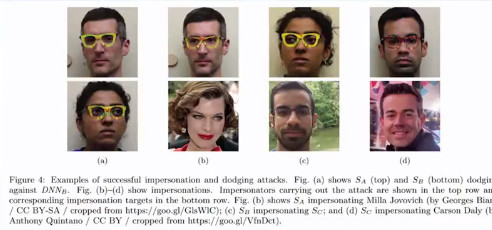

比如你只要帶上這幅特製3D眼睛,在神經網絡的眼裏,你就算已經化成灰了,他根本識別不出來你是誰。

再比如你僞造個車牌,神經網絡直接就懵了,基本上全世界的交通攝像頭都識別不出來你是真是假。

想要騙過神經網絡,也不要什麼超高伎倆,隨便動動手腳,在原圖上增加一點噪音,或是更改一些像素點就成了。但是想騙過人類就難了,我們通常都能知道某張圖是僞造的或是人爲製作出來的。

假如我們輸入一張熊貓的圖片,通過卷積神經網絡的計算,它被歸類爲是熊貓。神經網絡的運作過程是:在神經網絡輸出層中隨機選擇輸出神經元(並非代表熊貓的神經元)→將梯度下降法運用於輸入熊貓圖片的像素點→最大限度地激活目標神經元。但是,如果我們採用調整輸入圖片像素值,就能騙過神經網絡,從而得到錯誤的分類。

對抗樣本不僅可以用於計算機視覺領域,還可以用於自然語言處理領域。像在Amazon,booking,TripAdvisor等網站的信息,大多源於用戶在網站上反饋的評價,評價通常會用感情分析來處理和彙總。僅僅修改評價中的幾個字,就能完全反轉模型對情感的判斷。

本視頻將介紹對抗攻擊及其防禦的相關知識,並從以下幾個方面介紹:

什麼是對抗樣本?

對抗樣本出現在哪些場合?

對抗樣本有什麼特性?

如何防禦對抗樣本?

視頻講解通俗易懂,有興趣鑽研的童鞋可以參考 產生和防禦對抗樣本的新方法 | 分享總結。

提供視頻原址:https://www.youtube.com/watch?v=4rFOkpI0Lcg&t=902s

相關文章:

時間序列預測教程;OpenAI 談對抗樣本:自然語言處理入門 | AI 開發者日報

OpenAI最新研究:「對抗樣本」能輕易黑掉AI系統,如何抵禦?

如何用 Caffe 生成對抗樣本?這篇文章告訴你一個更高效的算法