選自GitHub

機器之心整理

參與:黃小天、蔣思源

今日,機器之心小編在 Github 上發現了一個良心項目:RedditSota 統計了各種機器學習任務的最頂級研究成果(論文),方便大家索引查閱。機器之心對此項目做了介紹。

項目地址:https://github.com//RedditSota/state-of-the-art-result-for-machine-learning-problems

該 GitHub 庫提供了所有機器學習問題的當前最優結果,並盡最大努力保證該庫是最新的。如果你發現某個問題的當前最優結果已過時或丟失,請作爲問題提出來(附帶:論文名稱、數據集、指標、源代碼、年份),我們會立即更正。

這是爲所有類型的機器學習問題尋找當前最優結果的一次嘗試。我們都無法獨自完成,因此希望每一位讀者參與進來。如果你發現了一個數據集的當前最優結果,請提交併更新該 GitHub 項目。

監督學習

NLP

1、語言建模

以下展示了語言建模方面當前頂尖的研究成果及它們在不同數據集上的性能。

論文:DYNAMIC EVALUATION OF NEURAL SEQUENCE MODELS

論文地址:https://arxiv.org/pdf/1709.07432.pdf

實現地址:https://github.com/benkrause/dynamic-evaluation

論文:Regularizing and Optimizing LSTM Language Models

論文地址:https://arxiv.org/pdf/1708.02182.pdf

實現地址:https://github.com/salesforce/awd-lstm-lm

論文:FRATERNAL DROPOUT

論文地址:https://arxiv.org/pdf/1711.00066.pdf

實現地址:https://github.com/kondiz/fraternal-dropout

論文:Factorization tricks for LSTM networks

論文地址:https://arxiv.org/pdf/1703.10722.pdf

實現地址:https://github.com/okuchaiev/f-lm

在語言建模(Language Modelling)的四個頂尖研究成果中,我們看到 Yoshua Bengio 等人的研究 FRATERNAL DROPOUT 在 PTB 和 WikiText-2 數據集上都實現了當前最好的結果。在該篇論文中,Bengio 等人提出了一項叫做 fraternal dropout 的技術,他們首先用不同的 dropout mask 對兩個一樣的 RNN(參數共享)進行訓練,並最小化它們 (pre-softmax) 預測的差異。這樣正則項會促進 RNN 的表徵對 dropout mask 具有不變性。Bengio 等人證明了他們的正則項上界爲線性期望的 droupout 目標,即可以解決 droupout 因訓練和推斷階段上出現的差異而導致的 Gap。

此外,Ben Krause 等人提出使用動態評估來提升神經序列模型的性能。Salesforce 的 Stephen Merity 等人提交的論文 LSTM 語言模型中的正則化和最優化從詞層面的語言建模和調查基於 LSTM 模型中的正則化和最優化等具體問題出發研究更高效的語言建模方法。英偉達的 Oleksii Kuchaiev 等人提出了兩個帶映射的 LSTM 修正單元(LSTMP),並藉此減少參數的數量和提升訓練的速度。

2、機器翻譯

論文:Attention Is All You Need

論文地址:https://arxiv.org/abs/1706.03762

實現地址:https://github.com/jadore801120/attention-is-all-you-need-pytorch、https://github.com/tensorflow/tensor2tensor

論文:NON-AUTOREGRESSIVE NEURAL MACHINE TRANSLATION

論文地址:https://einstein.ai/static/images/pages/research/non-autoregressive-neural-mt.pdf

實現地址:未公佈

在機器翻譯上,我們比較熟悉的就是谷歌大腦 Ashish Vaswani 等人關於注意力機制的研究,該模型在 WMT 2014 英法和英德數據集上都有十分不錯的表現。該研究表明在編碼器-解碼器配置中,顯性序列顯性轉導模型(dominant sequence transduction model)基於複雜的 RNN 或 CNN。表現最佳的模型也需通過注意力機制(attention mechanism)連接編碼器和解碼器。因此谷歌在該篇論文中提出了一種新型的簡單網絡架構——Transformer,它完全基於注意力機制,徹底放棄了循環和卷積。上圖兩項機器翻譯任務的實驗也表明這些模型的翻譯質量不僅十分優秀,同時它們更能並行處理,因此這種模型所需的訓練時間也能大大減少。這篇論文表明 Transformer 在其他任務上也泛化很好,能成功應用到有大量訓練數據和有限訓練數據的英語組別分析任務上。

除了這篇論文,Salesforce 和香港大學等研究者提出了能避免自迴歸(autoregressive)屬性和並行產生輸出的模型,這種模型在推斷時能減少數個量級的延遲。該論文通過三個層面的訓練策略展示了在 IWSLT 2016 英語-德語數據集上產生的大量性能提升,並且在 WMT2016 英語-羅馬尼亞語上獲得了當前頂尖的效果。

3、文本分類

論文:Learning Structured Text Representations

論文地址:https://arxiv.org/abs/1705.09207

實現地址:未公佈

論文:Attentive Convolution

論文地址:https://arxiv.org/pdf/1710.00519.pdf

實現地址:未公佈

愛丁堡大學的 Yang Liu 等人提出了學習結構化的文本表徵,在這篇論文中,他們關注於在沒有語篇解析或額外的標註資源下從數據中學習結構化的文本表徵。雖然目前暫時還沒有相應的實現代碼,不過他們在 Yelp 數據集上準確度能達到 68.6。而另一篇帶注意力的卷積提出了了一種 AttentiveConvNet,它通過卷積操作擴展了文本處理的視野。

4、自然語言推理

論文:DiSAN: Directional Self-Attention Network for RNN/CNN-free Language Understanding

論文地址:https://arxiv.org/pdf/1709.04696.pdf

實現地址:未公佈

悉尼科技大學和華盛頓大學的研究者提出了 DiSAN,即一種爲 RNN/CNN-free 語言理解的定向自注意力網絡。該研究提出了一種新穎的注意力機制,即輸入序列中每個元素之間的注意力是定向和多維的,這是一種對應特徵相連接的注意力。該研究在斯坦福自然語言推理(SNLI)數據集上獲得了 51.72% 的準確度。

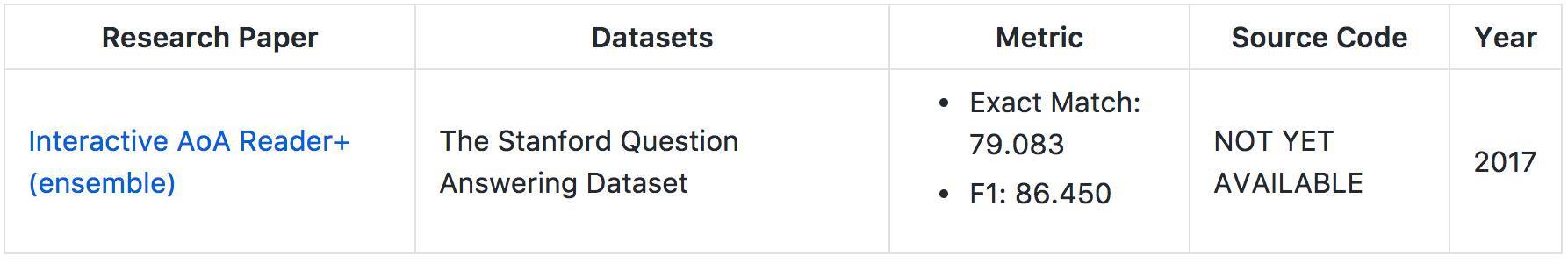

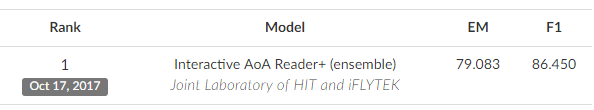

5、問答

論文:Interactive AoA Reader+ (ensemble)

數據集地址:https://rajpurkar.github.io/SQuAD-explorer/

實現地址:未公佈

斯坦福問答數據集(SQuAD)是一個新型閱讀理解數據集,該數據集中的問答是基於維基百科並由衆包的方式完成的。小編並沒有找到該論文,如下 GitHub 地址給出的是該數據集和評估該數據集的模型。

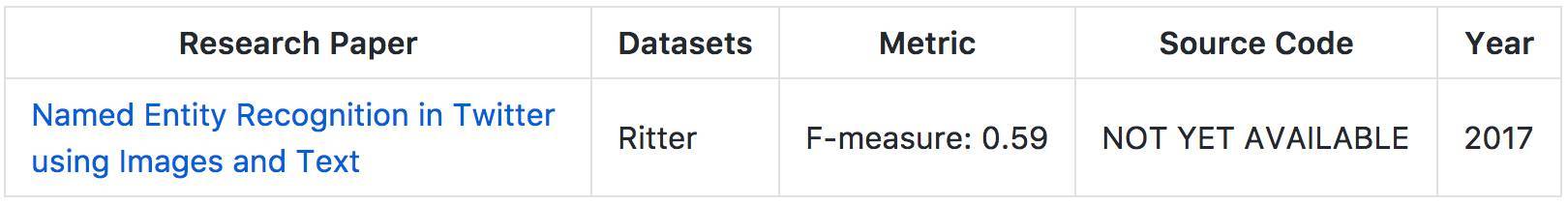

6、命名實體識別

論文:Named Entity Recognition in Twitter using Images and Text

論文地址:https://arxiv.org/pdf/1710.11027.pdf

實現地址:未公佈

波恩大學 Diego Esteves 等研究者在推特上使用圖像和文本進行命名實體識別,在該論文中,他們提出了一種新穎的多層級架構,該架構並不依賴於任何具體語言學的資源或解碼規則。他們的新型模型在 Ritter 數據集上 F-measure 實現了 0.59 的優秀表現。

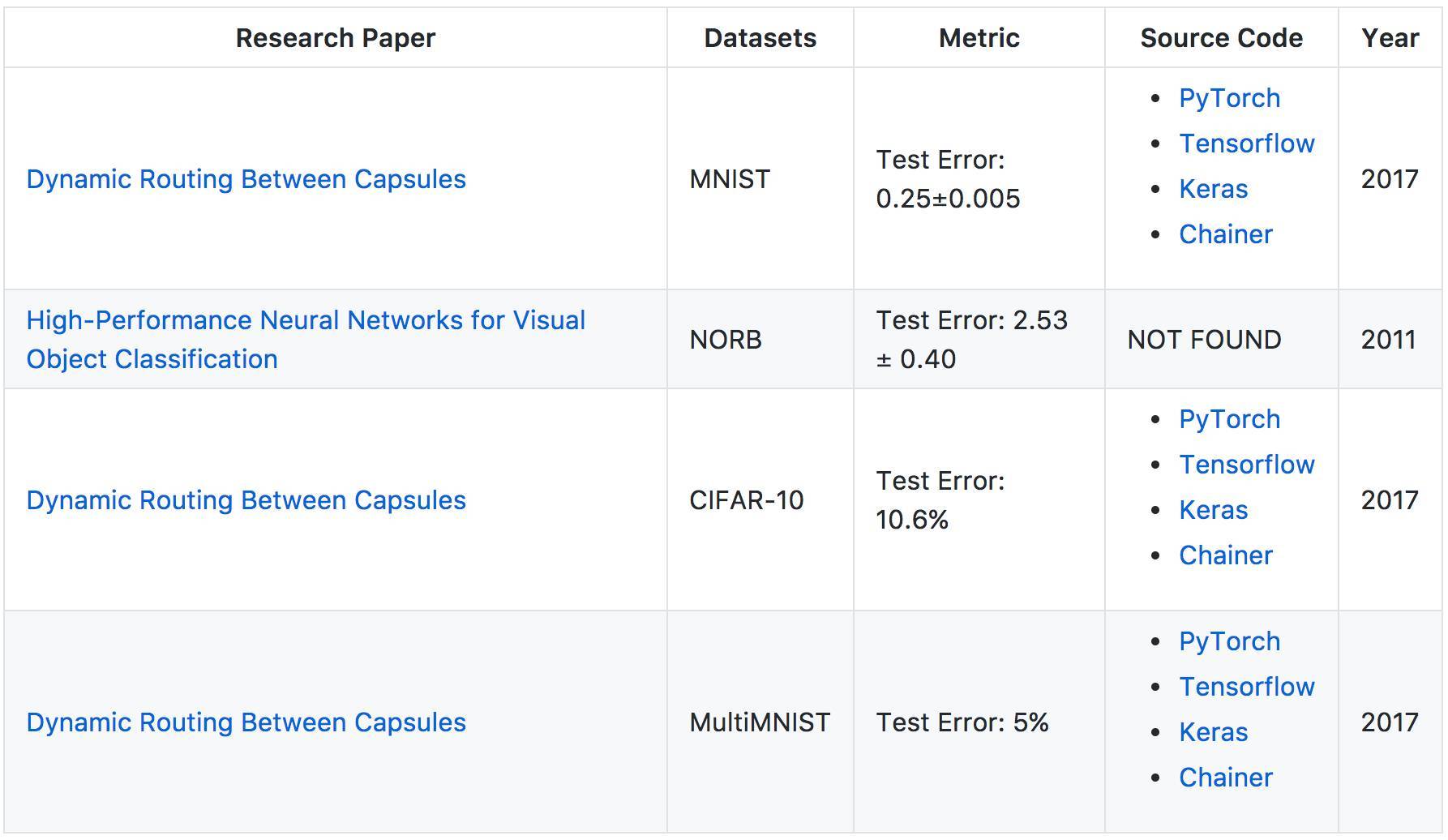

計算機視覺

1、分類

論文:Dynamic Routing Between Capsules

論文地址:https://arxiv.org/pdf/1710.09829.pdf

實現地址:https://github.com/gram-ai/capsule-networks、https://github.com/naturomics/CapsNet-Tensorflow、https://github.com/XifengGuo/CapsNet-Keras、https://github.com/soskek/dynamic_routing_between_capsules

論文:High-Performance Neural Networks for Visual Object Classification

論文地址:https://arxiv.org/pdf/1102.0183.pdf

實現地址:未公佈

在計算機視覺領域中,最近比較流行的論文就是 Geoffrey Hinton 等人提出的 Capsule 動態路由方法,機器之心也曾詳細地解析了該論文與實現。在論文中,Geoffrey Hinton 介紹 Capsule 爲:「Capsule 是一組神經元,其輸入輸出向量表示特定實體類型的實例化參數(即特定物體、概念實體等出現的概率與某些屬性)。我們使用輸入輸出向量的長度表徵實體存在的概率,向量的方向表示實例化參數(即實體的某些圖形屬性)。同一層級的 capsule 通過變換矩陣對更高級別的 capsule 的實例化參數進行預測。當多個預測一致時(本論文使用動態路由使預測一致),更高級別的 capsule 將變得活躍。」

此外,Jurgen Schmidhuber 等人提出了一種視覺目標分類的高性能神經網絡,在該論文中他們提出了一種卷積神經網絡變體的快速全可參數化的 GPU 實現。雖然該論文是在 2011 年提出的,不過它在 NORB 數據集上還是有非常不錯的效果。

語音

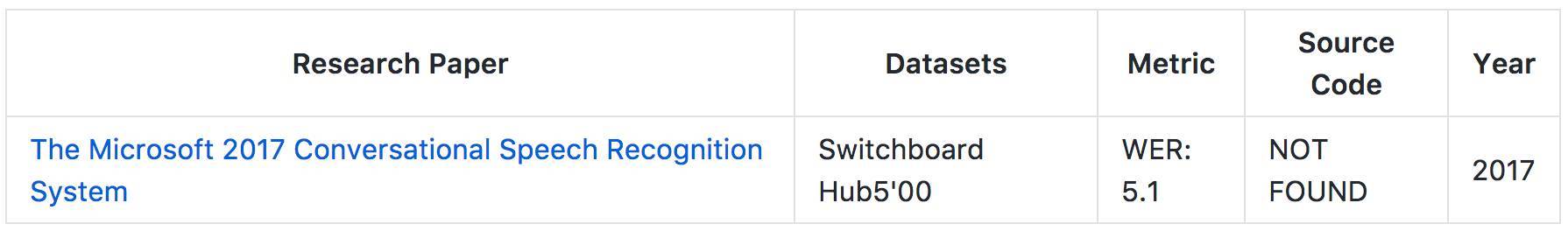

1、ASR

論文:THE MICROSOFT 2017 CONVERSATIONAL SPEECH RECOGNITION SYSTEM

論文地址:https://arxiv.org/pdf/1708.06073.pdf

實現地址:未公佈

本文介紹了微軟對話語音識別系統的 2017 版本。它在原有的模型架構設置中添加了一個 CNN-BLSTM 聲學模型,並且在系統結合之後還添加了一個混合網絡再打分的步驟。結果這一系統在數據集 Switchboard Hub5'00 上取得了 5.1% 的詞錯率。

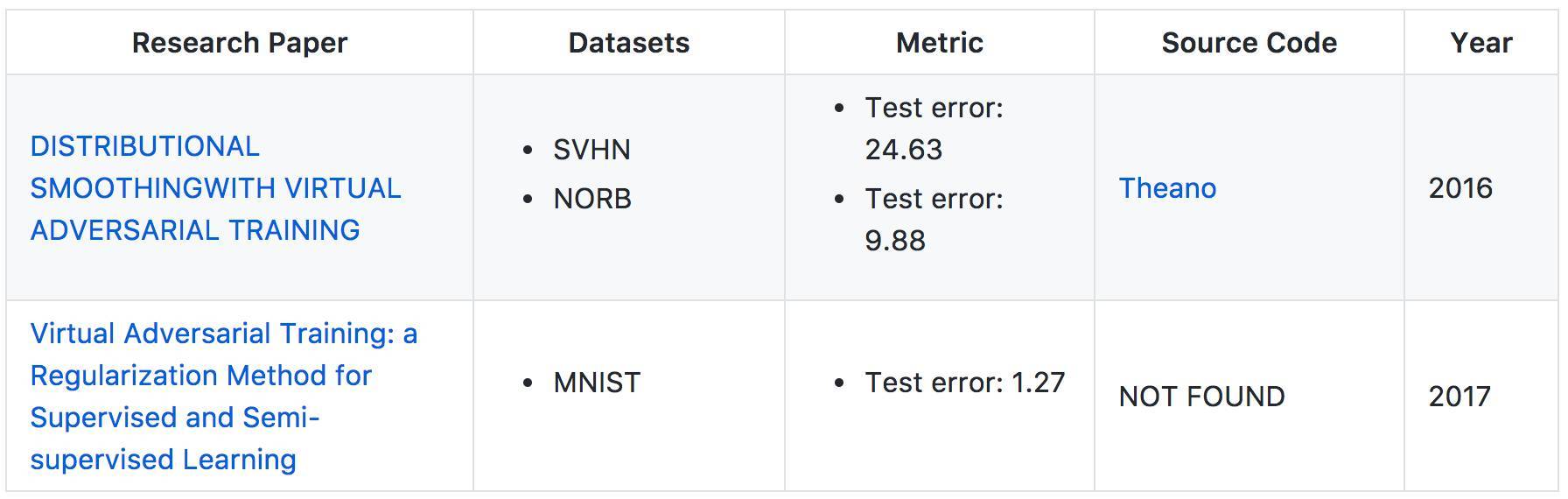

半監督學習

計算機視覺

論文:DISTRIBUTIONAL SMOOTHING WITH VIRTUAL ADVERSARIAL TRAINING

論文地址:https://arxiv.org/pdf/1507.00677.pdf

實現地址:https://github.com/takerum/vat

論文:Virtual Adversarial Training: a Regularization Method for Supervised and Semi-supervised Learning

論文地址:https://arxiv.org/pdf/1704.03976.pdf

實現地址:未公佈

第一篇論文中,日本京都大學提出了局部分佈式平滑度(LDS),一個關於統計模型平滑度的新理念。它可被用作正則化從而提升模型分佈的平滑度。該方法不僅在 MNIST 數據集上解決有監督和半監督學習任務時表現優異,而且在 SVHN 和 NORB 數據上,Test Error 分別取得了 24.63 和 9.88 的分值。以上證明了該方法在半監督學習任務上的表現明顯優於當前最佳結果。

第二篇論文提出了一種基於虛擬對抗損失的新正則化方法:輸出分佈的局部平滑度的新測量手段。由於平滑度模型的指示是虛擬對抗的,所以這一方法又被稱爲虛擬對抗訓練(VAT)。VAT 的計算成本相對較低。本文實驗在多個基準數據集上把 VAT 應用到監督和半監督學習,並在 MNIST 數據上取得了 Test Error 1.27 的優異表現。

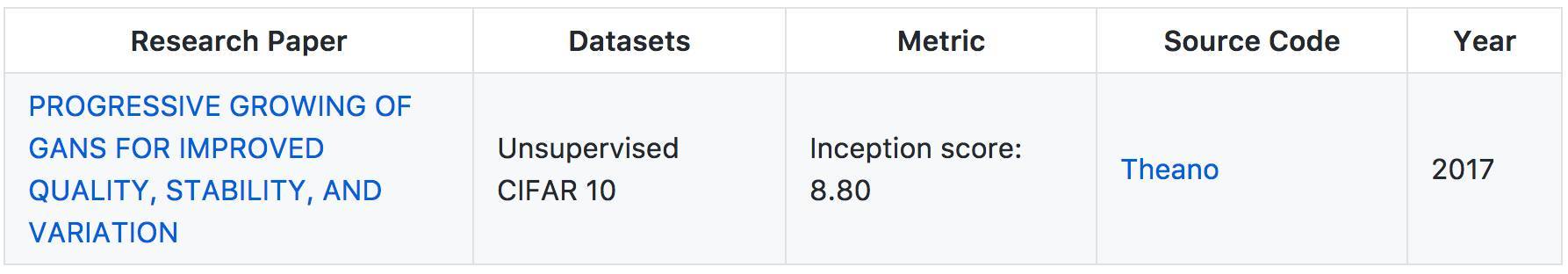

無監督學習

計算機視覺

1、生成模型

論文:PROGRESSIVE GROWING OF GANS FOR IMPROVED QUALITY, STABILITY, AND VARIATION

論文地址:http://research.nvidia.com/sites/default/files/publications/karras2017gan-paper-v2.pdf

實現地址:https://github.com/tkarras/progressive_growing_of_gans

英偉達在本文中描述了一種新的 GAN 訓練方法,其核心思想是同時逐漸地增加生成器與鑑別器的能力:從低分辨率開始,添加持續建模精細細節的新層作爲訓練過程。這不僅加速了訓練,而且更加穩定,獲得質量超出預想的圖像。本文同時提出了一種增加生成圖像變體的簡便方法,並在 CIFAR10 上取得了 8.80 的得分。另外的一個額外貢獻是創建 CELEBA 數據集的更高質量版本。

點擊【閱讀原文】報名參賽,美國賽區報名請點擊大賽首頁 US 進入美國賽區報名通道

責任編輯: