美國時間週四,NIPS 大會走完了日程的一半。工業界的衆多公司搬東西撤出了展覽會場,受邀演講也全部結束。之後亮點除了當地時間週五週六的 Workshop 以外,就是週四下午的四場重要的研討會——從元學習和深度強化學習,到 DeepMind 剛剛公佈的 AlphaZero,以及 Yann LeCun 參加了 NIPS 史上第一次辯論,一天的精彩內容盡在此文中。

Kinds of Intelligence:AlphaZero 成全場焦點,認知科學大牛唱反調

Kinds of Intelligence 主要討論了實現智能的多種途徑,吸引了衆多參會者前來。不少生物界、心理學界和認知科學界的專家分享了人工智能以外的研究。

DeepMind 的 CEO Demis Hassabis 也是此次研討會的嘉賓。Hassabis 上臺時,現場雷動。偌大的會議大廳座無虛席,連走道上都是參會者,逼得保安不得不過來安排下秩序。學術圈的大會熱捧工業界的新星,也只有 DeepMind 能享受這番待遇。

Demis Hassabis

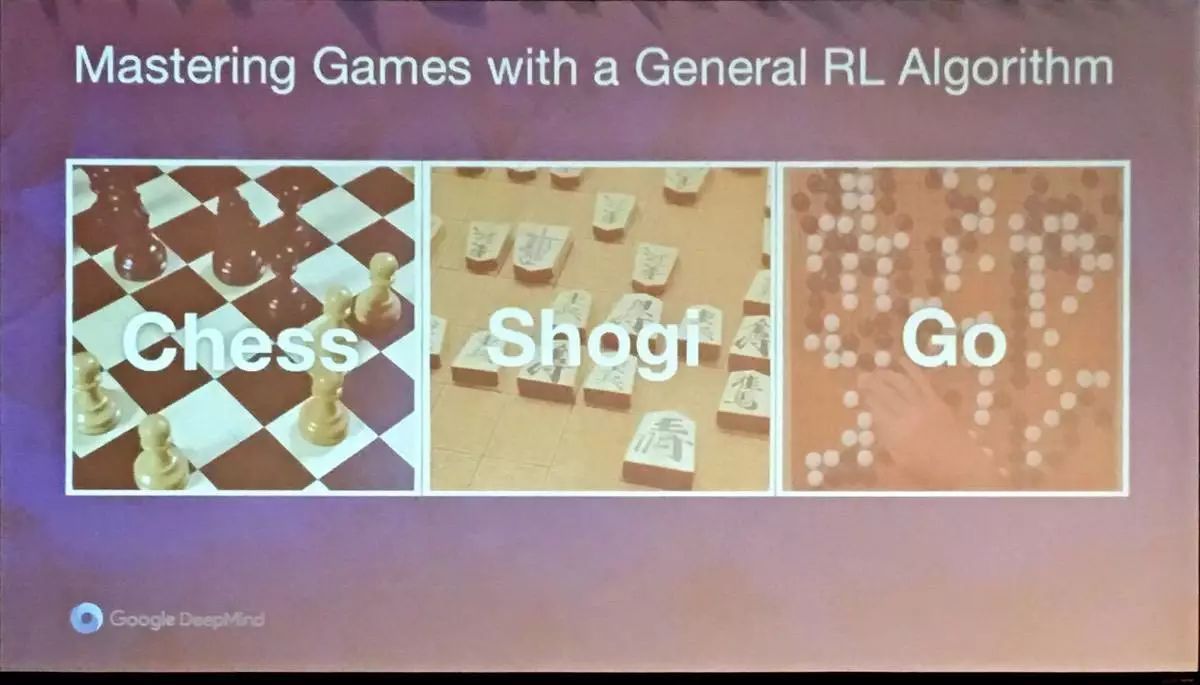

週二,DeepMind 公佈了其圍棋程序的最新迭代 AlphaZero。和 AlphaGo Zero 一樣,AlphaZero 不需要人類的知識,完全靠自我對弈的強化學習,從零開始。不同的是,AlphaZero 擁有更強大的泛化能力,經過不到 24 小時的訓練後,Alpha Zero 可以在國際象棋和日本將棋上擊敗目前業內頂尖的 AI 程序(這些程序早已超越人類世界冠軍水平),也可以輕鬆擊敗訓練 3 天時間的 AlphaGo Zero。

Hassabis 先介紹了 DeepMind 和 AlphaGo 的發展歷程,然後着重介紹了 AlphaZero 是怎麼從圍棋泛化到國象和日本將棋上。

目前最前沿的國象 AI 程序依然使用 Alpha-Beta 搜索和啓發算法。2016 年 TCEC 世界冠軍 Stockfish 是這個領域最好的 AI 程序,但 Stockfish 依然需要大量手動調整,包括棋局表徵、搜索、落子順序、評估以及殘局庫。AlphaZero 呢?只需要基於自我對弈強化學習加自我對弈蒙特卡洛樹搜索即可。同時,AlphaZero 可以完全在這三種不同的棋類遊戲中泛化,三種棋類背後的算法和超參數完全相同。

AlphaZero 的戰績是顯著的:對陣國象 AI 程序 Stockfish 是 28 勝 72 平 0 負;對陣將棋頂尖程序 Elmo 是 90 勝 2 平 8 負;對陣訓練三天的 AlphaGo Zero 是 60 勝 40 負。

Hassabis 提到了有關 AlphaZero 的幾個有趣的事實:下棋的每個決定都需要一定的搜索量。人類一般是 10 次,目前最先進的國象程序是 1000 萬次,AlphaZero 則是 10000 次,介於兩者之間;AlphaZero 下國象中,摒棄了許多人類的招數,比如 Kings Indian Defence、French Defence 和 Queen Pawn Game,這三種都是很常見的國象開局方式;AlphaZero 偏愛長期位置犧牲(long-term positional sacrifices),爲了最後的贏面在前期犧牲掉部分棋子。

擁有更好泛化能力的 AlphaZero 讓很多人相信人類離通用人工智能(AGI)又近了一步。然而,其他幾位受邀嘉賓並不買賬。東海岸的兩位認知科學大牛——紐約大學的 Gary Marcus 和來自麻省理工大學的 Josh Tenenbaum 都不認爲 AlphaZero 代表了 AGI 的研究方向。

Tenenbaum 認爲智能不僅僅是將一個公式計算地特別好,而是思考到底解決什麼樣的問題。他提出了一個非常有意思的想法:建造一個像小孩子一樣學習的機器。

Tenenbaum 向觀衆展示了一個視頻:一個小孩看到大人雙手捧着書,在一個關着門的書櫥前踱步,小孩很自覺地走上前把門打開。這樣的理解能力和操作能力,是機器做不到的。要建造這樣的機器,需要三個步驟:建立一個具備常識的核心;用這個核心學習語言;用語言學習任何東西。

之後登場的 Marcus,更是圈內有名的「辯論手」(詳細參見他十月和 Yann LeCun 的爭論)。此次演講,他還專門爲了 AlphaZero 做了篇 PPT:AlphaZero 只適用於完美信息的遊戲博弈,但並不適合通用人工智能。

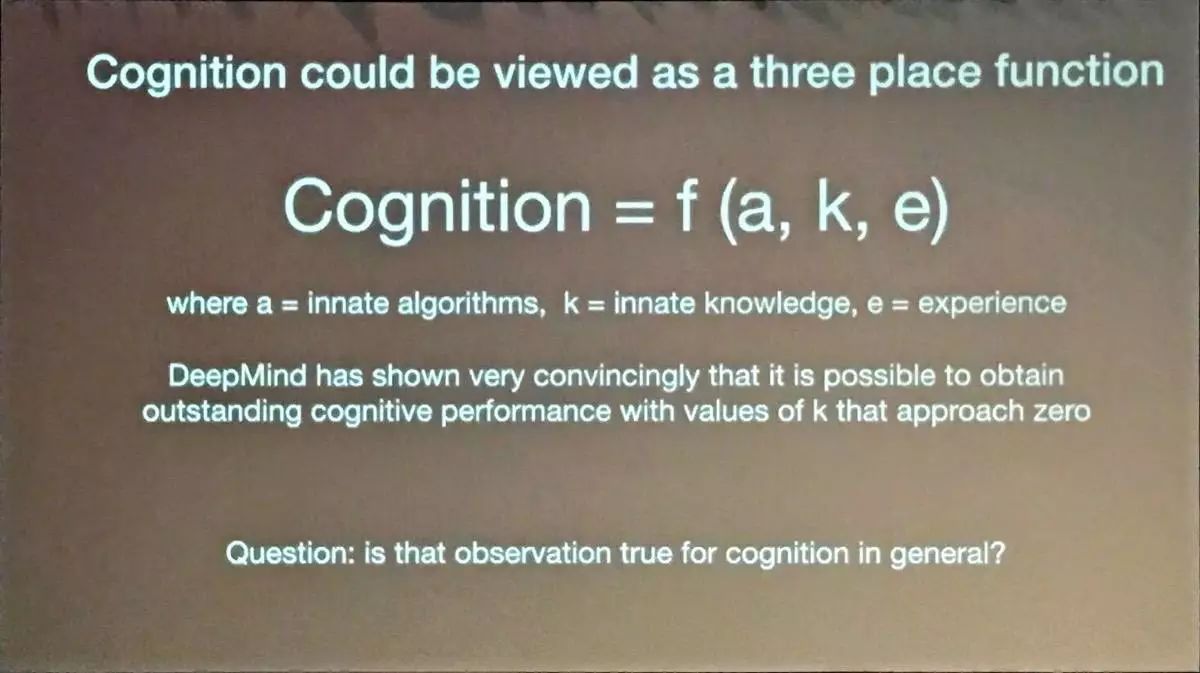

Marcus 提出了一個有關「認知」的公式:Cognition=f(a, k ,e),其中 a 代表先天的算法,k 代表先天知識,e 代表經驗。這個公式同樣可以適用於 AlphaZero。完美信息棋盤博弈獲得成功的條件是棋盤規則+經過人類編程的棋局表徵,a 則是強化學習+蒙特卡洛樹搜索+基於經驗得到的超參數,即使沒有了先天知識 k,AlphaZero 同樣獲得了成功。

但無論是圍棋、將棋、國象,都和生活是不一樣的:棋局是完美信息,但生活是不完美信息;棋局可以被完美模擬,生活卻不可能;棋局裏可以有無限的數據,而生活裏的每個事物的數據量都不多;棋局裏唯一要緊的是盤面狀態,但生活中,什麼都有要緊。

所以,在一個開放的世界裏,先天的算法和先天的知識需求量都會增加,就不是 AlphaZero 可以應付的了。

Marcus 從 DeepMind 中得到的另一個結果是,即使是在完美信息的遊戲中,一些先天的結構依然不可缺少,比如蒙特卡洛樹算法。所以,他強調 AlphaGo Zero 以及 AlphaZero 不是所謂的「零知識」。這裏的「零知識」只針對專有領域知識(domain knowledge),不包括像蒙特卡洛樹搜索這樣經過人類多年研究的算法。

最後,越說越激動的 Marcus 大聲疾呼:「生活不是一場 Kaggle 競賽!」

「在生活中,沒有東西是被整齊的預先包裝好的(像 Kaggle 裏的數據集那樣),沒有人能保證你昨天的挑戰和今天的挑戰一樣,你希望學習的是可以重複使用的技能和知識,並且可以用在未來的挑戰裏,而實現這種可重用性才應該是大家關注的重點。」

除了有關 AlphaZero 的爭論外,這場研討會也提供了其他研究人工智能的思路。

來自加州伯克利大學心理學和哲學教授 Alison Gopnik 倡導將兒童的學習方法與人工智能相結合。Gopnik 是第一位將概率模型應用於兒童學習的認知科學家,特別是使用因果貝葉斯網絡框架。在過去的 15 年中,她將計算模型應用於早期認知發展的許多領域,包括物理和社會概念的學習。

阿蘭圖靈在 1950 年就說過,「與其嘗試模擬成人的大腦,爲什麼不直接創造一個模擬小孩的大腦。」Gopnik 在研究中發現,一個四歲的小孩可以理性地從條件概率推斷複雜的因果結構;在面對新證據後,會整合和推翻先前的知識;推斷出未觀察過的結構;推斷出抽象的分層超假設;在物理、生物和心理學領域推斷出理論知識。

近幾年,越來越多的研究人員發現年紀小的孩子更具有探索性。Gopnik 總結了小孩子的學習特點,除了獎勵機制外還具有很強的求知慾,這些發現都對人工智能研究帶來了一些新的方向和思考。

Interpretable Machine Learning :一場關於機器學習可解釋性的辯論

從左到右:Patrice Simard、Kilian Weinberger、Yann LeCun

近年來,複雜的機器學習模型(如深度神經網絡)在圖像識別、語音感知、語言建模和信息檢索等廣泛的應用方面取得了出色的性能。人們對解釋由這些模型習得的表徵及決策的興趣逐漸增加,也催生了在可解釋機器學習、因果關係、安全 AI、社會科學、自動科學發現、人機交互(HCI)、衆包、機器教學和 AI 道德等方面的研究。這場可解釋機器學習的研討會的目的在於將這些密切相關但往往被孤立的主題聯繫在一起。

可解釋的機器學習,使我們可以參考模型的預測結果,還有可能通過理解模型的結構更好地理解命題本身,例如犯罪預測及公共政策制定等;同時,理解模型本身又可以讓我們可以建立更準確的預測模型;在自動駕駛等領域,我們需要超越現在的「黑箱模型」的可解釋模型來避免罕見但代價慘重的錯誤。

NIPS 可解釋機器學習研討會包含 6 個演講,以及兩場討論,並公開宣佈了一場「可解釋挑戰賽」。(https://community.fico.com/community/xml)。

上半場的演講主要就如何進行可解釋機器學習研究的方法展開,兩位演講者介紹了因果概率關係,以及一種結合物體檢測和 CNN 圖像特徵,生成可理解的物體圖像內容。

可解釋挑戰賽公佈之後進行的第一場小組討論以十分平和的方式展開,Hanna Wallach、Kiri Wagstaff、Suchi Saria、Bolei Zhou 和 Zack Lipton 探討了在進行可解釋研究中常見的問題,以及需要注意的事項,有趣的是在討論的最後,嘉賓們達成了一致,「明確需要進行解釋的對象」非常重要。

在 NIPS 2017 第四日下午的可解釋機器學習專題研討會的最後一個小時,一場辯論點爆了現場的氣氛,並吸引了大量的參會人員現場圍觀。毋庸置疑,這是第四天的 Symposium 中最火爆的一場。

這場 NIPS 有史以來第一場辯論的主題爲「可解釋性在機器學習中是必要的」(Interpretable is necessary in machine learning)。

正方一辯:微軟研究院傑出工程師 Patrice Simard

正方二辯:微軟研究院高級研究員 Rich Caruana

反方一辯:Facebook 人工智能研究部門 (FAIR) 負責人 Yann LeCun

反方二辯:康奈爾大學副教授 Kilian Weinberger

本次辯論由正反方分別陳述各自觀點拉開序幕:

正方一辯 Rich Caruana 觀點陳述:

Caruana 舉了一個例子:醫院用深度神經網絡來決定肺炎病人的住院順序,死亡率高的優先入院。但是,模型通過某項數據發現,患哮喘的人肺炎的死亡率比較低,因爲他們經常會去醫院配藥、做診斷等等,所以很多病情發現的早。那麼按照這個模型的設定,同樣患肺炎的人,患哮喘的人是不是應該排在隊伍的後面。

Caruana 想用這個例子說明,社會中很多基於數據的模型做決定,但往往沒有正確地評估這個模型是否預測出正確的結果。解決的方法有,就是可解釋模型。通過在可解釋機器學習上的研究,他們發現不只是哮喘,心臟病也會降低肺炎病人的死亡率,道理是一樣的。如果不解決可解釋性,根本無法預料這些問題的存在。

反方一辯 Yann LeCun 觀點陳述:

LeCun 的觀點非常直接:世界上有這麼多應用、網站,你每天用 Facebook、Google 的時候,你也沒有想着要尋求它們背後的可解釋性。人類的大腦有限,我們沒有那麼多腦容量去研究所有東西的可解釋性。有些東西是需要解釋的,比如法律,但大多數情況,它們沒有你想象中那麼重要。

LeCun 也舉了個例子:他多年前和一羣經濟學家做了一個模型預測房價。第一個用的簡單的線性預測模型,經濟學家也能解釋清楚其中的原理;第二個用的是複雜的神經網絡,但是效果比第一個好上不少。最後,當這羣經濟學家想要做預測房價的公司時,你猜他們會選擇哪一個?

LeCun 表示,任何時候在這兩種裏做選擇,絕大多數人都會選擇效果好的那一個。很多年裏,我們不知道藥物裏有什麼成分,我們一直在用。最後,LeCun 認爲,整個有關神經網絡是黑箱的故事,事實上,你可以看到,它並不是黑箱,你可以看到所有的參數,你可以做靈敏度分析。我們常常被解釋性所催眠,因爲它讓我們放心。

正方一辯 Patrice Simard 觀點陳述:

Simard 的主要意思是說到機器學習,就應該有一個準確的定義。機器學習的作用是從壞的函數中找到好的函數,我們可以把這個好函數的集合稱爲假設空間(hypothesis space)。很多人覺得深度學習的假設空間是固定的,但假設空間可以變得非常非常大(因爲我們可以定義無限多的問題)。在我們逐步學習了文字,學習語言,學習了各種各樣的東西的過程中,假設空間也在不斷增加,這種小的積累過程讓學習變的更容易,這可以被稱爲結構可解釋性。

Simard 的觀點是,不關心可解釋性的人應該停止來 NIPS 大會解釋最新的假設空間。而關心解釋性的人可以記錄假設空間的進化,讓學習變得可以被解釋,變得更容易。

反方二辯 Kilian Weinberger 觀點陳述:

在現實中,可解釋性並沒有那麼重要。人人都在用很複雜的東西,比如很少有人能夠完全理解英特爾的 i7 芯片的工作原理,但大家都很自然地用,而且很好用。機器學習也是這樣。在一些情況下人們需要可解釋性:一個是需要了解數據,神經科學家和生物學家需要進行研究,但他們其實需要的是敏感性分析 (sensitivity analysis)。他們只是需要知道什麼特徵會如何影響輸出結果。另一個是機器學習 debugging,但這個並不會幫助人們理解機器學習是如何運作的。最後一個是可靠性 (accountability)。不懂的人關心可解釋性是因爲信任度 (trust),正如 80 年代時人們發現乘坐的是女飛行員駕駛的飛機時會下飛機。30 年之後,人們也會覺得害怕自動駕駛汽車的人是很奇怪的。

Kilian 問現場聽衆一個問題——假設你要做心臟病手術:醫生做手術有 10% 的死亡率;而手術機器人只有 1% 的死亡率。當醫生出錯時,醫生可以理解自己犯了什麼錯而機器不會。這種情況下,是選讓醫生動手術還是手術機器人?不出所料,大部分現場聽衆都選擇了使用手術機器人。

在正反雙方進行完觀點陳述後,辯論進入第二個環節:正反雙方互相答辯。雙方就各自的觀點進行了充分且辯證的討論,雙方探討內容包括但不侷限於,因果關係概率的重要性、測試的可靠性問題、結果可複製性問題等。

在辯論的最後一個環節,每位選手要求對對方辯題陳述一個自己認爲最好的觀點:

Yann LeCun:在機器擁有意識之前,機器會一直犯錯。在對部署系統進行測試的時候尤其需要注意,不能忽略常識相關的測試場景。

Patrice Simard:過去神經網絡不好用是因爲數據不夠多,但越來越多的數據會讓模型的各種性能,包括可解釋性也變得更好。

Kilian Weinberger:當人看到機器學習算法進行決策的時候,我們會用人的思維去理解機器;可解釋性可以讓我們理解機器的運轉方式與人不一樣。

Rich Caruana :人們介意的是準確度,而並不是很介意是否可以解釋,可能只有科學家會爲了完善理論而傾向可解釋的模型。

Meta Learning:四大門派的觀點衝突和 Schmidhuber 的驕傲

Meta-learning 專題研討會開始於對當前深度學習模型複雜度的探討:超參數的調試與網絡結構直接決定了訓練的最終效果,但是這兩部分的選擇隨着深度學習的發展變得愈加繁重。想象一下從相對簡單的 5 層 LeNet 到異常複雜的 GoogleNet,雖然模型的結果得到了令人驚訝的提升,但是其複雜的程度不再是幾個工程師或是學者可以輕易接受的。Meta-learning 正是對這樣的關鍵問題進行的研究,儘管目前學界並未在 Meta-learning 的定義上達成一致,但是無論從何種角度出發最終的目標均是一致的:成熟的 Meta-learning 方法可以減輕工程師和學者在應用與研究過程中對模型調試的壓力,從而將精力集中在解決主要問題上。本次研討會從以下 4 個角度出發,對未來 Meta-learning 的發展進行探討。

Evolving Optimization 主張學習算法的結構是最爲重要的研究方向,因此這一流派認爲對於任意的學習問題,主要的學習框架應由人來構建,而其餘的任務則交給計算機來完成。事實上,當我們回顧所有成熟的工程問題時,我們會發現人們在解決這些問題時只需要將時間與精力投入在高層次的框架設計上,其中的細節均由計算機依照優化的目標迭代設計。爲什麼在機器學習的問題上我們還不能達到這樣的程度呢?被廣泛接受的說法是通用的機器學習算法的搜索空間巨大,在有限的時間與資源下難以尋找到最優的方法。正是針對這一問題,Evolving 流派認爲從遺傳的角度來尋找構建 Meta-learning 系統是合適的。

Bayesian Optimization 認爲在學習過程中 (Hyperparameters) 對超參數的調整效率是極低的,且代價是極爲昂貴的。考慮 (Model Selection) 模型選擇的問題,研究者根據有限的數據反覆嘗試不同的參數組合去選擇在當前數據集支撐下的最優模型,如果不考慮根據常識經驗得到的通用設置,得到最優解的時間顯然是隨着超參數數目指數級增加的。通過 Bayesian Optimization 的方法,同時進行 exploration 和 exploitation,尋找最優參數的過程將有可能得到加速。值得一提的是,使用 Bayesian Optimizaiton 理念的 AutoNet 工具包是第一個在深度學習競賽中獲勝的 AutoML 工具包。

Gradient Descent 方面認爲 Meta-learning 可以有三種方法實現: 1> Model Based、2> Metric based、3> Optimization Based。在目前的研究中,這三種方法並沒有優劣之分,各有千秋。同時,優秀的學習被定義爲成功地融合學習算法結構、優化學習所需要的數據以及優化方法的細節,缺少任一項學習的效果均會大打折扣。Meta-learning 應當被定義爲從通用的學習目標開始,收到特定的(設計好的)影響後逐漸變爲專精的學習過程。而真正的端到端學習則是機器具有能力計算並學習任意的模型,從而有目的地解決不同問題。

Reinforcement Learning 認爲在學習中要解決特定的問題,則必須在學習之前獲得足夠正確的先驗知識。這一點明顯的反映在獎勵函數 (Reward Function) 的設計上,一旦獎勵函數被正確的設計,整個學習過程並不需要過多的人爲干預。於是,能否正確的建立關於學習的模型成爲了 Meta-learning 的關鍵。設計獎勵函數的做法,往往也被稱爲引入 inductive bias,即將人爲的經驗加入到機器的學習過程中從而加速學習正確目標的過程。然而,這種做法的正確性也得到了討論:往往人爲設計的獎勵函數僅考慮到與目標的契合,而忽略了與 agent 行爲的一致性。這種失配被稱爲 Preferences-Parameters Confound。

顯然,這四個角度對於 Meta-learning 的理解各有側重,甚至存在不少衝突的觀點。在 Juergen Schmidhuber 教授的演講中,他針對真正的端到端學習給出了自己的定義。而在接下來 Satinder Singh 教授的演講中,Singh 教授直言不諱,劃掉了 PPT 中的 Meta-learning 字樣:看過剛剛 Schmidhuber 教授的演講,我自覺不足以在這裏討論 Meta-learning 的話題,接下來只側重 Reinforcement Learning。由此可見對於這樣仍然未被完全定義的領域中,不同的學者對於 Meta-learning 的看法有多麼大的分歧。當然,正是這樣的分歧與爭論不斷推動着 Meta-learning 向前發展。

Juergen Schmidhuber

Deep Reinforcement Learning - DRL 的泛化之路

自從 AlphaGo 在 2016 年、2017 年戰勝了李世乭和柯潔後,深度強化學習受到了越來越多的關注。本次 NIPS 大會期間,DeepMind 公佈的 AlphaZero 更是讓深度強化學習的分享備受期待。

第一位演講者是來自 Google DeepMind 的 David Silver,演講題目「AlphaZero - 不用人類知識來駕馭棋類比賽」。David Silver 是倫敦大學學院的計算機科學教授,目前在 Google DeepMind 任職,是 Alpha 系列程序的核心研究者。

在演講中,他首先介紹了圍棋的特點,強調圍棋比起其他棋類可以有更多的變化。然後話鋒一轉進入演講的主角 Alpha 系列的發展。作爲第一個擊敗人類世界冠軍的程序,AlphaGo 包含兩個不同的神經網絡:策略網絡和價值網絡,再結合著名的蒙特卡洛樹搜索來完成訓練。同 AlphaGo 相比,它的迭代版本 AlphaGo Zero 採用了第一法則學習原理。該方法相比之前主要有如下四個特點:1. 無人類數據;2. 無人工特徵; 3. 單獨的神經網絡; 4. 簡單搜索。可以看出比起上一代 AlphaGo Zero 有了相當程度的簡化,此時演講者指出了他的重要觀點:越簡單,越廣泛(Less complexity → More generality)。接着 Silver 介紹了 AlphaGo Zero 的兩種新的神經網絡,其中策略網絡用來預測圍棋如何下子,而價值網絡負責預測獲勝者,二者的合成被應用在 ResNet 上。至於新的搜索方法,在 AlphaGo 中主要採用 Search-based policy improvement 和 Search-based policy evaluation 兩個角度來完成強化學中的 Search-based policy 迭代。

在對原理有了大概的介紹後,Silver 作了 AlphaGo Zero 與之前版本的性能對比。其中 AlphaGo Zero 三天可以超過 AlphaGo Lee,21 天可以超過 AlphaGo Master,在 40 天的訓練後就可以擊敗世界冠軍。在訓練過程中研究者發現一個有趣的現象,AlphaGo 好像逐漸學會了一些特定棋譜,並熱衷於把它們應用於比賽。

接下來,最新的版本 AlphaZero 讓棋類比賽更加簡單。AlphaZero 通過 200 到 400 次不等的迭代就已經可以分別在國際象棋(Chess),將棋(Shogi),和圍棋(Go)中擊敗現有最強的棋類算法。其中象棋需要 4 小時,將棋需要 2 小時,擊敗 AlphaGo Lee 僅僅需要 8 小時訓練。AlphaZero 的具體信息雖然這次並沒有透露,但其強大的能力讓我們對深度強化學習多了一份期待。最後演講者再次點題,堅持簡單的算法可以應用於更多的場景。

之後的提問環節,有觀衆對完全沒有人類知識表示不解。這裏 Silver 給出解釋,在模型的輸入信息中除了包含規則外還有一定很簡單的圍棋的輸入和輸出範例,但數量很少,而且非常初級。

第二個重要演講者 Joelle Pineau,是來自麥吉爾大學計算機科學系的教授。她的主要研究方向集中在「Planning, learning and decision-making,mobile robotics, human-robot interaction」和「adaptive treatment design。」

這次她的研究是關於學術研究的心病 - 論文復現。由於研究者操作手段不同,信息不對稱等,對結果復現造成了很大的難度。這個問題嚴重困擾科學研究,讓成果驗證更難。根據自然雜誌的調查結果,在 1576 名受試者中,有 52% 的人認爲這是一個嚴重的危機,38% 的人相信這有影響。在另一項調查中,大部分科研工作者都經歷過無法復現別人成果的痛苦。其中化學領域超過 80%,生物領域達到 77%,物理和工程相關領域則有近 70%。在我們關注的機器學習領域,這種現象同樣達到了 80%。所以演講者希望有一個統一的平臺來進行強化學習的研究。通過這個平臺,研究者可以在上面調用已有的標準的底層算法,利用統一的硬件配置和算力支撐,來讓強化學習的研究更加可控,對模型參數的調整也會更容易。

雖然研究者的要求千差萬別,但最底層的需求實際上存在大量重複。如果統一該過程,並且對操作結果進行詳細描述,那會使人工智能研究成果更容易驗證,大大降低了偶然性和噪音。這種平臺的推廣無疑可以加速人工智能的發展,也是現在各個學科的一個發展方向。

接着作者介紹了兩個易混淆的概念:Reproducibiity 和 Replication。其中 Replication 只是簡單的重做實驗,在需要相同的數據,達到同樣結果時需要,這種情況只適合與模擬數據,在現實生活中往往很難達到。Reproducibillity 就複雜的多,從精確的數據,參數的調整,清晰的文章和代碼,計算資源,系統配置等都需要達到一定要求,纔可能把原有文章的結果應用到新的地方。

最後,演講者呼籲我們都能投身於一個 ICLR 2018 Reproducibility Challenge 的活動,互相監督驗證,共同驗證已有的文章結果,來促進人工智能技術的進一步發展。

接下來的亮點在於來自卡內基梅隆大學的教授 Ruslan Salakhutdinov 的精彩分享:神經地圖-深度強化學習的結構化記憶。

Ruslan Salakutdinov 是最近在機器學習領域很活躍的年輕教授,主要研究方向包括 Deep Learning、Probabilistic Graphical Models 和 Large-scale Optimization。這次他爲我們帶來了如何給強化學習植入記憶,讓其在不同環境下都可以表現優異。

演講從監督學習開始,認爲大部分深度學習都可以表示爲監督學習:映射並輸出一個結果(Mapping and input to an output)。接着演講談到了環境對強化學習的影響,主要體現在三個方面:1. 環境是隨着時間動態變化的;2. 動作對環境的影響存在不確定的滯後性;3. 對環境的標註是成本高昂而且很難實現的。爲了解決這些潛在的問題,Ruslan 根據前人的工作,引入了記憶的概念來調整 agent,使得物體進入新環境時候有更好的表現。但外在記憶的引入又引起了新的問題,比如效率較低(因爲要記錄所有的信息)。作者的解決方案是利用位置感知記憶(Location Aware Memory),這種方法可以起到一種類似於「地圖」的效果,幫助 agent 進行探索。而且該方法在輸出結果時候是利用稀疏的結果作爲輸出,可以防止 agent 過多的重寫記憶。之後演講者又詳細介紹了這種神經網絡的具體細節,比如 operations, global read, context read 和 write。並且舉了不同的迷宮例子,還可以應用與定位問題和自然語言理解問題。在演示的環境,可以清晰看出之前有過「記憶」的 agent 進入新模型時候往往會根據經驗有更好的表現。

這種方法的理想狀態,agent 會擁有讀寫自己外在記憶的能力,而外在記憶會和知識庫互相轉化,並且 agent 也可以用不同的方法來和知識庫進行理性的交流(reason communication)。最後演講者還提出了一些展望,他表示希望進行不同 agents 共享記憶進行交流的嘗試。

之後的提問環節,有聽衆詢問是否可以構造更高級更抽象的模型?演講者給出了肯定的答案,但也承認在現階段距離該目標還很遠。在一個開放的環境(open domain)會遇到更多的困難。另一位聽衆問到是否可以嘗試不同的環境,比如新環境和舊環境有較大差別的情況?有過嘗試但目前環境的差別並不是全方位的,演講者希望有更多更好的模擬器出現。

這次的 DRL 分享反應出研究方向主要集中在深度強化學習的泛化和性能的提升。DeepMind 採用了簡化算法的方法,而 Ruslan 則選擇了引入記憶的途徑。殊途同歸,但該方向取得的進展無疑是激動人心的。