項目地址:https://github.com/dkarunakaran/entity_recoginition_deep_learning

引言

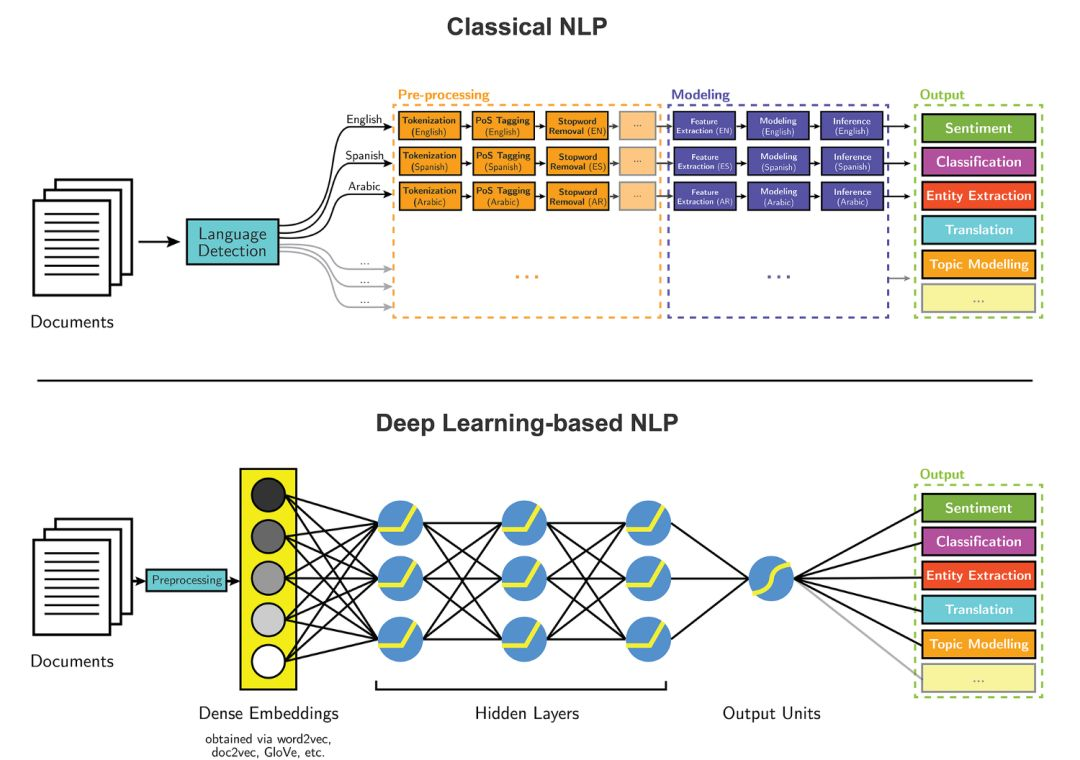

文本實體提取是自然語言處理(NLP)的主要任務之一。隨着近期深度學習領域快速發展,我們可以將這些算法應用到 NLP 任務中,並得到準確率遠超傳統方法的結果。我嘗試過分別使用深度學習和傳統方法來提取文章信息,結果非常驚人:深度學習的準確率達到了 85%,遠遠領先於傳統算法的 65%。

本項目的目標是把文章中的每個單詞標註爲以下四種類別之一:組織、個人、雜項以及其他;然後找到文中最突出的組織和名稱。深度學習模型對每個單詞完成上述標註,隨後,我們使用基於規則的方法來過濾掉我們不想要的標註,並確定最突出的名稱和組織。

在這裏要感謝 Guillaume Genthial 這篇關於序列標註的文章(https://guillaumegenthial.github.io/),本項目建立在這篇文章的基礎之上。

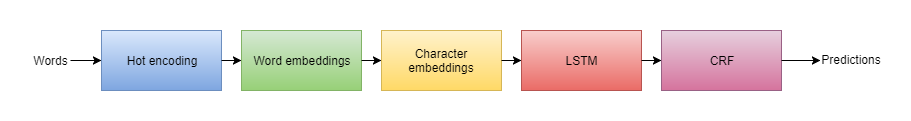

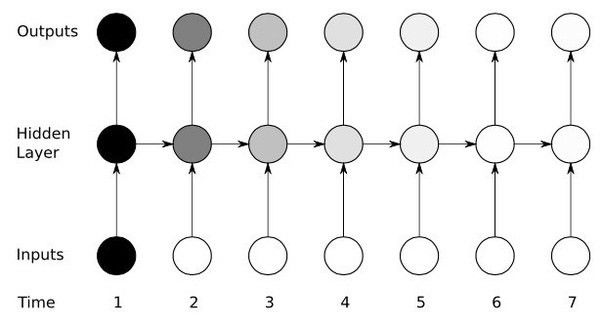

模型的高級架構

架構

上圖是對每個單詞進行分類標註的模型高級架構。在建模過程中,最耗時間的部分是單詞分類。我將解釋模型的每個組成部分,幫助讀者對模型組件有一個全面的、更高層次的理解。通常,模型組件可分爲三部分:

單詞表徵:在建模第一步,我們需要做的是加載一些預訓練詞嵌入(GloVe)。同時,我們需要從字符中提取出一些含義。

語境單詞表徵:我們需要利用 LSTM,對語境中的每一個單詞得到一個有意義的表徵。

解碼:當我們得到表示單詞的向量後,我們就可以用它進行預測。

hot encoding(用數值表示單詞)

深度學習算法只接受數值型數據作爲輸入,而無法處理文本數據。如果想要在大量的非數值場景下使用深度神經網絡,就需要將輸入數據轉變數值形式。這個過程就是 hot encoding。

下面是一小段實現 hot encoding 的代碼示例:

word_counts = Counter(words)sorted_vocab = sorted(word_counts, key=word_counts.get, reverse=True)int_to_vocab = {ii: word for ii, word in enumerate(sorted_vocab)}vocab_to_int = {word: ii for ii, word in int_to_vocab.items()}同樣地,我們必須獲取輸入數據中的所有字符,然後將其轉化爲向量,作爲字符嵌入。

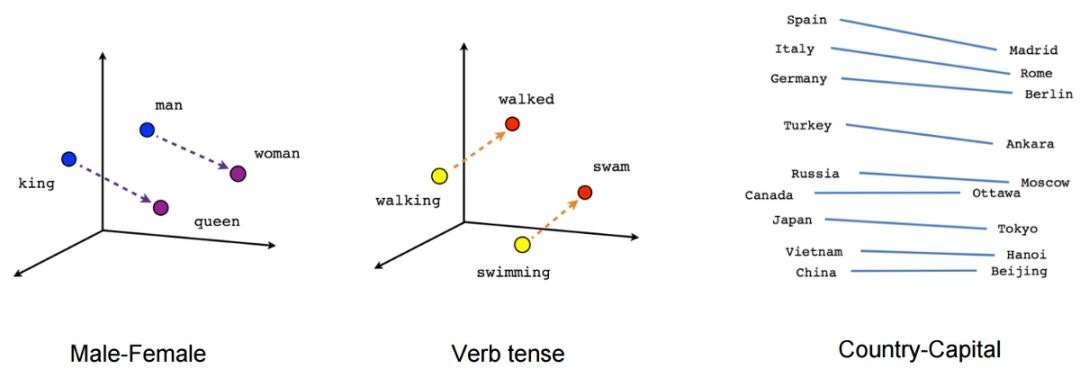

單詞嵌入 & 字符嵌入

單詞嵌入是處理文本問題時使用的一種通過學習得到的表徵方式,其中含義相同的單詞表徵相近。通常,我們利用神經網絡來實現單詞嵌入,其中使用的單詞或短語來自於詞庫,並需要轉變爲實數構成的向量形式。

但是,在數據集上生成詞向量計算成本很高,我們可以使用一些預訓練的單詞嵌入來避免這個問題:比如使用斯坦福大學的 NLP 研究者提供的 GloVe 向量。

字符嵌入是字符的向量表徵,可用於推導詞向量。之所以會使用字符嵌入,是因爲許多實體並沒有對應的預訓練詞向量,所以我們需要用字符向量來計算詞向量。這裏有一個詳細介紹字符嵌入的在線資源:http://minimaxir.com/2017/04/char-embeddings/。

LSTM

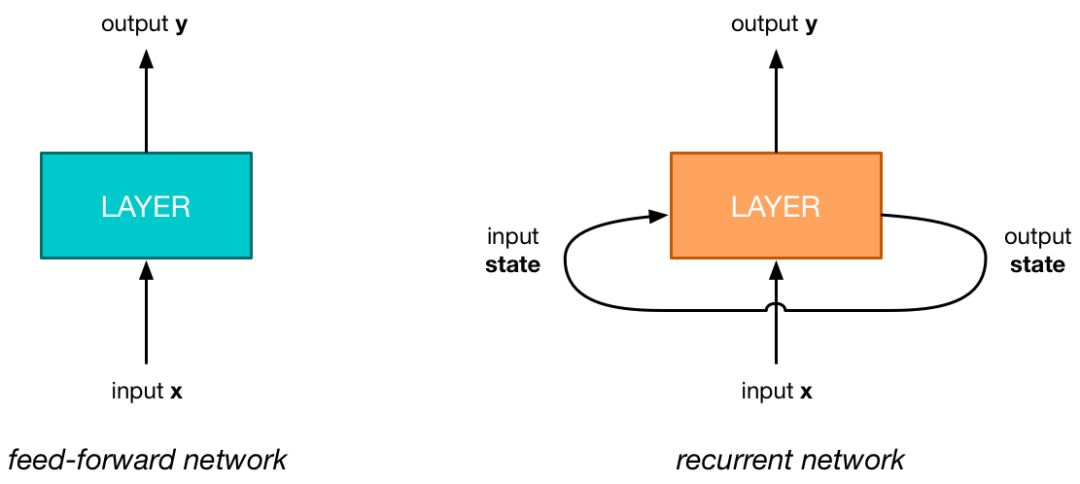

傳統神經網絡 VS 循環神經網絡(RNN)

循環神經網絡(RNN)是人工神經網絡的一種,用於序列數據中的模式識別,例如文本、基因組、手寫筆跡、口語詞彙,或者來自傳感器、股市和政府機構的數值型時間序列數據。它可以「理解」文本的語境含義。

RNN 神經元

LSTM 是一種特殊的循環神經網絡,相比於簡單的循環神經網絡,它可以存儲更多的語境信息。簡單的 RNN 和 LSTM 之間的主要區別在於它們各自神經元的結構不同。

對於語境中的每一個單詞,我們都需要利用 LSTM 得到它在所處語境中的有意義表徵。

如果你想了解更多關於 LSTM 和 RNN 的知識,可以參閱以下文章

1. http://karpathy.github.io/2015/05/21/rnn-effectiveness (http://karpathy.github.io/2015/05/21/rnn-effectiveness/)

2. https://deeplearning4j.org/lstm.html

條件隨機場(CRF)

在預測標註最後的解碼步驟中,我們可以使用 softmax 函數。當我們使用 softmax 函數時,它給出單詞屬於每個分類的概率。但這個方法給出的是局部選擇;換句話說,即使我們從文本語境中提取出了一些信息,標註決策過程依然是局部的,我們在使用 softmax 激活函數時,並沒有使用到鄰近單詞的標註決策。例如,在「New York」這個詞中,我們將「York」標註爲一個地方,事實上,這應該可以幫助我們確定『New』對應地方的開始。

在 CRF 中,我們的輸入數據是序列數據;同時,我們在某個數據點上進行預測時,需要考慮先前文本的語境。在本項目中,我們使用的是線性鏈 CRF。在線性鏈 CRF 中,特徵只依賴當前標註和之前的標註,而不是整個句子中的任意標註。

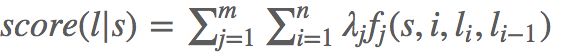

爲了對這個行爲建模,我們將使用特徵函數,該函數包含多個輸入值:

句子s

單詞在句子中的位置i

當前單詞的標註 l_i

前一個單詞的標註 l_i−1

接下來,對每一個特徵函數 f_j 賦予權重 λ_j。給定一個句子s,現在我們可以根據下式計算s的標註l:對句子中所有單詞的加權特徵求和。

基於詞性標註的特徵函數示例

如果 l_i= ADVERB,且第 i 個單詞以『-ly』結尾,則 f_1(s,i,l_i,l_i−1)=1,否則取 0。如果對應的權重 λ1 爲正,且非常大,那麼這個特徵基本上就表示我們傾向於把以『-ly』結尾的單詞標註爲 ADVERB。

如果 i=1,l_i= VERB,且句子以問號結尾,則 f_2(s,i,l_i,l_i−1)=1,否則取 0。如果對應的權重 λ2 爲正,且非常大,那麼這個特徵基本上就表示我們傾向於把疑問句的第一個單詞標爲 VERB。(例,「Is this a sentence beginning with a verb?」)

如果 l_i−1= ADJECTIVE,且 l_i= NOUN,則 f_3(s,i,l_i,l_i−1)=1,否則爲0。對應權重爲正時,表示我們傾向於認爲名詞跟在形容詞之後。

如果 l_i−1= PREPOSITION,且 l_i= PREPOSITION,則 f_4(s,i,l_i,l_i−1)=1。此函數對應的權重 λ4 爲負,表示介詞不應該跟着另一個介詞,因此我們應該避免這樣的標註出現。

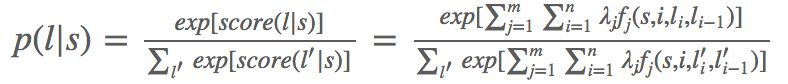

最後,我們可以通過取指數和歸一化,將這些得分轉換爲 0~1 之間的概率 p(l|s)。

總之,要建立一個條件隨機場,你只需要定義一組特徵函數(可以依賴於整個句子、單詞的當前位置和附近單詞的標註)、賦予權重,然後加起來,最後如果有需要,轉化爲概率形式。簡單地說,需要做兩件事情:

1. 找到得分最高的標註序列;

2. 在全體標註序列上求出概率分佈。

幸運的是,TensorFlow 提供了相關的庫,幫助我們可以很容易地實現 CRF。

log_likelihood, transition_params=tf.contrib.crf.crf_log_likelihood(scores, labels, sequence_lengths)CRF r 相關閱讀資料:

1. http://blog.echen.me/2012/01/03/introduction-to-conditional-random-fields/

2. http://homepages.inf.ed.ac.uk/csutton/publications/crftut-fnt.pdf

模型的運行原理

對於每一個單詞,我們希望建立一個向量來捕捉其意義以及和任務相關的特徵。我們將該向量構建爲 GloVe 單詞嵌入與包含字符級特徵的向量的級聯。我們還可以選擇使用一些特定的神經網絡,自動提取出這些特徵。在本文中,我們將在字符層面上使用雙向 LSTM 算法。

我們將 CONLL 數據集中的所有單詞都進行 hot-encode,這些單詞都在 GloVe 單詞嵌入中有對應的實體。如上文所述,神經網絡只接受向量,不接受文本,因此我們需要將單詞轉換爲向量。CONLL 數據集包含單詞及其對應標註。在 hot encoding 後,單詞和標註都被轉換成了向量。

用於 hot encoding 單詞及其對應標註的代碼:

with open(self.filename) as f: words, tags = [], [] for line in f: line = line.strip() if (len(line) == 0 or line.startswith("-DOCSTART-")): if len(words) != 0: niter += 1 if self.max_iter is not None and niter > self.max_iter: break yield words, tags words, tags = [], [] else: ls = line.split(' ') word, tag = ls[0],ls[-1] if self.processing_word is not None: word = self.processing_word(word) if self.processing_tag is not None: tag = self.processing_tag(tag) words += [word] tags += [tag]用於提取單詞、標註和字符向量的代碼:

if vocab_chars is not None and chars == True: char_ids = [] for char in word: # ignore chars out of vocabulary if char in vocab_chars: char_ids += [vocab_chars[char]]if lowercase: word = word.lower()if word.isdigit(): word = NUMif vocab_words is not None: if word in vocab_words: word = vocab_words[word] else: if allow_unk: word = vocab_words[UNK] else: print(word) print(vocab_words)if vocab_chars is not None and chars == True: return char_ids, wordelse: return word現在,我們使用 TensorFlow 內置的函數加載單詞嵌入。假定 embeddings 是一個 GloVe 嵌入的 numpy 數組,其中 embeddings[i] 表示第 i 個單詞的向量形式。

L = tf.Variable(embeddings, dtype=tf.float32, trainable=False)pretrained_embeddings = tf.nn.embedding_lookup(L, word_ids)現在,我們可以構建根據字符得到的單詞嵌入。這裏,我們不需要任何預訓練字符嵌入。

_char_embeddings = tf.get_variable( name="_char_embeddings", dtype=tf.float32, shape=[self.config.nchars, self.config.dim_char])char_embeddings = tf.nn.embedding_lookup(_char_embeddings, self.char_ids_tensor, name="char_embeddings")s = tf.shape(char_embeddings)char_embeddings = tf.reshape(char_embeddings, shape=[s[0]*s[1], s[-2], self.config.dim_char])word_lengths = tf.reshape(self.word_lengths_tensor, shape=[s[0]*s[1]])cell_fw = tf.contrib.rnn.LSTMCell(self.config.hidden_size_char, state_is_tuple=True)cell_bw = tf.contrib.rnn.LSTMCell(self.config.hidden_size_char, state_is_tuple=True)_output = tf.nn.bidirectional_dynamic_rnn( cell_fw, cell_bw, char_embeddings, sequence_length=word_lengths, dtype=tf.float32)一旦得到了單詞表徵,我們就可以直接在詞向量序列上運行 bi-LSTM,得到另一個向量序列。

cell_fw = tf.contrib.rnn.LSTMCell(self.config.hidden_size_lstm)cell_bw = tf.contrib.rnn.LSTMCell(self.config.hidden_size_lstm)(output_fw, output_bw), _ = tf.nn.bidirectional_dynamic_rnn( cell_fw, cell_bw, self.word_embeddings, sequence_length=self.sequence_lengths_tensor, dtype=tf.float32)output = tf.concat([output_fw, output_bw], axis=-1)output = tf.nn.dropout(output, self.dropout_tensor)現在,每個單詞都和一個向量對應,其中向量記錄了這個單詞的含義、字符和語境。我們使用向量來做最後的預測。我們可以使用全連接神經網絡求出一個向量,該向量中每個條目對應每個標註的得分。

W = tf.get_variable("W", dtype=tf.float32, shape=[2*self.config.hidden_size_lstm, self.config.ntags])b = tf.get_variable("b", shape=[self.config.ntags], dtype=tf.float32, initializer=tf.zeros_initializer())nsteps = tf.shape(output)[1]output = tf.reshape(output, [-1, 2*self.config.hidden_size_lstm])pred = tf.matmul(output, W) + bself.logits = tf.reshape(pred, [-1, nsteps, self.config.ntags])最後,我們使用 CRF 方法來計算每個單詞的標註。實現 CRF 只需要一行代碼!下面的代碼計算出了損失,同時返回了在預測時很有用的 trans_params。

log_likelihood, _trans_params = tf.contrib.crf.crf_log_likelihood(self.logits, self.labels_tensor, self.sequence_lengths_tensor)self.trans_params = _trans_paramsself.loss = tf.reduce_mean(-log_likelihood)現在,我們可以定義我們的訓練算子:

optimizer = tf.train.AdamOptimizer(self.lr_tensor)self.train_op = optimizer.minimize(self.loss)一旦我們定義好模型,在數據集上完成很少的幾次迭代,就可以得到訓練好的模型了。

如何使用訓練好的模型

TensorFlow 提供了存儲模型權重的功能,這樣我們就可以在之後的場景中復原訓練好的模型。無論什麼時候需要進行預測,我們都可以加載模型權重,這樣就不需要重新訓練了。

def save_session(self): """Saves session = weights""" if not os.path.exists(self.config.dir_model): os.makedirs(self.config.dir_model) self.saver.save(self.sess, self.config.dir_model)def restore_session(self, dir_model): self.saver.restore(self.sess, dir_model)每篇文章都被分解爲單詞再輸入到模型中,然後經過上文所述一系列過程,得到輸出結果。模型最終輸出結果將每個單詞分爲 4 類:組織、個人、雜項以及其他。這個算法通過基於規則的方法過濾結果,然後進一步正確提取出文本中最突出的名稱和組織,它並沒有達到 100% 的準確率。

原文鏈接:https://towardsdatascience.com/entity-extraction-using-deep-learning-8014acac6bb8